なぜAIに“日本語”を学習させるのか? 35種類のLLMで実験し分析 東工大などが研究報告:Innovative Tech(AI+)

第261回自然言語処理研究発表会において、東京工業大学と産業技術総合研究所に所属する研究者らは、大規模言語モデル(LLM)に日本語を学習する効果について実験結果を基に評価した研究報告を発表した。

Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

9月3日に開催の第261回自然言語処理研究発表会において、東京工業大学と産業技術総合研究所に所属する研究者らが発表した「LLMに日本語テキストを学習させる意義」は、大規模言語モデル(LLM)に日本語を学習する効果について実験結果を基に評価した研究報告である。

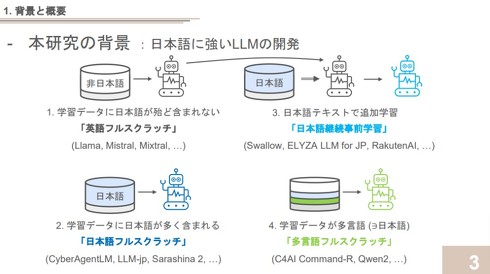

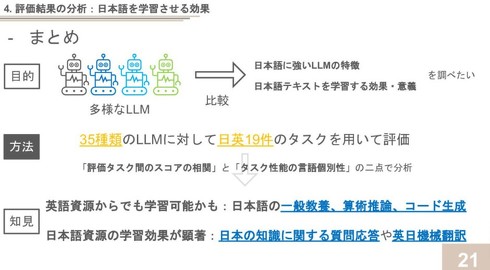

この研究では、35種類のLLMに対して日本語と英語の19種類のタスクを用いて評価を実施し、その結果を詳細に分析。評価に用いたLLMは、学習データや構築手法によって大きく4つのカテゴリーに分類される。

- 「英語フルスクラッチ」は英語中心のデータで学習されたモデル(Llama 3など)

- 「日本語フルスクラッチ」は日本語中心のデータで学習されたモデル(CyberAgentLM 2など)

- 「日本語継続事前学習」は英語モデルを日本語データで追加学習したモデル(Japanese Stable LMなど)

- 「多言語フルスクラッチ」は多言語データで学習されたモデル(Qwen 2など)

これらの多様なモデルを評価することで、日本語学習の効果をさまざまな角度から検証する。

評価タスクは、百科事典的知識・常識、読解、論理推論・算術推論、要約・翻訳、一般教養、コード生成など、幅広い能力を測定するものが選ばれた。これらのタスクの多くは日本語版と英語版に対応するものが用意され、言語間での性能比較が可能になっている。

分析の結果、いくつかの知見が得られた。まず、日本語の一般教養、算術推論、コード生成などの能力は、英語資源のみからでも獲得できる可能性を示唆した。これらのタスクでは、日本語版と英語版で強い相関を確認できた。

例えば「JMMLUとMMLU」(一般教養)、「JHumanEvalとHumanEval」(コード生成)、「MGSMとGSM8K」(算術推論)などのタスクペアで、英語版を元に構築した日本語版タスクである点に留意する必要はあるが、相関係数が0.9以上の相関を確認した。

一方、日本の知識に関する質問応答(NIILCなど)や英日機械翻訳(WMT20-en-jaなど)のタスクでは、日本語資源を学習させることで顕著な性能向上を確認。これらのタスクは他のタスクとの相関が比較的低く、日本語特有の学習効果が現れていると解釈できる。

この研究は、日本語LLMの開発において重要な指針を提供している。英語資源からでも獲得可能な能力(一般教養や算術推論、コード生成など)と、日本語資源の学習が特に効果的な能力(日本の知識に関する質問応答や英日機械翻訳)を明らかにしたことで、効率的なモデル開発の方向性を示唆した。

また、能力因子も特定しており、各因子を強化するための適切な学習データの選択など、今後のLLM開発戦略に有用な指針となる可能性がある。

論文はこちら。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

「大規模言語モデルの開発」に関するまとめ資料 東工大・岡崎教授が公開 全85ページ

「大規模言語モデルの開発」に関するまとめ資料 東工大・岡崎教授が公開 全85ページ

東京工業大学情報理工学院の岡崎直観教授は、大規模言語モデル(LLM)の開発に関する現状や課題などをまとめた資料を公開した。 “著作権への配慮を徹底した”画像生成AI、日本のAIベンチャーが公開 日本語対応で商用利用OK

“著作権への配慮を徹底した”画像生成AI、日本のAIベンチャーが公開 日本語対応で商用利用OK

画像生成AIの開発を手掛けるAI Picassoは、学習に対する透明性が高い画像生成AI「CommonArt β」を公開した。 松尾研、フルスクラッチ開発のLLMを公開 得意なのは“共感”と“思いやり”

松尾研、フルスクラッチ開発のLLMを公開 得意なのは“共感”と“思いやり”

東京大学の松尾・岩澤研究室はフルスクラッチで開発した大規模言語モデル(LLM)の「Tanuki-8×8B」を公開した。 “純粋な国産AI”誕生 ハードもデータも全部日本製 スパコン「富岳」で開発

“純粋な国産AI”誕生 ハードもデータも全部日本製 スパコン「富岳」で開発

スーパーコンピュータ「富岳」で学習をした日本語特化の大規模言語モデルを開発した──東京工業大学と東北大学、富士通、理化学研究所、名古屋大学、サイバーエージェント、Kotoba Technologiesの合同研究チームは、そんな発表をした。 スパコン「富岳」で作るLLM研究の現状 富士通は生成AIビジネスをどう戦うのか

スパコン「富岳」で作るLLM研究の現状 富士通は生成AIビジネスをどう戦うのか

生成AIブームの今、注目のキーワードが「基盤モデル」だ。各AIベンダーたちの間で基盤モデルの開発競争が激化する中、それぞれの開発状況や強みを探っていく。今回は、富士通に話を聞いた。