“純粋な国産AI”誕生 ハードもデータも全部日本製 スパコン「富岳」で開発

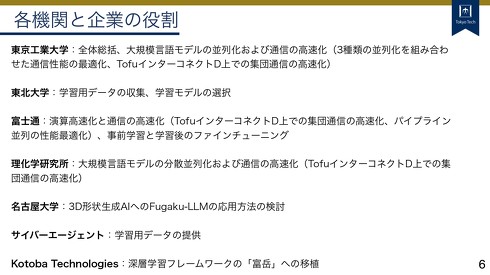

スーパーコンピュータ「富岳」で学習をした日本語特化の大規模言語モデルを開発した──東京工業大学と東北大学、富士通、理化学研究所、名古屋大学、サイバーエージェント、Kotoba Technologiesの合同研究チームは、そんな発表をした。

スーパーコンピュータ「富岳」で学習をした日本語特化の大規模言語モデル(LLM)が誕生した。東京工業大学と東北大学、富士通、理化学研究所、名古屋大学、サイバーエージェント、AIベンチャー企業のKotoba Technologies(東京都港区)の合同研究チームは5月9日、富岳で開発したLLM「Fugaku-LLM」を発表した。パラメータ数は130億。GitHubやHugging Faceで公開しており、研究や商業目的で利用できる。

LLMの学習にはGPUを使うのが一般的だ。しかし、世界中でLLMの開発競争が起こっており、最新のGPUを大量に入手するのは困難な状況に陥っている。そんな中、東京工業大学と東北大学、富士通、理化学研究所の研究チームでは富士通製の国産CPUを中央演算処理装置に使う富岳で、LLMの開発を進める研究を2023年5月に開始。7月には名古屋大学とサイバーエージェント、Kotoba Technologiesも参加した。

約1年の歳月を経て開発した、Fugaku-LLMの研究成果は主に2点ある。1つ目は富岳の計算・通信性能の向上だ。富岳はCPUベースのスーパーコンピュータなので、LLMを開発する上では最適化を行う必要があった。研究チームでは、深層学習フレームワーク「Megatron-DeepSpeed」を富岳へ移植してこれに対応。結果、当初は110秒かかっていた行列演算を18秒まで高速化することに成功した。

学習の際には富岳の1万3824台の計算ノード(富岳全体の約10分の1の数)で分散処理させていたため、ノード間の通信速度もより高い速度が求められた。この点については、富士通の高速ネットワーク「TofuインターコネクトD」を使うことで、当初より3倍高速化させることができたとしている。

2つ目の成果は、学習に使ったデータセットを一から独自で構築した点だ。このため、全学習工程を把握できており、透明性と安全性に優れているという。データセットのボリュームは約4000億トークン(おおよそ単語数の意)に及び、約60%が日本語コンテンツで、他に英語、数学、コードなどを含んでいる。LLMの性能指標「Japanese MT-Bench」の評価では、独自データで学習した他の国産LLMよりも高性能であり、人文社会分野では「GPT-4」に引けを取らないスコアを出したという。

研究チームをリードした東京工業大学学術国際情報センターの横田理央教授は「今回、外国製のGPUに頼らず、国産のハードウェアでAIモデルを一から開発できた。ハードウェア含め、純粋な国産AIモデルはFugaku-LLMが初めてかと思う」と成果を説明する。

左から、東京工業大学学術国際情報センターの横田理央教授、東北大学大学院情報科学研究科の坂口慶祐准教授、富士通人工知能研究所の白幡晃一シニアプロジェクトディレクター、理化学研究所計算科学研究センター高性能ビッグデータ研究チームの佐藤賢斗チームリーダー、サイバーエージェントAI事業本部AI Labリサーチサイエンティストの佐々木翔大さん、 Kotoba Technolgiesの小島熙之CEO、名古屋大学大学院工学研究科の西口浩司准教授(理化学研究所計算科学研究センター松岡聡センター長はオンラインで参加)

GPU市場は現状、米NVIDIA一強ともいえる環境だ。今回の研究成果によって、今後“富岳でのLLM開発”が国産LLM開発において選択肢に入ってくるのか。横田教授は「非常に重要な点。他の企業もGPU開発を進めているが、開発者視点では、NVIDIA製品を使った環境が整っているので(使い続けるのが)一番楽だと思う」と話す。

一方「その居心地のいい環境を抜け出すことも重要だと思っていて、富岳はその中でもかなりチャレンジングな部類だった。しかし、結果的に今回のような成果が上がり、(課題を)克服できることを示した。これをきっかけにNVIDIA以外のプロセッサも試す流れになればいいかなと思っている」と続けた。

理化学研究所計算科学研究センターの松岡聡センター長はこの質問に対して「今回の技術については、このAIモデルに限定されるものではなく、学習という面でさまざまなAIモデルに適用できる。まだ認可はされていないし、実現できるか明言はできないが、もし“次世代の富岳”ができれば、そこにも同じ技術は適用できる。あらゆるAIモデルの学習で、汎用的なソリューションを提供できるのが今回の成果だ」と話した。

「(今回の成果は)AIを使っていかにサイエンスにイノベーションを起こしていくかという『AI for Scienbce』などの観点での根幹的な技術になる。また、各組織負担で日本における研究開発体制と、データアセットを用意できたのもの大きい。このように、今回の成果はAIモデルを一つ作っただけというわけではなく、さまざまな波及効果があると考えている。ぜひこのAIモデルを使っていただいて、Fugaku-LLMの発展に協力してもらえると幸いだ」(松岡センター長)

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

なぜ日本はGPUのない「富岳」でLLMを研究するのか 外国に後れを取らないための“現実的な理由”

なぜ日本はGPUのない「富岳」でLLMを研究するのか 外国に後れを取らないための“現実的な理由”

日本では今、スパコン「富岳」を使ってLLMの研究・開発を進めている。深層学習においてはGPUを使うのが一般的だが、なぜGPUのない富岳を使うのか。そこには現実的な理由があった。 スパコン「富岳」で作るLLM研究の現状 富士通は生成AIビジネスをどう戦うのか

スパコン「富岳」で作るLLM研究の現状 富士通は生成AIビジネスをどう戦うのか

生成AIブームの今、注目のキーワードが「基盤モデル」だ。各AIベンダーたちの間で基盤モデルの開発競争が激化する中、それぞれの開発状況や強みを探っていく。今回は、富士通に話を聞いた。 ELYZA、新たな日本語言語モデルを一般公開 同社「日本語ならGPT-3.5を上回る性能」 商用利用も可

ELYZA、新たな日本語言語モデルを一般公開 同社「日本語ならGPT-3.5を上回る性能」 商用利用も可

東大発のAIスタートアップ企業であるELYZAは、商用利用可能な日本語の大規模言語モデル(LLM)「ELYZA-japanese-Llama-2-13b」を公開した。日本語性能の評価では「GPT-3.5(text-davinci-003)」を上回るという。 OpenAIが日本を選んだ真意 会見で語った「東京拠点、立ち上げのワケ」

OpenAIが日本を選んだ真意 会見で語った「東京拠点、立ち上げのワケ」

米OpenAIの日本法人であるOpenAI Japanは4月15日、アジア初の拠点を東京都に開設した。発表会見に登壇した、本社のブラッド・ライトキャップCOOは「日本はわれわれにとって、重要な市場である」と強調し、日本進出の意気込みを話した。 ネコとAIだけが暮らす世界は幸せか? 遊びやエサを与える自律ロボとネコが過ごす実験 英国チームが検証

ネコとAIだけが暮らす世界は幸せか? 遊びやエサを与える自律ロボとネコが過ごす実験 英国チームが検証

英ノッティンガム大学に所属する研究者らは、AIが猫を幸せにできるのかを確かめるため、「クローバー」「パンプキン」「ゴーストバスター」という名前の3匹の猫が、12日間にわたって1日6時間、自律ロボットと過ごした実験の様子を報告した研究を発表した。