iPhone 14で高速動作する軽量AIモデル、Sakana AIが開発 知識蒸留の新手法「TAID」採用

AIベンチャーのSakana AIは、小規模言語モデル(SLM)「TinySwallow-1.5B」を開発したと発表した。大規模言語モデル(LLM)の知識を効率的にSLMに転移できる新技術「TAID」を開発し、これを利用し作成した。

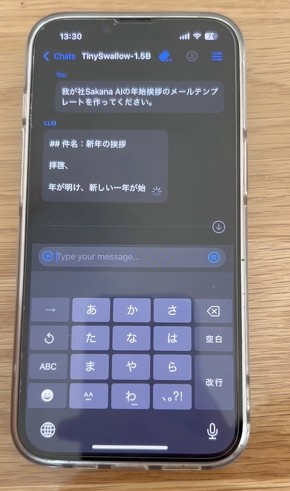

AIベンチャーのSakana AI(東京都港区)は1月30日、小規模言語モデル(SLM)「TinySwallow-1.5B」を開発したと発表した。大規模言語モデル(LLM)の知識を効率的にSLMに転移できる新技術「TAID」(Temporally Adaptive Interpolated Distillation)を利用し作成したSLMで、デモ動画ではiPhone 14上で高速動作する様子を確認できる。

SLMとは「Small Language Model」の略称で、小さいパラメータ数を持つAIモデルを指す。消費する計算リソースが少ないため、スマートフォンなどの端末上でも動かせる他、特定のタスクに特化したファインチューニングを施しやすいのも特徴だ。

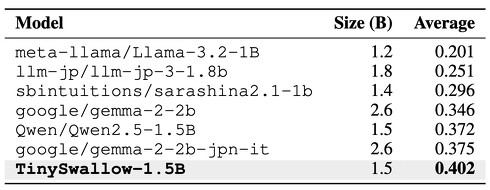

TinySwallow-1.5Bは、東京科学大学のLLM「Swallow」の開発チームと共同で開発。TAIDを活用し、320億パラメータを持つLLMから知識を段階的に移行して、約1/20の規模(15億パラメータ)に圧縮した。性能面では、米Metaの「Llama-3.2-1B」や米Googleの「Gemma-2-2B」などの代表的なSLMを上回り、同規模帯では最高水準の日本語性能を記録したという。

また、小型軽量化したことで、iPhone 14上でもオフライン動作で文章の高速生成を実現。スマートフォンなどのエッジ環境でも実用的に使えることをデモ動画でアピールしている。TinySwallow-1.5BはHugging Face Hubで公開中で、指示学習済みのAIモデル「TinySwallow-1.5B-Instruct」も提供している。

新しい知識蒸留手法「TAID」とは?

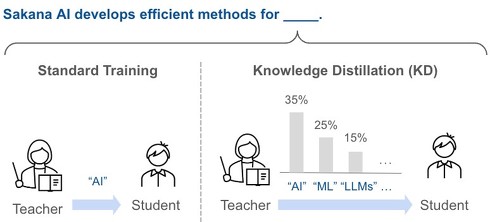

高性能なSLMを構築する手法の一つに「知識蒸留」がある。これは、高性能な教師モデル(LLM)の出力確率分布を生徒モデル(SLM)に学習させ、正解データだけでなく教師モデルの推論プロセス(考え方)も移行させる方法だ。通常の学習方法よりも、SLMに知識を詰め込めるため性能の向上が見込める一方、教師モデルと生徒モデルの能力差が大きすぎると、学習がうまく進まない課題もあった。

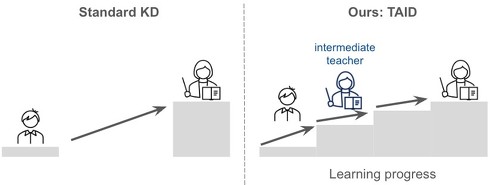

TAIDは、この能力差を段階的に埋めることを狙っている。生徒モデルの学習度合に合わせ「中間教師モデル」を少しずつ高度化し、最終的には大規模教師モデルの知識へ到達するような仕組みを取っている。実験結果も、TAIDは教師モデルのサイズが大きいほど、生徒モデルの性能が向上することを確認できたという。

Sakana AIはTAIDについて「人間の教育で生徒のレベルに合わせ、徐々に難易度を上げる方法を取り入れた」と表現。今後もSLMの研究開発を進めていくと表明している。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

“人工生命”を発見する自動AIシステム「ASAL」 Sakana AIや米OpenAIなどの研究チームが開発

“人工生命”を発見する自動AIシステム「ASAL」 Sakana AIや米OpenAIなどの研究チームが開発

米MITや日本のベンチャーSakana AI、米OpenAIなどに所属する研究者らは、人工生命のシミュレーションを自動的に探索・発見するシステムを提案した研究報告を発表した。 Sakana AI、AIの“多様性”を尊重した集団を開発する手法「CycleQD」発表 生物の“すみ分け”がヒント

Sakana AI、AIの“多様性”を尊重した集団を開発する手法「CycleQD」発表 生物の“すみ分け”がヒント

AIベンチャー「Sakana AI」は、自然界の生物の「すみ分け」の仕組みをヒントに、小規模なAIモデル(AIエージェント)を複数育て上げ、それぞれが得意分野を持ちながら協力し合える新しい開発手法を提案した研究報告を発表した。 AIベンチャー・Sakana AI、ビジネスアナリストを募集 「生成AIモデルに強い情熱を持つ人は優遇」

AIベンチャー・Sakana AI、ビジネスアナリストを募集 「生成AIモデルに強い情熱を持つ人は優遇」

AIベンチャーのSakana AIは、ビジネスの企画立案・実装を担う職種「ビジネスアナリスト」の募集を始めた。 東京都がAI活用に向け有識者会議 開発中の生成AIプラットフォームに松尾豊教授「めちゃくちゃいい」

東京都がAI活用に向け有識者会議 開発中の生成AIプラットフォームに松尾豊教授「めちゃくちゃいい」

東京都が、AIによる行政サービス変革の実現に向けた「東京都AI戦略会議」の第1回を実施した。都の生成AIプラットフォームに対し、松尾豊教授が「めちゃくちゃいい。全体アーキテクチャをこれほど考えたものは見たことがない」と評する場面もあった。2025年夏ごろをめどにAI戦略を策定して公表する予定。 科学研究をAIで全自動化──論文執筆や査読ができる「The AI Scientist」 Sakana AIが発表

科学研究をAIで全自動化──論文執筆や査読ができる「The AI Scientist」 Sakana AIが発表

AIモデルを使って、科学研究を自動化できないか?──AIベンチャーのSakana AIは、そんな需要に対応するAIシステム「The AI Scientist」を発表した。