そのAIモデルの良い精度結果、たまたま“良い乱数”を引いただけかも? ランダムシードの影響を調査、21年の研究結果:ちょっと昔のInnovative Tech(AI+)

フランスの研究者であるデビット・ピカールさんが2021年、深層学習アーキテクチャにおいてランダムシード(乱数生成器の初期値)の選択が精度に大きな影響を与えるかを検証した研究報告を発表した。

ちょっと昔のInnovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。通常は新規性の高いAI分野の科学論文を解説しているが、ここでは番外編として“ちょっと昔”に発表された個性的な科学論文を取り上げる。

X: @shiropen2

フランスの研究者であるデビット・ピカールさんが2021年に発表した論文「Torch.manual_seed(3407)is all you need: On the influence of random seeds in deep learning architectures for computer vision」は、深層学習アーキテクチャにおいてランダムシード(乱数生成器の初期値)の選択が精度に大きな影響を与えるかを検証した研究報告である。

この研究では、CIFAR-10データセット(6万枚の画像データ)に対して最大1万の異なる乱数シードをResNet9で試し、さらにImageNetデータセットでは事前学習モデル3種を用いて少数のシードを検証した。今回はコンピュータビジョン分野の深層学習モデルに焦点を置く。

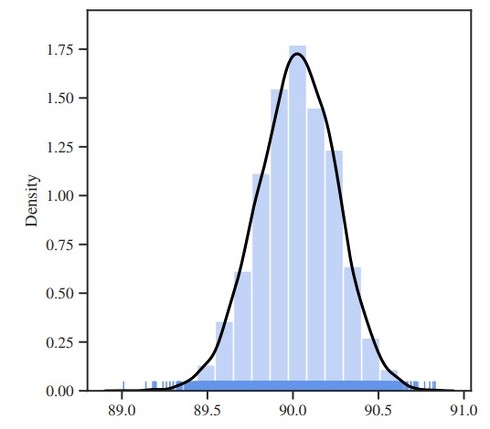

結果として、良い精度がでる当たりのシード(または悪いシード)が存在することが分かった。またCIFAR 10では同じモデルでも最大1.82%(89.01%〜90.83%)の精度差が、ImageNetでも約0.5%の精度差を確認できた。コンピュータビジョンの分野ではこの程度の精度差が“有意な差”として論文掲載の決め手になることがある。

つまり、モデル自体や訓練方法を変えなくても、単にランダムシードが異なるだけで論文に採択されるほどの精度差が生じる可能性がある。これは、研究者が試行錯誤の過程で無意識のうちに“良いシード”を選んでいる可能性を示唆している。

この問題を解決するためには、より多くのシードでテストを行い、平均値、標準偏差、最小値、最大値などの統計情報を報告することが重要だと主張している。これにより、単一の実験結果に依存せず、モデルの真の性能をより正確に評価できるようになる。

Source and Image Credits: Picard, David. “Torch. manual_seed(3407)is all you need: On the influence of random seeds in deep learning architectures for computer vision.” arXiv preprint arXiv:2109.08203(2021).

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

AIが100%突破できない「私はロボットではありません」 海外チームによる新CAPTCHA AI生成の“錯視画像”利用

AIが100%突破できない「私はロボットではありません」 海外チームによる新CAPTCHA AI生成の“錯視画像”利用

オーストラリアのニューサウスウェールズ大学やシンガポールの南洋理工大学に所属する研究者らは、AIが生成した錯視画像を利用する新しいセキュリティ対策を提案した研究報告を発表した。 米国「中国にはAIチップを輸出規制」→テンセントら中国AI企業は回避 “4つの回避法”とは?

米国「中国にはAIチップを輸出規制」→テンセントら中国AI企業は回避 “4つの回避法”とは?

米カリフォルニア大学バークレー校に所属する研究者らは、中国のAI企業が米国の半導体輸出規制を回避して最先端のAIモデルを開発している実態を、テンセントの事例を中心に技術的・制度的な観点から分析した研究報告を発表した。 “ピクサーの動く卓上ライト”を再現した実機、Appleが開発 人間のような「非人間型ロボット」

“ピクサーの動く卓上ライト”を再現した実機、Appleが開発 人間のような「非人間型ロボット」

米Appleに所属する研究者らは、人型でないロボットが人間と自然に関わるために、単なる機能的な動きだけでなく、感情や意図を表現する動きをどのように設計すべきかを探求した研究報告を発表した。 Geminiの記憶を「汚染」 生成AIの弱点を突くハッキングの手口、海外の研究者が報告

Geminiの記憶を「汚染」 生成AIの弱点を突くハッキングの手口、海外の研究者が報告

生成AIの弱点を突くAIハッキングの手口を研究しているサイバーセキュリティ研究者が、Geminiに不正な文書を読み込ませてユーザーの経歴を書き換えさせる方法を発見し、コンセプト実証動画を公開した。 Google、科学者の研究を助けるマルチエージェントAI「AI co-scientist」提供開始

Google、科学者の研究を助けるマルチエージェントAI「AI co-scientist」提供開始

Googleは、科学研究を加速させるための新AIシステム「AI co-scientist」を発表した。「Gemini 2.0」ベースで、複数の専門エージェントを使って仮説を生成、評価、洗練する。