日本語に強いVLM「Sarashina2-Vision」 ソフトバンクのAI開発企業が公開 MITライセンスで商用利用OK

ソフトバンクの子会社でAIの研究開発などを手掛けるSB Intuitionsは、日本語に強い大規模視覚言語モデル(VLM)「Sarashina2-Vision(8B・14B)」を公開した。

ソフトバンクの子会社でAIの研究開発などを手掛けるSB Intuitions(東京都港区)は3月17日、日本語に強い大規模視覚言語モデル(VLM)「Sarashina2-Vision(8B・14B)」を公開した。同社独自の大規模言語モデル(LLM)「Sarashina2」シリーズをベースに開発したAIモデル。MITライセンスで、商用利用も可能だ。

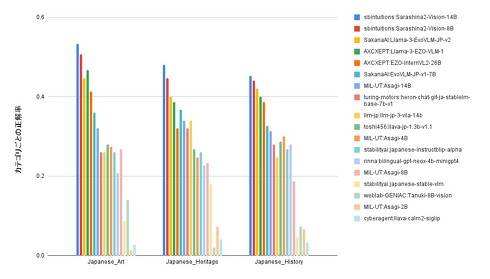

Sarashina2-Visionは、特に日本語や日本の文化・慣習に強いAIモデルとして構築。日本に関連する画像のタスク処理能力を評価したところ、複数の日本語ベンチマークで国内最高の性能を実現したという。80億パラメータの8Bと、140億パラメータの14Bのどちらも同社のHuggingFace Hubページで公開中。

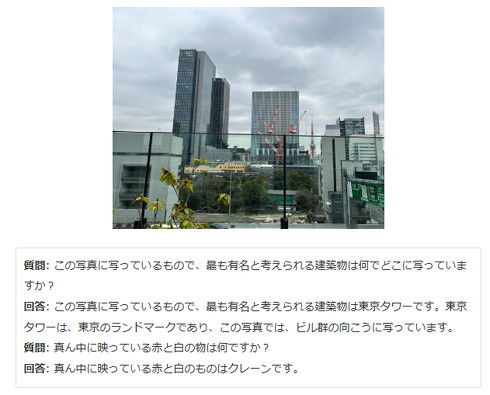

VLMとは、画像とテキストを複合して扱えるマルチモーダルなAIモデル。画像とテキストを理解できることで「この写真に写っているものは何ですか?」のような質問に対応できる。

Sarashina2-Visionに東京タワーが写った写真を提示し「この写真に写っているもので、最も有名と考えられる建築物は何でどこに写っていますか?」と質問すると、「この写真に写っているもので、最も有名と考えられる建築物は東京タワーです。東京タワーは、東京のランドマークであり、この写真では、ビル群の向こうに写っています」と回答するという。

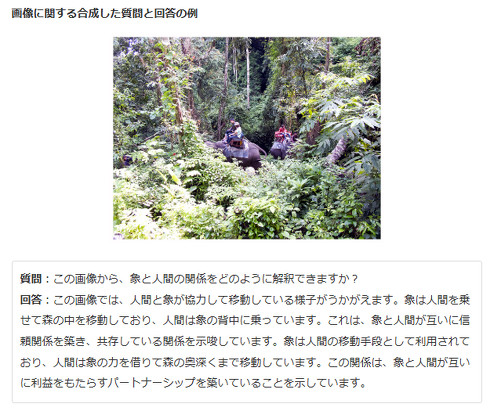

VLMのチューニングにおいて、高品質な画像指示チューニングデータセットは欠かせない。しかし、日本語のこれらのデータセットを確保するのが難しいのが現状という。公開済みのデータセットが少なく、人手によるデータ作成はコストが高く大量のデータの用意が困難であること、公開されている場合もライセンスの制限などの問題があるためだ。

これらの課題を解決するため、SB Intuitionsでは合成データセットを活用し、不足分を補った。これにより「一定の品質のデータを大量に作成できる」「目的に応じたタスク特化のデータを作成できる」などのメリットも得られ、VLMの性能向上を実現できたとしている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

ソフトバンクのAI開発企業、小規模言語モデルを公開 30億パラメータ以下の3種類 商用利用も可能

ソフトバンクのAI開発企業、小規模言語モデルを公開 30億パラメータ以下の3種類 商用利用も可能

ソフトバンクの子会社でAIの研究開発などを手掛けるSB Intuitionsは、小規模言語モデル(SLM)「Sarashina2.2」シリーズを公開した。 技術論争乗り越え事業化フェーズへ 躍進する「Sakana AI」、創業者デイビッド・ハー氏の狙い

技術論争乗り越え事業化フェーズへ 躍進する「Sakana AI」、創業者デイビッド・ハー氏の狙い

米中が主導するAI開発の覇権争いに、日本発のスタートアップが新たな変数として浮上している。創業からわずか18カ月のSakana AIが、革新的な「省資源型AI開発」を武器に、グローバルな存在感を示し始めた。急成長の一方で技術的な論争も経験しながら、このほど事業開発本部を設立し、研究成果の社会実装へと本格始動。世界的AIスタートアップとしての真価が問われる新たな段階に入った。 Sakana AI、複数の画像を扱える“日本語視覚言語モデル”公開 非英語圏での先駆けに

Sakana AI、複数の画像を扱える“日本語視覚言語モデル”公開 非英語圏での先駆けに

AIスタートアップのSakana AIは、複数の画像について日本語で質疑応答できるAIモデル「Llama-3-EvoVLM-JP-v2」を発表した。 サイバーエージェント、日本語に強い“視覚言語モデル”公開 パラメータ75億、商用利用もOK

サイバーエージェント、日本語に強い“視覚言語モデル”公開 パラメータ75億、商用利用もOK

サイバーエージェントは、75億パラメータの日本語大規模視覚言語モデル(Vision Language Model、VLM)を一般公開した。 “GPU2個でGPT-4o”並みの性能 AIモデル「Command A」登場 「Transformer」開発者が発表

“GPU2個でGPT-4o”並みの性能 AIモデル「Command A」登場 「Transformer」開発者が発表

カナダのAI企業Cohereは、生成AIモデル「Command A」を発表した。GPU2個で動作でき、米OpenAIの「GPT-4o」などと遜色ない性能を実現したという。