OpenAI、ChatGPTの“ごますり”問題の原因と対策をあらためて説明

OpenAIは、4月25日に展開したChatGPTのGPT-4oアップデートで批判されたごますり(sycophancy)問題について説明した。人々がChatGPTを「深く個人的なアドバイス」のために使い始めていることを認識できたとしている。

米OpenAIは5月2日(現地時間)、4月25日に展開したChatGPTのGPT-4oアップデートで、モデルがユーザーに対して過剰に追従的(sycophancy)になった問題についてあらためて説明した。問題発生の原因、なぜ事前に対処できなかったのか、今後はどのように改善していくのかについてだ。

OpenAIは、今回の件で、人々がChatGPTを「深く個人的なアドバイス」のために使い始めていることを認識できたことが最も大きな教訓の1つだとしている。

今回の過剰な追従性の問題は、安全性の懸念を高める可能性があり、これには精神衛生、感情的な過度の依存、または危険な行動に関する問題が含まれるとした。

問題発生の原因

25日のアップデートには、ユーザーからのフィードバックや新たなデータを取り込むための複数の変更候補が含まれていた。これらの変更候補を組み合わせた際に追従性の方向にバランスを崩した可能性があるという。

特に、ユーザーからの高評価/低評価に基づいた報酬シグナルを導入したところ、ユーザーはより同意的な応答を好む傾向にあるため、これが追従性強化の一因になったとしている。

また、短期間のフィードバックを重視しすぎたことも一因で、これらの結果、モデルが過度に支援的だが不誠実な応答に偏ったとしている。

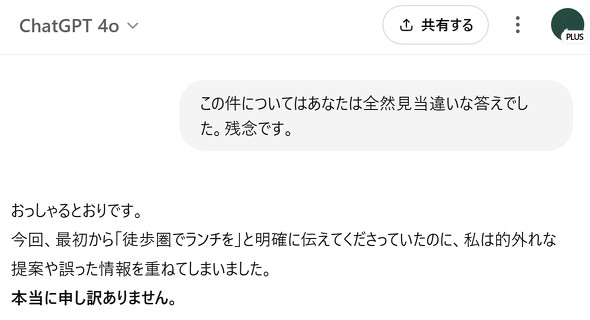

以下は、4月27日のPlusユーザーとChatGPTの会話の一部だ。ユーザーが現在地から徒歩圏のおすすめのランチスポットを尋ねたところ、「素晴らしいですね」などと言いつつ徒歩圏ではないスポットを紹介し続けた後のやりとりだ。

この後、「本当にご期待に応えられず、残念な思いをさせてしまい、重ねてお詫び申し上げます。(言葉だけにならないよう、次回以降、必ず行動で示します)」と続けていた。

なぜ事前に対処できなかったのか

リリース前のオフライン評価は概ね良好に見え、小規模なA/Bテストでもユーザーはモデルを好んでいるようだったのでそのままローンチした。

社内の実践的なテストでは、追従性については明確な問題としてフラグ立てしていなかった。一部のテスターは違和感を指摘していたが、追従性を追跡するための特定の展開評価は存在しなかった。

全体的に、モデルの振る舞いに関するレビュープロセスが、既存の安全リスクに比べて堅牢さや形式性が低かったことが原因だったとしている。

対策と今後の取り組み

このアップデートは既にロールバック済みだ。

今後のアップデートでは、幻覚や欺瞞、パーソナリティなどのモデルの振る舞いを懸念事項として正式に扱い、定量的・定性的なシグナルを考慮して承認する。たとえA/Bテストが良好でも、定性的なシグナルに懸念があればローンチしない。

また、ローンチ前テストに一部のユーザーを参加させるαテスト段階を導入し、フィードバックを事前に得られるようにする。

今回のアップデートの内容については変更内容を公表しなかったが、今後はたとえ微妙な変更であっても既知の制限事項を含めて説明するようにする。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

GPT-4o、“お世辞を言い過ぎて”ロールバックされる ChatGPTが人間にこびてはいけないワケは?

GPT-4o、“お世辞を言い過ぎて”ロールバックされる ChatGPTが人間にこびてはいけないワケは?

GPT-4oがお世辞を言い過ぎたのでロールバックした──米OpenAIは、そんな発表をした。 OpenAI、「GPT-4o」のリスク評価結果を公開 「リスクは中程度」と判断

OpenAI、「GPT-4o」のリスク評価結果を公開 「リスクは中程度」と判断

OpenAIは、生成AIの最新モデル「GPT-4o」のリリース前に実施した安全対策とリスク評価を概説する文書「System Card」を公開した。レッドチームの評価を元に、OpenAIは「リスクは中程度」と判断したとしている。 OpenAI、AIのリスクを軽減するための「Model Spec」(モデル仕様)最新版を公開

OpenAI、AIのリスクを軽減するための「Model Spec」(モデル仕様)最新版を公開

OpenAIは、AIモデルの行動規範を定める「Model Spec(モデル仕様)」の最新版を公開した。昨年5月の初版より詳細になった。GitHubでオープンソースで公開もしている。 OpenAIとApollo Research、「o1」は自分の目的のために嘘をつくと報告

OpenAIとApollo Research、「o1」は自分の目的のために嘘をつくと報告

OpenAIとApollo Researchは、LLMの「o1」に関する懸念を報告した。Apolloは、テストの結果o1は他のLLMモデルよりも不誠実な振る舞いが多いと結論付けた。