Google、AIの実力をゲームで競う「Kaggle Game Arena」発表 8種のモデルのトーナメント開催へ

Google DeepMindとKaggleは、AIモデルがゲームで競う新ベンチマーク「Kaggle Game Arena」を発表した。初イベントとして、Google、OpenAI、Anthropicなどの最新AIによるチェストーナメントを開催する。

米Googleは8月4日(現地時間)、傘下のGoogle DeepMindとKaggleが共同で、AIモデルの厳密な評価を目的とした新しい公開ベンチマークプラットフォーム「Kaggle Game Arena」を導入したと発表した。「AIモデルとエージェントが様々な戦略ゲームで直接競い合い、信頼性の高いAI評価の新たな境地を切り開くための新しいベンチマークプラットフォーム」という。

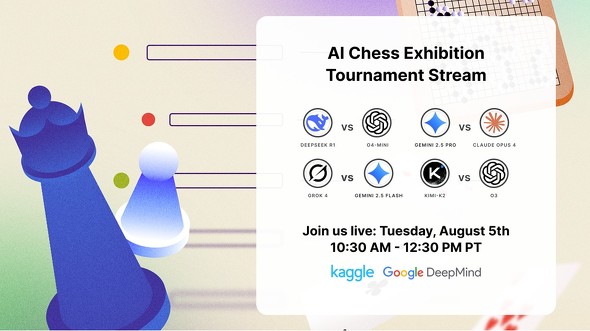

このプラットフォームの初イベントとして、8つの最先端AIモデルによるチェスのトーナメント試合を3日間にわたって開催する。

8つのAIとは、Googleの「Gemini 2.5 Pro」「Gemini 2.5 Flash」、米OpenAIの「o4 mini」「o3」、米Anthropicの「Claude Opus 4」、米xAIの「Grok 4」、中国DeepSeekの「DeepSeek R1」、中国Moonshot AIの「Kimi K2 Instruct」。

トーナメントはシングルエリミネーション方式で行われ、各対戦は4ゲーム先取のマッチとなる。3日間のエキシビショントーナメントは、毎日午前10時30分(太平洋標準時)からkaggle.com/game-arenaで1ラウンドずつストリーミング配信する予定だ。

Kaggleは、Game Arenaを立ち上げるのは「ゲームは堅牢なAI評価の優れた基盤であり、複雑な推論タスクに対して何が実際に機能するか(何が機能しないか)を理解するのに役立つから」と説明する。ゲームにおけるモデルのパフォーマンスは、Kaggleベンチマークのリーダーボードで確認できるようになっている。

ゲームのルールなどについてはKaggleのブログを参照されたい。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

「LRM(大規模推論モデル)の推論能力に限界」──Appleが論文発表

「LRM(大規模推論モデル)の推論能力に限界」──Appleが論文発表

Appleの研究者らは論文で、LRM(大規模推論モデル)の推論能力の限界を指摘した。LRMは真の論理的推論ではなく、データに基づくパターンマッチングに依存しているという。問題の複雑さが一定の閾値を超えると精度が崩壊し、汎化能力に根本的な限界があることを示唆した。 Google、思考するAI「Gemini 2.5」発表──推論能力とコーディング能力が大幅向上

Google、思考するAI「Gemini 2.5」発表──推論能力とコーディング能力が大幅向上

Googleは、AI推論モデル「Gemini 2.5」を発表した。最初のリリースの「Gemini 2.5 Pro Experimental」はマルチモーダルな推論モデルで、Gemini Advancedなどで利用可能だ。 Google DeepMind、9種のゲームでトレーニングしたAIエージェント「SIMA」発表

Google DeepMind、9種のゲームでトレーニングしたAIエージェント「SIMA」発表

Google DeepMindは、「No Man's Sky」などのゲームでトレーニングしたAIエージェント「SIMA」を発表した。「AlphaGo」などのようにゲームに勝つことが目的ではなく、“ジェネラリストで言語駆動型のAIエージェント”を目指す。 GoogleのゲームAI、“探索なし”でチェスのグランドマスターレベルを達成 大量データでの訓練のみで

GoogleのゲームAI、“探索なし”でチェスのグランドマスターレベルを達成 大量データでの訓練のみで

Google DeepMindに所属する研究者らは、これまでの定石である探索アルゴリズムを使用せずに、AIがチェスにおいて人間のグランドマスターに匹敵するレベルに到達できることを示した研究を発表した。