Anthropic、一般向け「Claude」のAIトレーニングへの個人データ利用をオプトアウト方式に変更

Anthropicは9月28日から、一般向けClaudeのAIトレーニングへのデータ利用を、従来のオプトインからオプトアウトに変更する。ユーザーが拒否しない限り、チャットデータなどが最長5年間保持され、モデル改善に利用される。同社は高性能化と安全性向上が目的と説明した。

米Anthropicは8月28日(現地時間)、一般消費者向けプライバシーポリシーを変更し、これまでオプトインだったユーザーデータのモデルトレーニングでの利用を、オプトアウトにすると発表した。この更新されたプライバシーポリシーは、9月28日に発効する。

この変更は、Claude Free、Claude Pro、Maxなどの消費者向け製品、およびこれらのアカウントでClaude Codeを使用しているユーザーが対象だ。Claude for Work(TeamおよびEnterpriseプランを含む)、Anthropic API、Amazon Bedrock、Google CloudのVertex AIなどの商用サービス、Claude Gov、Claude for Educationには適用されない。

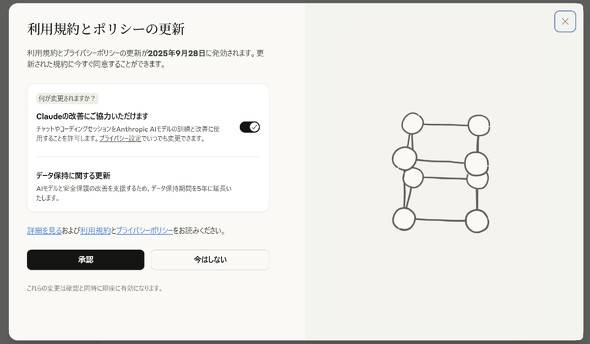

今回のプライバシーポリシー変更の核となるのは、ユーザーのチャットやコーディングセッションをClaudeの改善に使用するかどうかの設定が、オプトイン方式から、ユーザーが設定で明示的に拒否しない限り利用されるオプトアウト方式に切り替わる点だ。新規ユーザーはサインアッププロセス中にこの設定を選択し、既存ユーザーは2025年9月28日までに選択を行う必要がある。この設定は、プライバシー設定を通じていつでも変更できる。設定をオフにすれば、それ以降の新しいチャットやコーディングセッションは将来のモデルトレーニングには使用されなくなるが、すでに開始されたトレーニングや訓練済みのモデルには含まれる可能性がある。

また、データ保持期間にも変更がある。ユーザーがチャットやコーディングセッションをClaudeの改善のために使用することを許可した場合、新しいチャットや再開されたチャット、コーディングセッションのデータ保持期間は最長5年間に延長される。一方、モデルトレーニングへのデータ使用を許可しない選択をした場合、チャットデータはバックエンドストレージシステムで最長30日間保持される(トレーニングには利用されない)。

Anthropicは、これらの変更を行う理由を、より高性能で有用なAIモデルを提供するためとしている。加えて、ユーザーがデータ共有に協力することで、モデルの安全性が向上し、有害なコンテンツを検出するシステムがより正確になり、無害な会話を誤ってフラグ付けする可能性を低減できると説明する。さらに、AIの開発サイクルは長期にわたる(モデル開発に18〜24カ月を要する)ため、トレーニングプロセス全体でデータを一貫して保持することは、モデルの一貫性を高め、アップグレード間の変化をユーザーにとってよりスムーズにするのに役立つという。また、延長されたデータ保持期間は、乱用やスパムといった悪用パターンを特定する分類器の改善にも貢献し、Claudeをすべての人にとって安全に保つことにつながるとしている。

これらの更新は、新しいチャットや再開されたチャット、コーディングセッションにのみ適用される。既存のユーザーが今すぐ新ポリシーに同意することを選択した場合、更新はすぐにこれらのセッションに適用される。Anthropicはこの変更を、ユーザーのプライバシー保護を維持しつつ、より安全で高性能なAIモデルを開発するための重要なステップとしている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

AIがサイト閲覧、自動クリック・入力も Chrome拡張「Claude for Chrome」のテスター募集 攻撃受けるリスクあり

AIがサイト閲覧、自動クリック・入力も Chrome拡張「Claude for Chrome」のテスター募集 攻撃受けるリスクあり

Webブラウザ上で、Claude AIが自動的にボタンクリックやフォーム入力を行うChrome拡張「Claude for Chrome」のテスターを募集。 AnthropicのClaude、有害な会話を自ら終了する機能を試験導入 “AIの福祉”研究の一環

AnthropicのClaude、有害な会話を自ら終了する機能を試験導入 “AIの福祉”研究の一環

Anthropicは、「Claude Opus 4/4.1」が有害または虐待的な会話を最後の手段として自ら終了する実験的機能を発表した。「AI welfare」に関する研究の一環で、事前テストではAIが“苦痛”のパターンを示すことが観察されたという。 Anthropic、「Claude」の使用ポリシーを更新 エージェント機能の悪用規制を明示

Anthropic、「Claude」の使用ポリシーを更新 エージェント機能の悪用規制を明示

Anthropicは、AI「Claude」の使用ポリシーを9月15日付で更新すると発表した。エージェント機能の進化を受け、マルウェア作成やサイバー攻撃などの悪用を具体的に禁止。一方、政治的コンテンツに関する制限は一部緩和する。 Anthropic、AIの「感情的利用」調査結果を公開 対策も提示

Anthropic、AIの「感情的利用」調査結果を公開 対策も提示

Anthropicは、AI「Claude」の感情的な利用に関する調査結果を公開した。感情的な会話は全体の約3%と稀だが、内容は多岐にわたる。会話を通じてユーザーの感情が肯定的になる傾向が見られるが、AIを専門家の代替とはせず、安全対策を進める。