Meta、1600言語対応の音声認識「Omnilingual ASR」発表 GitHubで公開

Metaは、1600言語以上に対応する自動音声認識「Omnilingual ASR」を発表し、GitHubで公開した。大規模SSLとLLM-ASRアプローチを採用し、リソースの少ない言語もサポート。ゼロショット学習で新言語にも拡張可能としている。

米MetaのAI研究部門であるMeta FAIR(Fundamental Artificial Intelligence Research)チームは11月10日(現地時間)、1600以上の言語で話し言葉を文字起こしできるという自動音声認識システム「Omnilingual ASR」を発表した。Apache 2.0ライセンスの下、GitHubで公開した。

従来のASRシステムは、インターネット上で十分なデータが揃っている一部の言語に焦点を当てており、高い性能を発揮するためには大量のラベル付きデータに依存していた。Omnilingual ASRは、これまでどのASR技術にも対応されていなかった500以上のリソースの少ない言語を含む1600以上の言語をサポートするという。

ここまでの多言語対応が可能になったのは、AIアーキテクチャのスケーリングによるという。従来のシステムでは、普遍的にスケールするにはデータ要求が大き過ぎるという課題に対し、Omnilingual ASRは、まず自己教師あり学習(SSL)を用いた音声エンコーダを70億パラメータまでスケールアップさせ、多言語にわたるロバストな音声表現を学習した。この機能は、公開データセットと地域コミュニティから報酬付きで収集された音声記録を統合した、ASR用としてこれまでに収集された中で最大かつ最も言語的に多様なトレーニングコーパスに基づいているという。

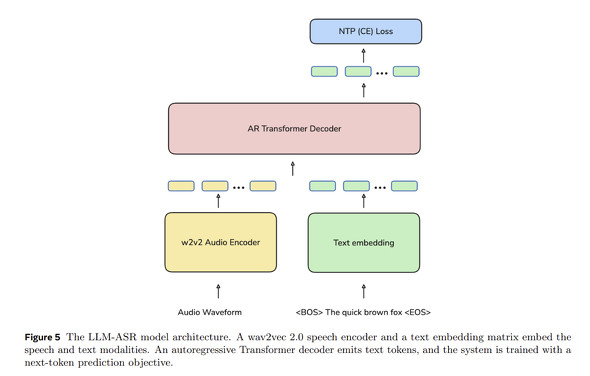

システムのおおまかな仕組みはエンコーダデコーダアーキテクチャを採用している。音声エンコーダが音声から表現を抽出し、テキストデコーダがこれを文字トークンにマッピングするというものだ。特に、ASR性能の飛躍的な向上をもたらすLLM-ASRと呼ばれるアプローチを導入している。これにより、スケーラブルなゼロショット学習が可能となり、サポートされていない言語の話者であっても、わずかな音声とテキストのペアのサンプルを提供することで、新しい言語に文字起こし能力を拡張できる。

従来のシステムでは、リリース時に含まれていない言語を追加するには専門家によるファインチューニングが必要だったが、Omnilingual ASRは、専門知識や大規模な計算リソースを必要とせずに、コミュニティが自身のデータで言語認識を拡張できる柔軟なフレームワークを提供するという。

このシステムは、最大限の精度を提供する強力な7Bモデルから、低電力デバイス向けに設計されたコンパクトな300Mモデルまで、用途に応じたモデルファミリーとしてリリースされている。

現在の制限として、推論時には40秒未満の音声ファイルのみが受け付けられており、無制限の長さの音声ファイルへの対応も、間もなく追加される予定だ。

Metaのサイトでデモを見ることが可能だ。

FAIRは今後、Omnilingual ASRをLLMと組み合わせた会話エージェントへの応用や、地域コミュニティが管理するアーカイブへの組み込み、音声翻訳技術への拡大などを計画している。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

Meta、AI部門で約600人削減を計画 「社内の別職種」への応募を奨励

Meta、AI部門で約600人削減を計画 「社内の別職種」への応募を奨励

米Metaが、人工知能(AI)部門であるスーパーインテリジェンスラボで約600人の人員を削減する方針であることが分かった。米国のニュースサイト「Axios」が10月22日に報じた。 Metaの新型AIメガネは“画面付き” リストバンドで操作する「Meta Ray-Ban Display」発表 799ドル

Metaの新型AIメガネは“画面付き” リストバンドで操作する「Meta Ray-Ban Display」発表 799ドル

Metaは年次開発者会議で、インレンズディスプレイ搭載の新型AIメガネ「Meta Ray-Ban Display」と、手の動きで操作するリストバンド「Meta Neural Band」を発表した。スマホなしでメッセージ確認や写真撮影などが可能だ。米国で9月30日に799ドルで発売する。 Meta、新AI部門トップに元OpenAIのジャオ氏を任命

Meta、新AI部門トップに元OpenAIのジャオ氏を任命

Metaは、新設のAI部門「Meta Superintelligence Labs」のトップに元OpenAIのシェンジア・ジャオ氏を任命した。ジャオ氏は、6月にCAIOとして迎えた元Scale AIのCEO、アレクサンドル・ワン氏の直属となる。MetaはAI人材の獲得を加速させている。 Meta、AIチームを再編 AIトップは退社

Meta、AIチームを再編 AIトップは退社

Metaは、「AIが業務の中心となってきた」ことに合わせたAI部門の再編を発表した。研究部門から各製品部門にAI業務が分散される。ヤン・ルカン博士とFAIRは研究部門として存続する。