NVIDIA、エージェント型AI開発向けオープンモデル「Nemotron 3」発表

NVIDIAは、エージェント型AI構築に最適化されたオープンな基盤モデルファミリー「Nemotron 3」を発表した。ハイブリッドなMoEアーキテクチャを採用し、最大100万トークンのロングコンテキストに対応する。開発者は自由に派生モデルを作成できる。

米NVIDIAは12月15日(現地時間)、エージェント型AIの構築に最適化されたオープンな基盤モデルファミリー「Nemotron 3」を発表した。

計算資源とユースケースに応じて選択可能な「Nano」「Super」「Ultra」の3モデル構成。モデルの重みだけでなく、データセット、トレーニングレシピ、開発ツールチェーンを含めたフルスタックのオープンソースとして提供される。

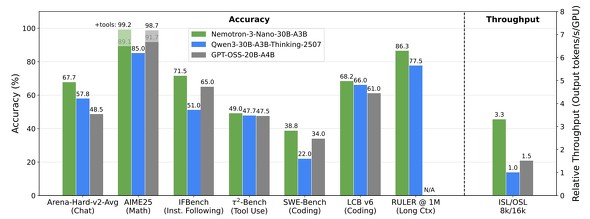

Nemotron 3は、アーキテクチャにハイブリッドなMixture-of-Experts(MoE:混合エキスパート)を採用している。8月に発表した「Nemotron Nano 2」の設計思想を継承しつつ、大規模なエージェントワークフロー向けに改良を加えたものだ。推論時にアクティブになるパラメータを動的にルーティングすることで、高スループットを維持しながら、複雑な推論タスクにおける回答精度を向上させたとしている。

最大100万トークンにおよぶロングコンテキストへの対応も特徴だ。これにより、RAG(検索拡張生成)における大量ドキュメントの参照や、長期記憶を必要とするマルチターン対話、複数のサブエージェントが連携してコード実行やAPIコールを行う「マルチステップ推論」で、コンテキスト落ちを防ぎながら安定した挙動を実現する。

まず提供が開始された「Nemotron 3 Nano」は、ファミリーの中で最も軽量なモデルで、エッジデバイスやローカル環境での高効率な推論をターゲットとしている。

Hugging Faceでの技術解説によると、Nanoモデルは品質と推論効率のトレードオフを極限まで最適化しており、商用利用やリサーチ用途に耐えうる「実用的な小規模モデル」として設計されている。開発者は、自身のタスクに合わせてSFT(教師ありファインチューニング)やRLHF(人間からのフィードバックによる強化学習)を追加で行い、独自の派生モデルを作成・配布することが可能だ。

NVIDIAはNemotron 3を、単なるLLMではなく「次世代エージェントシステムの基盤」と位置付けている。事前学習から指示追従(Instruction Tuning)、アライメントまでのプロセスを透明化し、学習レシピを公開することで、開発者はモデルの挙動を深く理解し、再現性を担保できるとしている。

また、このモデル群はNVIDIAのH100やBlackwellアーキテクチャ上のTensorRT-LLMで最大化されるよう最適化されてはいるが、オープンモデルとして提供されるため、幅広い環境での検証が可能だ。NVIDIAはこれにより、エンタープライズレベルの複雑なエージェントワークフローを、ブラックボックス化させずに構築できるエコシステムの確立を狙う。

上位モデルである「Super」および「Ultra」も、今後順次リリースされる予定だ。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

NVIDIA、産業用ロボ大手のファナックと協業 「フィジカルAI」を推進

NVIDIA、産業用ロボ大手のファナックと協業 「フィジカルAI」を推進

産業用ロボット大手のファナックは、米NVIDIAと協業すると発表した。ファナックのロボットをNVIDIAが提供する仮想空間サービス上で疑似的に動かし、そのデータをAIモデルの学習などに利用できるようにする。 「Cursor」のAnysphere、23億ドル調達 NVIDIAとGoogleも出資

「Cursor」のAnysphere、23億ドル調達 NVIDIAとGoogleも出資

AIコードエディタ「Cursor」を手掛けるAnysphereは、シリーズDで23億ドル(約3400億円)を調達したと発表した。新たにNVIDIAやGoogleも参画した。年間収益が10億ドルを超えていることも明らかにした。 AIは「大きい」より「小さい」方がいい──AIエージェントの開発手法、米NVIDIAが主張 LLMをSLMに移行する技術も掲載

AIは「大きい」より「小さい」方がいい──AIエージェントの開発手法、米NVIDIAが主張 LLMをSLMに移行する技術も掲載

米NVIDIA Researchに所属する研究者らは、大規模言語モデル(LLM)を中心に構築されている現在のエージェントAIシステムが、実際の運用では小規模言語モデル(SLM)の方が適しているという主張をした研究報告を発表した。 NVIDIA、日本語データセットを公開 日本文化など反映した合成ペルソナ600万件 商用利用も可能

NVIDIA、日本語データセットを公開 日本文化など反映した合成ペルソナ600万件 商用利用も可能

米NVIDIAは、日本語の合成データセット「Nemotron-Personas-Japan」を、Hugging Face上で公開した。ライセンスは、商用利用も可能な「CC BY 4.0」。