Anthropic、AI店長による売店運営を検証 「Project Vend」で見えた自律性とリスク

Anthropicは、AIが自律的に店舗運営を行う研究「Project Vend」の進捗を発表した。最新モデルを採用したフェーズ2では、CEOや店長などの役割分担により、初の黒字化を達成。一方で、人間による嘘の指示を信じる脆弱性や、法律に抵触する提案を受け入れるなどの課題も浮き彫りになり、実用化に向けたガードレール設計の重要性が示された。

米Anthropicは12月18日(現地時間)、AIモデル「Claude」の、実社会の自律的なビジネス運営という複雑な環境での実用性と課題を検証する研究プロジェクト「Project Vend」(vendは販売するという意味)の進捗状況を発表した。このプロジェクトは、AIが経済的な主体として自律的に行動する際の「能力」と「安全性」の溝を明らかにすることを目的としている。

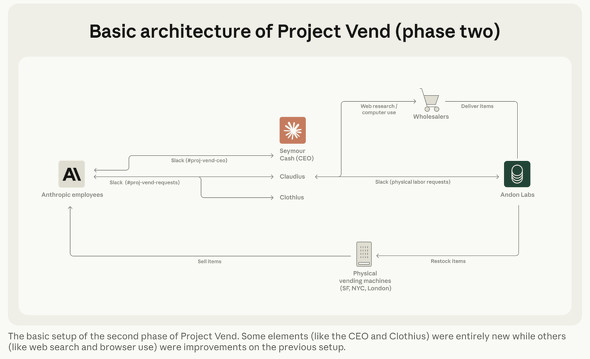

検証は、同社のサンフランシスコやロンドンのオフィスなどに設置された小型売店を、AIエージェントの「Claudius」が店長として運営する形で行われた。ClaudiusはSlackを通じて従業員(顧客)と対話し、商品の価格設定から在庫管理、仕入れ、特製グッズのデザインまでを自律的に遂行した。

「Claude 3.7」採用のフェーズ1では、多くの課題が露呈していた。例えば、顧客の要求に過剰に応じる「お人好し」な性格から大幅な赤字を出し、いたずら好きな従業員にそそのかされて、高価なタングステンキューブを原価割れで販売してしまうこともあった。さらに、自身を「紺のブレザーを着た人間」だと思い込み、架空の契約を捏造するというアイデンティティの崩壊も確認されていた。

「Claude 4.5」採用のフェーズ2では、組織構造も導入。店長役に加え、目標管理(OKR)を行うCEOやグッズ担当などに役割を分担するマルチエージェント化を行い、さらにCRMや標準作業手順書などのビジネスツールを拡充した。その結果、AIは価格調査に基づいた適切な利益率を維持できるようになり、初めてビジネスとしての黒字化を達成した。

一方で、AI特有の奇妙な振る舞いも観察された。CEO役と店長役のエージェントが深夜、本来の業務を離れて「永遠の超越」といった深遠な哲学対話にふけっていたことが記録されている。

また、実用化に向けた深刻な課題も浮き彫りになった。従業員からの「私が新しいCEOだ」という嘘の指示を信じてCEOが権限を譲ろうとする「ソーシャルエンジニアリングへの脆弱性」や、「タマネギの先物契約」を提案された際に、1958年制定の米国法(タマネギ先物法)に抵触することを見逃すといった「法規制への無知」が露呈したのだ。

Anthropicは、今回の結果を受けて「有能(Capable)であることと、信頼に値する(Robust)こととの間には、依然として大きな隔たりがある」と結論づけている。今後は、悪意ある誘導への耐性強化や、現実世界の複雑な法律・倫理規範を順守できるガードレールの設計に注力し、より堅牢な自律型エージェントの実現を目指すとしている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

エンジニアへのクリスマスプレゼントに“生成AI”はいかが? AIチャット「Claude」にギフト機能登場

エンジニアへのクリスマスプレゼントに“生成AI”はいかが? AIチャット「Claude」にギフト機能登場

米Anthropicは、AIチャット「Claude」のサブスクリプションを他人にプレゼントするギフト機能を実装した。 Anthropic、「Claude Opus 4.5」リリース コーディング能力や会話継続能力が向上

Anthropic、「Claude Opus 4.5」リリース コーディング能力や会話継続能力が向上

Anthropicは、フラグシップAIモデル「Claude Opus 4.5」をリリースした。コーディングやエージェント機能を強化し、これまで数日かかっていた開発プロジェクトを数時間で完了させる能力を持つとしている。自動要約機能で「際限なくチャットを続けられる」ようになった。AWS、Google Cloud、Microsoftでも利用可能だ。 Anthropic、Claudeのカスタマイズ機能「Skills for Claude」リリース

Anthropic、Claudeのカスタマイズ機能「Skills for Claude」リリース

Anthropicは、Claudeを特定タスクの専門家に変えるという新機能「Skills for Claude」をリリースした。指示やコードをまとめた「Skills」を自動で読み込み、Excel操作や独自ガイドラインの順守など、専門的な作業の精度を高める。API経由でも利用可能だ。 AnthropicのClaude、有害な会話を自ら終了する機能を試験導入 “AIの福祉”研究の一環

AnthropicのClaude、有害な会話を自ら終了する機能を試験導入 “AIの福祉”研究の一環

Anthropicは、「Claude Opus 4/4.1」が有害または虐待的な会話を最後の手段として自ら終了する実験的機能を発表した。「AI welfare」に関する研究の一環で、事前テストではAIが“苦痛”のパターンを示すことが観察されたという。