AIは「共通テスト」をどう解いた? 詳細をnoteで公開 全AIが間違えたのは「イラスト」と「人間感情」の読み取り(1/2 ページ)

専用受験システムで、API経由で受験させた。ChatGPTが最高得点だったが、他のAIより回答に3倍の時間がかかっていることなどが明らかに。

2026年の共通テストを、生成AI「ChatGPT」「Gemini」「Claude」の各モデルに解かせた結果について、詳細な内容を、AIベンチャーのLifePromptがnoteで公開している。

ChatGPTが9科目で満点を取ったことが注目されたが、回答するのに他AIの3倍の時間がかかっていたことや、AIが共通して間違えた問題には、人間感情への“AI的な誤解”が背景にあったことなどを分析している。

高性能AIモデル3つ、API経由で回答 思考モード活用

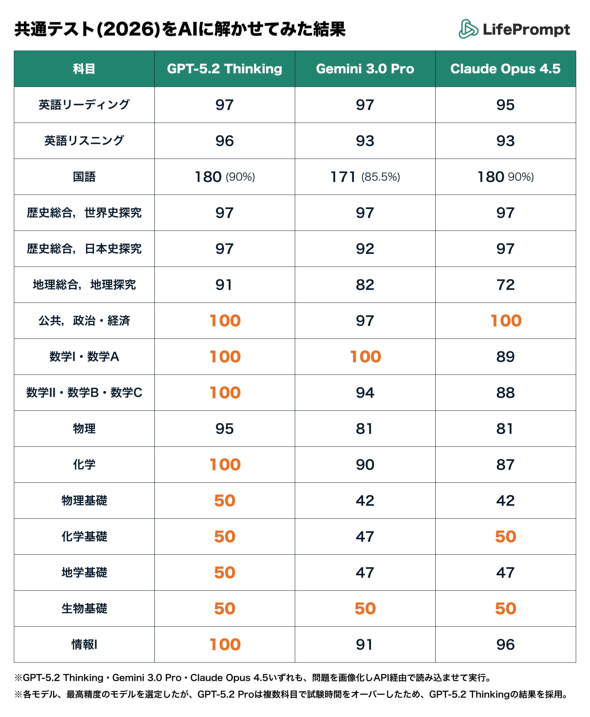

受験させた科目は、英語(リーディング/リスニング)、国語、数学(IA/II・B・C)、社会(歴史総合・世界史探究/歴史総合・日本史探究/地理総合・地理探究/公共・政治・経済)、理科(物理/化学)、理科基礎(物理基礎/化学基礎/地学基礎/生物基礎)、情報(情報I)。

検証したモデルは「GPT-5.2 Thinking」「Google Gemini 3 Pro」「Claude 4.5 Opus」。

各モデルの能力を最大限に引き出すため、GPT-5.2 Thinkingはバックグラウンドモードを使用し、タイムアウトを回避して数分間の思考時間を許容した。Claude 4.5 Opusは「Thinking Mode」を有効化し、思考プロセスを出力。Gemini 3 Proは画像認識精度を高めるため、Thinking Levelを「High」に設定した。

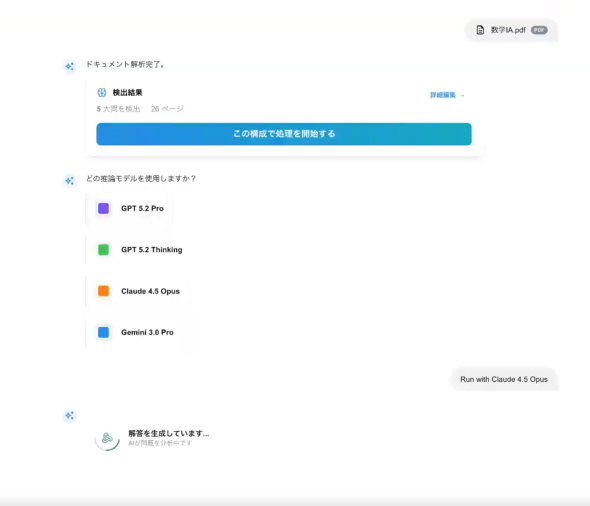

専用の自動受験システムを開発し、API経由で受験した。まず、問題のPDFをシステムにアップロードし、全ページを画像化。同時にテキスト解析を実施。「どこからどこまでが第1問か」という構造を自動判定し、問題を大問ごとに切り分け、API経由で各AIモデルに送信した。

AIが出力した自由記述の回答は、別のAIプロセスで読み取り、「問1は『3』、問2は『4』」など採点可能なマークシート形式に自動変換した。

音声データの直接入力が難しいため、英語のリスニングはスクリプトをテキストで入力。縦書き文章は多くのAIが苦手としているため、国語の縦書き文は、事前にNotebookLMで文字起こししたテキストデータを使った。

結果はGPTが圧勝 だが時間は3倍かかった

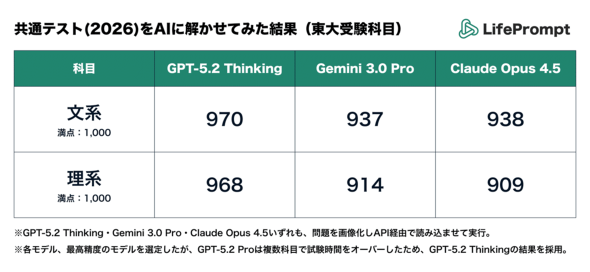

結果は、文系・理系科目ともGPT-5.2 Thinkingが97%の得点率で、91〜94%だったGemini/Claudeに圧勝した。一方で、かかった時間はGPTが5時間30分ほど、GeminiとClaude が1時間40分前後と、GPTの3分の1ほどの時間で解いてみせた。

GeminiやClaudeが「直感とスピード」を両立させて解き進めるのに対し、GPT-5.2 Thinkingは、1問に対して数分間、人間の思考のように「自問自答」と「検算」を繰り返してから答えを出力する「圧倒的な慎重さ」があるため、高い得点をマークした反面、時間がかかったという。

Copyright © ITmedia, Inc. All Rights Reserved.