「日本語はAIにとって難しい」 Galaxy AI/Bixbyの強みは? サムスン日本研究所で聞いた(1/3 ページ)

2025年4月1日、Appleの生成AI機能「Apple Intelligence」が日本語対応を果たした。サムスン電子ジャパンは「いち早く日本語対応を果たした」AI機能を、あえてこのタイミングでアピールした。Galaxy AI/Bixbyの強みも語られた。

2025年4月1日、Appleの生成AI機能「Apple Intelligence」がついに日本語対応を果たした。生成AIの分野では、Googleやサムスン電子が先行し、Appleよりも早く端末にAI機能を実装してきたが、今回の対応により、Appleも本格的に競争へ参入することになる。Appleを巻き込んだ「AI競争」は、ここからが正念場といえるだろう。

そんな中、サムスン電子ジャパンは日本の研究開発拠点「サムスン日本研究所」で、Galaxy AIの説明会を開催。Mobile Solution Lab Artificial Intelligence Part長 赤迫貴行氏が、サムスン電子が注力しているAI分野や、Galaxy AI対応のスマートフォンを日本で送り出せている理由を話した。その説明からは「日本語対応の難しさ」がまじまじと伝わってきた。

サムスン日本研究所とは? 2023年にソフトウェア開発チームが発足

サムスン日本研究所は、韓国サムスン電子の研究開発法人として1992年8月に、研究開発組織として設立された。1997年には、事務所を横浜に移転し、1998年には、商号を設立当時のAITECHからサムスン横浜研究所に変更。2002年には、大阪にも研究拠点を設置した。2025年現在、日本国内には2つの研究開発拠点があり、横浜と大阪にそれぞれ配置されている。

サムスン日本研究所では、冷蔵庫や洗濯機に搭載される高性能部品の研究開発、テレビやプロジェクターに関する技術開発、スマートフォンのカメラの画質向上に関する技術開発、ロボット技術に関連する要素技術の研究開発、Galaxyデバイス向けソフトウェアの開発を行っている他、スタートアップ企業との連携による新たな研究開発領域の創出を目指している。

これまで主にハードウェアの開発を行ってきたサムスン日本研究所。2023年には、ソフトウェア開発チームが発足し、このタイミングで日本語AIの開発をスタートさせた。2024年には、「Galaxy S24」が登場。2025年2月には、「Galaxy S25」とともにBixby日本語版を正式にリリースした。この日本語対応のAI機能の開発にも、サムスン日本研究所が関わっている。

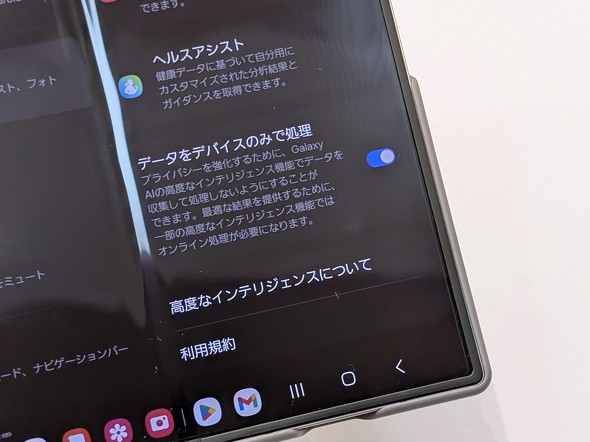

Galaxy AIは、全ての処理をデバイスで実行できるオンデバイスAI、クラウド上で高機能なAIを実現できるクラウドベースAIの2つを活用するハイブリッド処理となっている。

オンデバイスAIは、スマートフォン端末内で処理を行うため、データをネットワークに送信せずに済み、安全かつ高速に処理できるのが特徴だ。一方のクラウドベースAIでは、ネットワーク上のAIサーバが処理を担当するため、より大規模な計算が可能だ。

特にスマートフォンにおけるオンデバイスAIでは、デバイス上で処理を行う関係上、電力消費の抑制が重要になるため、ファイルサイズの軽量化が求められる。一方、Web上の情報を活用したり、LLM(大規模言語モデル)の処理を実行したりする場面も今後増えると予想される。

このうち、サムスン電子では、オンデバイスAIの開発に力を注いでおり、その中でも多言語対応が主な注力点となっている。日本語を目標とする研究開発拠点では、その業務をサポートする言語のエキスパートや、現地語に精通してるネイティブなエンジニアをそろえ、言語ごとに最適な環境で開発を進めている。

2023年4月から日本での開発を本格化、日本語特有の問題をより早期に発見

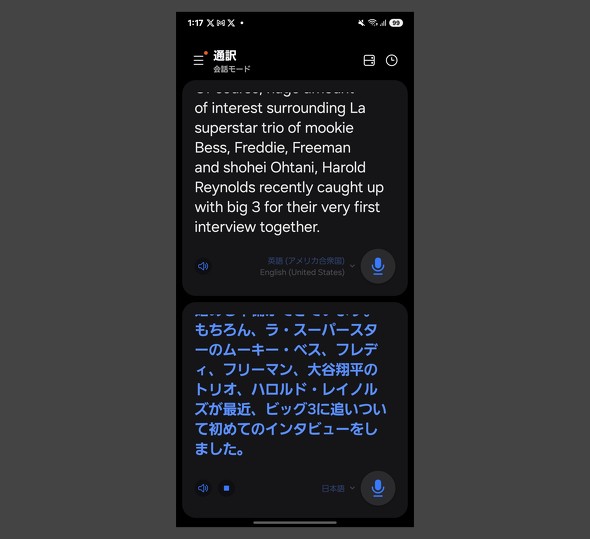

Galaxy AIでは、音声通話を行う際にリアルタイムで通訳する「通話アシスト」、テキストメッセージの翻訳やメッセージの作成を手伝う「チャットアシスト」、会話をリアルタイムに通訳する「通訳」、さらには不要なオブジェクトを取り除くなど画像編集に関する「フォトアシスト」、簡単な落書きでも絵画のような仕上がりに変換する「スケッチアシスト」など、さまざまな機能を提供している。

スマートフォンでは、Galaxy S24シリーズ、Galaxy S23シリーズ、Galaxy S22シリーズ、フォルダブルスマートフォンでは、Galaxy Z Fold6/Z Flip6、Galaxy Z Fold5/Z Flip5、Galaxy Z Fold4/Z Flip4で利用でき、Galaxy Tab S10、Galaxy Tab S9などのタブレットでも一部利用可能だ。

通話内容をリアルタイムで端末から直接翻訳し、多言語コミュニケーションを簡単に行える、Galaxy AIの通話アシスト。主に旅行中に現地の人と会話する用途が想定されているが、英語から日本語に変換されるまでに複数の行程をへている。

例えば、英語で「Hello」と話しかけられた場合、その音声はまず音声認識エンジンによって「Hello」というテキストに変換された後、テキストが機械翻訳エンジンを通じて、日本語の「こんにちは」に変換される。最後に、変換された日本語のテキストが音声合成エンジンを介して「こんにちは」という音声として出力される。

赤迫氏によると、2023年にソフトウェア開発チームが発足する以前は、日本語音声認識エンジンの開発を、中国・北京にあるサムスンの研究所で行っていたそうだが、2024年3月に技術移管が行われ、同年4月以降は日本国内での開発が本格的に進められている。また、機械翻訳エンジンと音声合成エンジンについては、現在もサムスン電子の開発チームと合同で開発を進めている。

さらに、日本語対応の精度向上のため、「日本語ネイティブのエンジニアが多く関わるようになった」と赤迫氏。以前は、日本語音声認識エンジンの一部を中国で開発・実装していたが、日本国内での開発が進むことで、「日本語特有の問題をより早期に発見し、かつ迅速に対応できるようになり、結果として品質向上のスピードも大幅に加速している」という。

赤迫氏が示す「日本語対応の難しさ」 日本語特有の課題は6つ

人的リソースが増えたとはいえ、超えなければならない壁はいくつかある。赤迫氏は、日本語の音声認識や機械翻訳を開発する上で、他の言語にはない特有の難しさがいくつか存在すると言う。代表的な課題は、大きく分けると6つあるので、順に見ていこう。

1つ目:同音異義語が多い

日本語には、「箸(はし)」と「橋(はし)」など、同じ発音でも意味が異なる単語が多く存在する。その際はイントネーションや文脈によって区別する必要があるが、特に方言によってイントネーションが異なると、識別が難しくなる。

2つ目:人名の表記が難しい

人名の認識も大きな課題の1つ。有名人の名前なら、文脈から特定しやすいが、一般の人の名前や普段聞き慣れない名前は文脈から漢字表記を推測するのが困難だという。名前は認識できても漢字違いもあり得る。例えば、スマートフォンのマイクから「おおたにしょうへい」という音声を拾えたとしても、それが「大谷翔平」なのか「大谷昌平」なのかを判断するのは容易ではない。

3つ目:数字とアルファベットの読み方が一定でない

日本語では、アラビア数字やアルファベットの読み方が状況によって変わることが多く、音声認識においては大きな課題となっている。例えば、Galaxyの「S25」という表記は「エス・にじゅうご」と読まれる場合もあれば、「エス・トゥエンティファイブ」と発音されることもある。会話の中で、読み方が統一されていない場合、同じ言葉だとしても、音声認識エンジンが適切に解釈するのは難しい。

4つ目:同形異音語(表記は同じだが読みが異なる単語)が存在する

日本語には、同じ漢字表記でも読み方が異なる単語が存在する。例えば、「方法」の「方」という漢字は、「かた」と読む場合と「ほう」と読む場合がある。テキストだけを見ても、どの読み方が正しいのかを判断するのは難しく、「音声合成エンジンの高品質化を図る上での課題になっている」(赤迫氏)そうだ。

5つ目:日本語は主語がなくても通じるが、機械翻訳エンジンを開発する上では障壁に

日本語は主語がなくても通じる言語で、日常生活において主語が抜けた会話をよく聞く。話し手と聞き手の間で前提となる情報が共有されていれば、主語を省略したりあいまいな表現をしたりしても、通じる面はある。

例えば、「それ、どう?」という問いのそれ(主語)は、会話の流れによっては計画かもしれないし、あるいは近くに置いてある物を指しているかもしれない。ただ、この曖昧さが「機械翻訳エンジンの開発において障壁になる」と、赤迫氏は述べる。

6つ目:日本語はスペースで単語を区切らない

英語やフランス語などのラテン系言語では、単語がスペースで区切られるため、文章の構造を解析しやすい。一方、日本語では「単語同士が連続している」ため、どこで区切るかを適切に判断する必要がある。分かりやすく例を挙げると、「機械翻訳」の4文字は漢字それぞれが別の意味を持つが、4文字それぞれの間にスペースは入れない。一方、英語では「Machine Translation」と単語と単語の間にスペースが入る。そのため、「単語単位なのか文節単位なのかの区別が難しく、シナリオによって言語理解の精度に影響を及ぼす」(赤迫氏)という。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

「Galaxy S25」シリーズが“Androidを再構築”したといえるワケ GoogleとAI強化も差別化には課題も

「Galaxy S25」シリーズが“Androidを再構築”したといえるワケ GoogleとAI強化も差別化には課題も

「Galaxy S25」シリーズのハードウェアや外観は2024年に発売された「Galaxy S24」「Galaxy S24 Ultra」から大きな変更はない。一方で、サムスン電子がUnpackedで全面に打ち出したのは、「Galaxy AI」や「Gemini」の進化だった。こうした点から、サムスン電子の新たなAIスマホ戦略が垣間見える。 Galaxy S24シリーズの目玉機能「Galaxy AI」を全方位で検証 スマホ体験が大きく拡張される!

Galaxy S24シリーズの目玉機能「Galaxy AI」を全方位で検証 スマホ体験が大きく拡張される!

Galaxy AIの(ほぼ)全機能をスマホでレビュー。通話翻訳や文字起こし、要約……多彩な新機能を徹底解説する。 「Galaxy S24」はAIでスマホの使い勝手を刷新 Google/Microsoftとの“等距離外交”も強みに

「Galaxy S24」はAIでスマホの使い勝手を刷新 Google/Microsoftとの“等距離外交”も強みに

サムスン電子が新たに発表した「Galaxy S24」シリーズでは、新機軸としてAIを全面的に打ち出している。一連の機能をまとめた「Galaxy AI」は、Googleが下支えをしている。同モデルからは、2大プラットフォーマーとの等距離外交で差別化を図るサムスン電子の戦略も透けて見える。 「Galaxy AI」を打ち出すサムスンの端末戦略を解説 AI対応が“処理能力”だけで決まらないワケ

「Galaxy AI」を打ち出すサムスンの端末戦略を解説 AI対応が“処理能力”だけで決まらないワケ

サムスン電子は、4月11日にフラグシップモデルの「Galaxy S24」「Galaxy S24 Ultra」を発売する。最大の特徴は、Googleの「Gemini Pro」や「Gemini Nano」などをAIモデルのベースにした「Galaxy AI」を端末の機能として密接に統合しているところにある。一方で、Galaxy AI自体はGalaxy S24/S24 Ultraだけでなく、アップデートを通じて過去のモデルにも適用される。 通話翻訳や文字起こしの「Galaxy AI」、折りたたみスマホ「Galaxy Z Flip5」「Galaxy Z Fold5」などにも搭載

通話翻訳や文字起こしの「Galaxy AI」、折りたたみスマホ「Galaxy Z Flip5」「Galaxy Z Fold5」などにも搭載

Samsung Electronics(サムスン電子)製の新型スマートフォン「Galaxy S24シリーズ」。その目玉機能となる「Galaxy AI」が、折りたたみスマートフォンなどにも搭載される。Galaxy AIにより通話時の翻訳や文字起こしが可能になる。