これからの時代に求められるデータ分析基盤「ラムダアーキテクチャ」を「Microsoft Azure」で実現するには?

ビッグデータ分析が注目されて久しいが、現代のビジネス界ではITの進歩に伴い、取得できるデータの量や種類が増大している。そのため企業側も、データ分析基盤のアーキテクチャを見直し、膨大なデータの処理に対応しなければならない。日本マイクロソフトはこのほど開催したセミナーで、これからの時代に適したデータ分析基盤の仕組みとして「ラムダアーキテクチャ」を挙げ、自社のクラウドサービス「Microsoft Azure」を使って構築する方法をレクチャーした。

「これからのデータ分析の在り方は、これまでの分析とは大きく異なってくる」――株式会社ジールと日本マイクロソフトが9月上旬に共催したセミナーで講師を務めた、ジール シニアコンサルタントの永田亮磨氏はこう強調した。

永田氏によると、従来のデータ分析は、「今、何が起きているのか」を導き出し、経営層がKPIの進捗(しんちょく)状況を把握するなど、過去の事象が起きた要因・背景を認識するために使われていた。

だが現在は、ITの進歩に伴い、収集できるデータの量(Volume)、発生頻度(Velocity)、多様性(Variety)の“3V”が飛躍的に増大している。機械学習やAI(人工知能)を用いたデータ分析も発展し、より複雑な分析を行える環境も整ってきた。

そのため、「今後のデータ分析は『これから何が起こるのか?』『どうしたらそれを起こせるのか?』といった“直近+未来”の予測ができるまでに発展するだろう」と永田氏は予測する。

ただ、分析対象のデータが大容量化し、分析手法も高度化すると、それに合わせて分析基盤のアーキテクチャにも変化が求められるのは当然の流れだ。今後、分析の幅がさらに広がるならば、分析基盤はどう変わっていくべきなのだろうか。

これからの時代に求められる「ラムダアーキテクチャ」とは?

永田氏によると、現在の分析基盤のアーキテクチャは、企業内に散在するデータを集約したDWH(データウェアハウス)がベース。RDB(リレーショナルデータベース)などのデータソースにあるデータをETLツールを使って抽出・加工し、DWHに蓄積した上で分析を行うのが一般的だ。

だが永田氏は、「これでは処理能力などの面で、今後“3V”の増大に対応できなくなる恐れがあるため、改善は避けては通れない」と指摘。「今後のデータ分析基盤を考える上では、従来のアーキテクチャからいったん離れ、“3V”が増加しても高い処理能力を維持できる構造を考えねばならない」という。

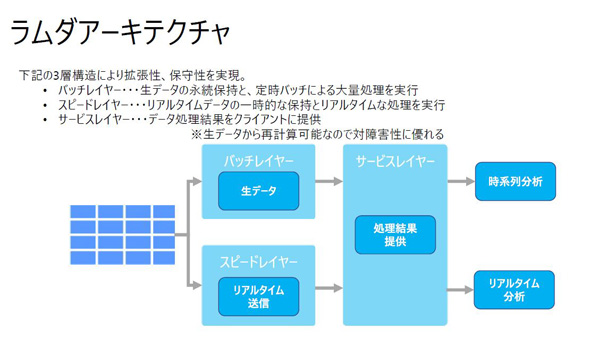

同氏は、“3V”の増加に対応できる構造の代表例として「ラムダアーキテクチャ」を挙げた。これは、バッチ処理で大量のデータを分析する「バッチレイヤー」、いま起きていることをリアルタイム処理で分析する「スピードレイヤー」、そして処理結果を提供する「サービスレイヤー」――の3層でデータを処理する構造で、拡張性と保守性の高さが特徴だという。

「ラムダアーキテクチャは、バッチレイヤーに生データを常に保管し、サービスレイヤーでは加工結果のみを表示することで、障害が発生した場合でも再計算が可能になるメリットもある。これに近づく構造にすることが、“3V”に対応しうる処理能力を手に入れる上で重要だ」(永田氏)

データの蓄積方法はどう見直せばいい?

永田氏は続いて、ラムダアーキテクチャを実現する前提条件として、企業が見直すべきポイントを紹介。その1点目として「データの蓄積方法」を挙げた。

同氏によると、これまでのデータ分析の流れでは、分析シナリオを事前に用意し、データ蓄積先のスキーマを設計した上で、ETLツールで加工したデータを投入するのが通常だった。だがこの際、シナリオに沿ったデータを業務システムから抽出するため、それ以外のデータは加工のプロセスで捨てられていた。

しかし本来は、ビジネスでどんな分析が求められ、どんなデータが必要となるかは未知数のはずだ。そのため、「高度化する分析要求に対応するには、全てのデータを可能な限りそのままの状態(ネイティブフォーマット)で蓄積する必要がある」と永田氏は指摘する。

従来のデータ分析基盤はオンプレミスが中心で、ストレージの管理コストがかかっていたが、今はクラウドの技術が発展し、あらゆるフォーマットのデータを蓄積した場合でも、コストが激増したり、容量が足りなくなったりする恐れはあまりない。こうした時代の流れも、データをネイティブフォーマットで蓄積すべき理由の1つだという。

「CSVなどのように型を決めるのではなく、データを入れた後で構造を定義するよう、データの蓄積方法を見直すことが肝要だ。蓄積されたデータを利用する際にはじめてデータ構造を定義する『スキーマオンリード』の考え方へと方針転換し、多種多様な大量データを保持できるリポジトリ『データレイク』を活用する。そうした考えに基づいて構築することが、ビッグデータに対応できるアーキテクチャの実現に近づく」(永田氏)

オンプレミス環境での統合処理プラットフォームはPaaSに切り替えるべき

続いて永田氏は、2つ目の改善点として「プラットフォームの仕組み」を挙げた。これは主に、クラウドではなくオンプレミスでデータ分析基盤を構築している企業向けの助言だという。

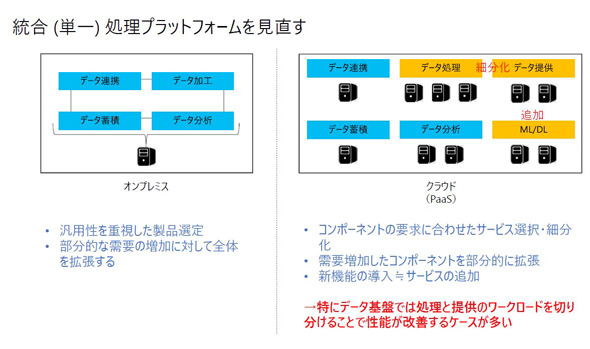

オンプレミス環境でのデータ分析基盤は、汎用性を重視し、データ連携・加工・蓄積・分析をセットにしたものが多い。ただこの基盤では、「データ加工には高いスペックが必要だが、分析にはそれほどのスペックは求められない」といったケースが起きた場合、個別の対応ができず、サーバ全体をスケールアップする必要がある。仮にこうした分析基盤を使い続けた場合、いずれは“3V”に対応できなくなるのは自明だ。

一方、近年はクラウド(主にPaaS)の技術が進化し、導入した場合は特定の機能(コンポーネント)のみを拡張することが可能となっている。「特にデータ基盤では、データ処理と提供のワークロードを切り分けることで、性能が改善するケースも多い」(永田氏)という。

データ処理基盤をクラウド化すると、リアルタイム処理には欠かせない、HadoopやSparkといった分散処理フレームワークを導入しやすいメリットもある。また、利用するコンポーネントを選ぶことで、BIレポートやリアルタイムレポートなどさまざまな分析結果を算出できる。

そのため永田氏は、「企業は統合(単一)処理プラットフォームをPaaSに切り替えてコンポーネントを細分化し、要件に応じて組み合わせることが重要だ」と説いた。

データフローの改善も不可欠

永田氏はさらに、3つ目の改善点として「データフロー」を挙げ、全てのデータを共通のフローで扱うのではなく、処理頻度に合わせたパスを構築し、それぞれのフローを簡素化することの重要性も説いた。

同氏によると、ビッグデータの処理は、処理頻度や要件によって「コールドパス」と「ホットパス」の2つに大別できる。「コールドパス」は定期的なスケジュールで実行されるバッチ処理を、「ホットパス」はリアルタイム処理を意味する。「従来のシステムはこれらを単一のデータフローで実現するケースが多かったため、フローが複雑化し、性能に影響を与えることもあった」(永田氏)という。

一方のラムダアーキテクチャは、「コールドパスとホットパスを分離し、それぞれの処理頻度に沿ったデータパスを構築することで拡張性や保守性を確保できるため、性能の維持には不可欠だ」と永田氏は強調した。

セミナーの前半パートは以上で終了。以降の後半パートでは永田氏に加え、日本マイクロソフトでData&AI Specialistを務める武田雅生氏も加わり、「Microsoft Azure」(以下、Azure)を使ったデータ分析基盤のアーキテクチャを紹介した。

武田氏によると、日本マイクロソフトはAzureの導入企業向けにデータ処理基盤のリファレンスアーキテクチャを多数用意しているが、その多くをラムダアーキテクチャで構成しているという。

中でも、Azure PaaSのデータ分析プラットフォームには、あらかじめいくつかのソリューションシナリオを用意しており、これらをベースに個々の環境に応じてカスタマイズを可能にしているという。

ソリューションシナリオ「Modern Data Warehouse」の強みとは

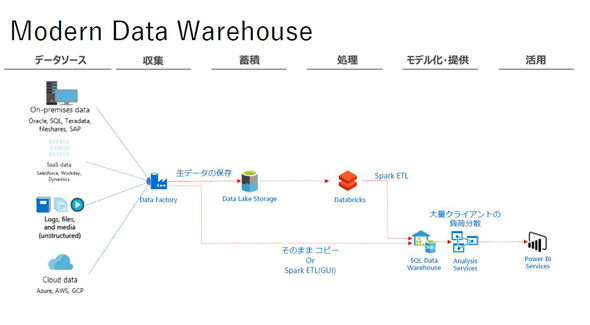

両氏はセミナーでいくつかのソリューションシナリオを紹介したが、その中で最も強調したのが「Modern Data Warehouse」(以下、Modern DWH)だ。

Modern DWHは、DWHに全てのデータを集約したいユーザー向けのシナリオで、収集・蓄積・処理といった一連のETL処理を行ったのち、データ活用へとつなぐ構成となっている。前述のデータレイクを用いている点が特徴で、「データがネイティブフォーマットのまま蓄積されるため、これまで分析対象でなかったデータでも即座に探索が可能となる」(永田氏)のが強みだ。

ただ、ドキュメントやバイナリデータなど、さまざまな形式のデータをデータレイクに蓄積するためには、各業務システムから必要なデータを収集せねばならない。そのため、「このソリューションシナリオに基づいてアーキテクチャを組む場合は、開発前にデータの棚卸しが不可欠だ」と武田氏は語る。

「将来的にどういうデータが想定され、どのような頻度で発生するのかを想定し、データの特性や流れを踏まえてアーキテクチャを組むことが、実務で役立つ分析基盤を構築する上で有用だ」(武田氏)

参照用DWHの柔軟性もメリット

データレイクを使っている点だけでなく、参照用DWH「Azure SQL Data Warehouse」の柔軟性を生かしている点もModern DWHの特徴の1つだ。

Azure SQL Data Warehouseは、コントロールノード・コンピュートノード・ストレージの3層が分離しており、処理リソースと容量を切り分けてプランを組むことが可能。スモールスタートから拡張していくなど、負荷に応じて柔軟に運用できるメリットがあるという。

一方、一般的なDWHは、データを処理するコンピューティングノードと、データを保存するストレージが一体化したアーキテクチャになっており、スケールを変更する際は双方をセットで拡張する必要があった。そのため、「大量のデータを保持しているが、処理能力はそこまで必要ではない」といった場合に、コストが最適化できない問題が生じていたが、このソリューションシナリオを使うことで改善できるという。

セミナーではこの他、機械学習を取り入れた「Advanced Analytics」、スピーディーなデータ分析に特化した「Realtime Analytics」の両シナリオが紹介された後、実際に日本マイクロソフトが制作したリファレンスやシナリオをベースにアーキテクチャを構築した企業の事例が示された。

武田氏によると、多様な業界・業種の企業が自社のニーズに合わせて「Azure Databricks(Spark)」や「Azure Data Factory」といったコンポーネントの中から最適なものを選んでアーキテクチャを構築しており、中にはビッグデータの処理性能を30倍に高め、かつコストの9割を削減できた企業もあるという。同氏は「ユーザー企業は、データ分析の精度と効率の両方を実際に改善できた」と実用性を強調した。

武田氏は「当社のリファレンスやシナリオをベースにすれば、ゼロベースから始めるよりはるかに短時間で、はるかに高品質な分析プラットフォームを構築できる。より良い分析環境をスピーディーに築き上げ、お客さまのビジネスを支援していきたい」と力強く語り、セミナーを締めくくった。

自社のアカウントでAzureを使えるハンズオンセミナーも開催

日本マイクロソフトはこのセミナーの終了後、Azureを使ったデータ分析基盤の構築を体験できるハンズオンセミナーを日を改めて開催した。プロトタイプ環境の構築、ETLの構築と利用、Azure SQL Data Warehouseの活用などを実際に行うプログラムで、勤務先でAzureを使っている参加者は自社のアカウントをそのまま使えるメリットがある(アカウントがない場合は同社が環境を用意する)。会場にはスキルアップを目指す参加者が詰めかけ、永田氏のアドバイスを聞きながら、真剣な面持ちで作業に取り組んでいた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

提供:日本マイクロソフト株式会社

アイティメディア営業企画/制作:ITmedia NEWS編集部/掲載内容有効期限:2019年11月27日

セミナーのお知らせ

開催日:2019年11月26日 14:00〜17:00 (受付13:30〜)