M4 Maxチップ搭載「16インチMacBook Pro」の実力をチェック 誰に勧めるべきモデルなのか?(4/4 ページ)

Apple Siliconの最新かつ(現時点で)最強のパフォーマンスを備える「M4 Maxチップ」。1ランク下「M4 Proチップ」が想像以上に高パフォーマンスなこともあり「それ以上いるの?」と思われがちだ。本当のところはどうなのか、16インチMacBook Proを通して実際に試してみよう。

「高性能GPU×共有メモリ」でLLMのパフォーマンスは良好

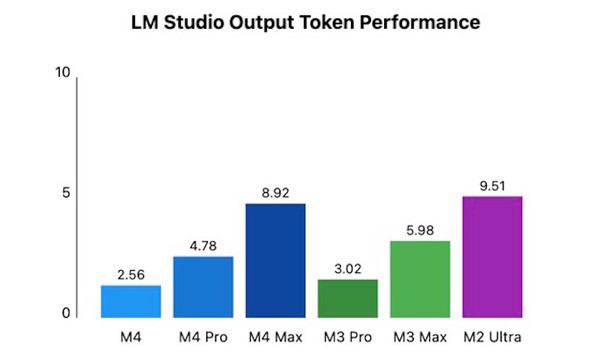

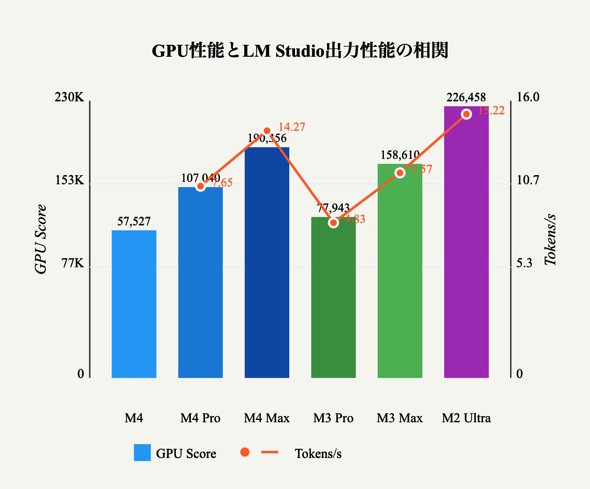

今回は「LM Studio」のパフォーマンスも検証した。LM Studioはオープンソースの大規模言語モデル(LLM)を動かすためのアプリで、いわゆるチャット型のAIアシスタントをオンデバイスで実行可能だ。

ここではLLMの性能テストが直接の目的ではないが、比較的規模が大きく、実用性の高そうなモデルとして「Qwen2.5 Coder 32B Instruct」を使うことにした。評判の高い「Llamma 3.2」向けAIモデル「Qwen2.5」を、プログラマー向けにトレーニングしたものだ。ランタイムの実装はAppleのGPUライブラリ「Metal」を用いており、推論演算に特化したNPU「Neural Engine」は利用しない。

LM Studioをテストに用いた理由は、M4チップファミリーを搭載する新型MacBook Proが発表されたときに、Apple自身が「このアプリの強力な開発プラットフォームになり得る」と訴求していたからだ。実際にテストをしてみると、Appleがそう主張した理由が分かった。Apple Siliconの広帯域共有メモリがLLMを稼働する際に極めて有利に働くからだ。

テストに用いたAIモデルは、日本語の質問にはあまり良い品質の回答は得られないが、プログラミングの補助に使うのであればそこそこ使える感じだ。このモデルは320億パラメーターで、容量が17GB以上ある。

このモデルをTUF Gaming A16(FA607PI)で動かすと、全く話にならないほど文字出力が遅い。GPU(GeForce RTX 4070 Laptop)のグラフィックスメモリが8GBしかなく、AIモデルを収納しきれないからだ。結果としてGPUには一部の処理が割り振られるだけで、大部分(今回であれば95%)がCPUに回されてしまう。

その点、今回試したM4ファミリーのMacでは、M4チップ以外は共有メモリ内にAIモデルを格納できた。よって、GPUの性能をフルに生かすことも可能だった。結果はグラフの通りだが、「これをローカルで動かす必要があるのか」という議論はさておいて、将来的にローカルAIを実用レベルで動かせそうということはよく分かった。

LLMをローカルで動かす利点として、より長いコンテクストに対応するための文脈を保存するためのメモリをより多く確保しやすいという利点がある。見方を少し変えると、より長いプログラム(コード)を作る際に、過去の指示履歴をより多く覚えておいてくれるということになるので、「プログラミングの補助」としてLLMをローカル稼働させることは一定のメリットがあるかもしれない。ただし、ローカルで動かすLLMがより賢く、本当に使い物になるまでは、もう少し時間がかかるだろう。

ともあれ、今回のテスト結果を通して外付けGPUで扱いきれないサイズのデータを扱う場合は、Apple Siliconの共有メモリアーキテクチャは有利に働きやすいということがよく分かった。自身が使うアプリごとに状況は異なるが、このことは心に留めておきたい。

「M4 Maxチップ」がもたらす価値はどこにある?

先ほど「M4 Proチップのコストパフォーマンスの良さが際立つ」旨を述べたが、もちろんハイエンドのユースケースにおいてM4 Maxチップが有益であることは間違いない。

アプリテストを通して見てみると、一部に思ったほどの差が出ていないように思える部分もあるかもしれないが、かなり極端な処理を行うと、テストでは表に出ない差が出ることもあることは別途把握しておくべきだろう。

その典型例がメディアエンジンの構成だ。M4 Proチップのメディアエンジンは、ビデオエンコード/デコードエンジンとProResアクセラレータを1基ずつ備えるのに対し、M4 Maxチップではこれらを2基ずつ搭載している。

単純計算すると、M4 MaxチップはM4 Proチップの2倍の動画処理パフォーマンスを備えていることになる。具体的には、M4 Maxチップでは4K解像度のProResビデオを最大66ストリーム、8K(7680×4320ピクセル)解像度のProResビデオを最大15ストリーム同時処理できるが、M4 Proチップでは4K解像度のProResビデオは最大37ストリーム、8K解像度のProResビデオは最大8ストリームと、同時処理数が半分程度になっている。

メディアエンジンを完璧に使いこなすApple純正の動画編集アプリ「Final Cut Pro」を使う場合、同時処理能力差は約1.8倍とのことで、上記の性能差とほぼ一致する。このこと自体は先にテストしたDaVinci Resolveでも同様なのだが、アプリの応答速度をトータルで見てみると、そこまで大きな差は出てこない。

M4 Proチップは研究者、開発者、エンジニア、クリエイティブプロフェッショナルなど、高度な処理能力を必要とするユーザー全般に適している。

一方、M4 Maxチップは8K動画編集、複雑な3DCGレンダリング、大規模な機械学習モデルの学習など、極めて高負荷な作業を行うプロフェッショナルに最適な選択肢だ。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

M4ファミリー搭載Macは新規や買い増しだけでなくM1/M2ユーザーの買い換えにもお勧め――使い比べて分かったこと

M4ファミリー搭載Macは新規や買い増しだけでなくM1/M2ユーザーの買い換えにもお勧め――使い比べて分かったこと

先日、M4/M4 Proチップ搭載の新型Macの“パフォーマンス”をチェックした。この記事では、新型Macの注目ポイントをスペック以外の面から見ていきたい。 新型Macに搭載された「M4チップ」「M4 Proチップ」の実力は? 実機をテストして分かったこと

新型Macに搭載された「M4チップ」「M4 Proチップ」の実力は? 実機をテストして分かったこと

11月8日にM4チップファミリーを搭載するMacが一気に登場する。パフォーマンスはいかほどか、実機で試してみよう。 Appleはなぜ“Mac週間”でラインアップを更新したのか 透けるIntelチップからのリプレースとAIへのこだわり

Appleはなぜ“Mac週間”でラインアップを更新したのか 透けるIntelチップからのリプレースとAIへのこだわり

3日連続でMacの新モデルを発表したApple。その締めくくりは「MacBook Pro」となった。MacBook Proも含む発表内容を俯瞰(ふかん)すると、IntelチップからのリプレースとAIへのこだわりが見えてくる。 なぜ“まだ使えない”Apple Intelligenceを推すのか? 新製品から見えるAppleの狙い

なぜ“まだ使えない”Apple Intelligenceを推すのか? 新製品から見えるAppleの狙い

Appleが、毎年恒例の9月のスペシャルイベントを開催した。順当に発表された新型iPhoneでは、生成AIを生かした「Apple Intelligence」が推されてるのだが、当のApple Intelligenceは発売時に使うことはできない。なぜ、発売当初に使えない機能を推すのだろうか。新製品の狙いを見ていこう。 “後出し”の生成AI「Apple Intelligence」がAppleの製品力を高める理由

“後出し”の生成AI「Apple Intelligence」がAppleの製品力を高める理由

生成AIにおいて出遅れを指摘されているAppleが、開発者向けイベントに合わせて「Apple Intelligence」を発表した。数ある生成AIとは異なり、あくまでも「Apple製品を使いやすくする」というアプローチが特徴だ。