どの機能も実装してほしい――「Adobe MAX 2025」で披露されたAI機能が見せる“近未来”:本田雅一のクロスオーバーデジタル(4/4 ページ)

Adobeの年次イベント「Adobe MAX」で一番人気のセッションが、研究中/開発中の機能を披露する「Sneaks」だ。ここで紹介された機能をかいつまんで紹介しよう。

Project Trace Erase:あらゆる痕跡を消し去るAI

「Project Trace Erase」は、Photoshopで最もよく使われる用途の1つである“不要物の除去”を完璧かつ自動で実施できるようにするプロジェクトだ。

最初のデモは「駐車場に止まっている自動車を消す」という、一見するとシンプルなタスクだ。これは、もちろん従来の「削除」ツールでも行える。

では、Project Trace Eraseは削除ツールと何が違うのだろうか。Project Trace Eraseの場合、削除したい自動車を選択すると「路面に落ちる影」「隣のビルのガラスに映り込んだ反射」も自動選択してくれる。そして削除操作を行うと、自動車に付帯する影や反射も一度の操作で完全に消える。削除された跡を見てみると、路面の影はなく自然に復元され、反射があったガラス面も、まるで最初から自動車がなかったかのようである。

要するに、クルマがあったという痕跡をまるごと消去できるのだ。

次に披露されたデモは「雑誌の写真から人物を消す」というものだ。こちらの場合も、人物の影はもちろん、ガラスへの反射が消され、その背後には完璧なディテールの背景が描かれた。

3D空間で演算していれば、ここまでは簡単にできそうだ。しかし「レストランでテーブルに煙が立ち上っている」といったシーンはどうだろうか。煙の向こうには背景が見えているだけではなく、その濃度は画素単位で異なり、複雑な形状をしているが、こちらもボタン1つでキレイに消すことができる。

この機能はAIの推論を用いて実現しているため、多様な場面で自動復元が可能だという。「新雪の中を歩いている人物を消す」というシチュエーションでは、人物だけでなく雪面に付いた足跡まで消え、復元した雪の質感や微妙な陰影は全て自然な形で復元(補完)された。まるで誰も歩いていなかったかのようだ。

「プールで水が跳ねているシーン」など、光学特性が異なる要素が混じり合うシーンでもキレイに指定した要素を消去して復元してくれる。プールの水を適切に推論し、その特徴を加味した処理を行うためだ。

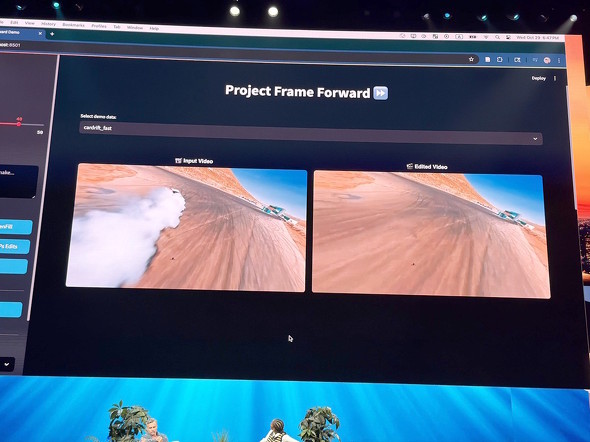

Project Frame Forward:1枚のフレーム編集を動画全体に反映

「Project Frame Forward」は、Premiere Proで利用することを想定して作られた。その核心は、単一フレームに施した編集を動画全体に適用させることにある。

実演では、3人がボートをこいでいる動画から、真ん中の人を消す例から始まった。動画の最初のフレームを抽出し、Photoshopに処理を渡して人を削除するのだが、これだけでは単なる「静止画の編集」だ。

しかし、この編集した静止画(フレーム)をProject Breakoverに戻すと、AIが元の動画と編集済みの静止画を分析し、静止画に加えた変更を動画全体に自動的に適用する。消した人物は動画内で動いているが、消された要素(人物)の動きをトレースし、全てのフレームで適切に除去した上で、背景は「生成塗りつぶし」で補完する。

処理にかかる時間は、ほんの数秒だ。

そして、Project Frame ForwardはProject Trace Eraseと同じく煙の除去に対応している。サーキットでタイヤスモークを上げながら自動車が疾走するシーンで、煙がフレームの大部分を覆っていた。

このシーンから手作業で煙と自動車を除去すると、4時間かかったという。しかし、Photoshopで最初のフレームにある煙と自動車を除去した後にProject Breakoverに戻すと、全てのフレームから煙と自動車を自動で除去し、背景の山々、コースのマーキング、そして観客席のディテールまで復元した。

Project Frame Forwardでは、逆にオブジェクトを追加することもできる。ネコの動画の1つのフレームに水たまりを追加すると、動画全体にその水たまりが“伝播”する。重要なのは、静止画で生成された水たまりの反射が、ネコの動きに合わせて適切に変化することだ。水面に映るネコの姿が、各フレームで正確に更新される。これは、AIが水面の物理的な振る舞いまで理解していることを示している。

ちなみに、1フレーム目の画像にレタッチ(明るさや彩度などの調整)を施してからProject Frame Forwardに引き渡すと、動画全体の色調補正/露出調整/コントラスト変更を行ってくれる。かなり便利な機能だ。

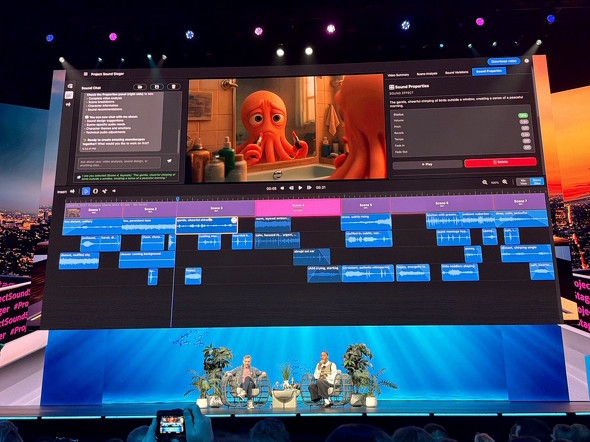

Project Sound Stager:動画の効果音を自動デザインするAI

動画に適切な音響効果を付けることは、専門的なスキルを要するだけでなく、なかなか面倒な作業だ。しかし、「Project Sound Stager」を使うと、動画を自動的に分析して適切な効果音を付与してくれる。

今回のデモでは、「タコの家族」をテーマにした日常生活を記録したビデオブログ(Vlog)に効果音を付けていた。朝起きて、子供たちを学校に送り、仕事をして帰宅するという、ありふれていながらもユーモラスな内容だ。

この動画をSound Stagerに読み込ませると、AIが全体を分析してシーンを識別し、各シーンで“何が起きているか”を理解する。そして適切な効果音を自動生成し、配置する。目覚まし時計の音、バックパックのファスナー音、ドアの開閉音、車のエンジン音、学校の環境音、オフィスの環境音にコーヒーメーカーの音――全てが適切なタイミングで流れ、動画の内容と完璧に同期していた。

Project Sound Stagerで付与された音源は、Premiere Proの中でそれぞれが独立したトラックとして管理される。マルチトラックビューを開けば個別に編集可能だ。例えば目覚まし時計の音やボリュームが気に入らなければ、AIが生成した別のバリエーションに差し替えたり、音量を変えたりできる。

追加の演出をしたい場合は、プロンプトで指示可能だ。「school ambient(学校の環境音)」を追加したいと指示すると、AIが適切な環境音を生成し、学校のシーンの適切な位置に配置してくれる。「car engine sound(自動車のエンジン音)」を要求すれば、自動車が映っているシーンを認識してエンジン音を追加する。

効果音のライブラリーを検索したり、権利処理を心配したり、タイミングを細かく調整したりする手間は、ほとんどかからない。AIが文脈を理解し、適切な判断をしてくれるからだ。

Project Turn Style:視点を自由に変える

2024年のSneaksセッションで「Project Turntable」として披露されたIllustrator向けの技術は、現在β版アプリに実装されている。今回最後に紹介された「Project Turn Style」は、Project TurntableのPhotoshop版に当たるもので、簡単にいえば1枚の写真から任意の視点の画像を生成してくれる。

ハロウィーンのカボチャ飾りの写真を使った実演では、正面から撮影された写真を、まるで3Dモデルのように回転させることができた。側面/背面/俯瞰(ふかん)と、あらゆる角度からの画像を生成してくれる。単なる変形ではなく、元の写真では見えていなかった部分まで、適切なディテールで補完される。

ただし、視点変更後の画像は元の写真よりも解像度が低くなる……のだが、「Upscale」機能を使うと元の写真を参照しながらAIがディテールを復元してくれる。

最後のデモでは、Photoshop起動時のイラストとしても使われていた鳥人物の絵を用い、視線を変えるというもの。元の絵では右を向いている鳥人間を正面に向かせることに成功した。

AI技術がクリエイティブにもたらすもの

Adobe MAX 2025のSneaksセッションで披露された10のプロジェクトに共通しているのは、AIが単なるパターン認識を超えて、物理法則や空間構造、因果関係といった“理解“を示し始めていることだ。Project Light Touchは光の物理的な振る舞いを理解しているし、Project New Depthsは3D空間を理解している。Project Motion Mapは、チェスのルールという論理体系を理解している。

これらの技術が示唆するのは、クリエイティブツールが「指示を実行するだけの道具」から、「意図を理解し補完するパートナー」へと進化しつつあることだ。クリエイターは「どうやって実現するか?」という、ツールを使いこなすための手順に悩まされることなく、「何を表現したいか?」という本質的な創造に集中できるようになる。

しかし、この進化は同時に重要な問いも投げかけている。Project Clean Takeで使われるような音声編集技術は、「発言の改変」という観点から懸念を呼ぶだろう。誰かの言葉を本人の同意なく変更できてしまうからだ。Project Frame Forwardのようなほぼ完璧な除去技術は、歴史的な記録の改ざんに悪用される可能性も否定できない。写真から人物を消し、その痕跡まで消し去ることができれば「その人物は最初からそこにいなかった」という“虚偽の証拠”を作れてしまう。

Adobeが「Content Authenticity Initiative(CAI)」を通してデジタルコンテンツの出所と編集履歴を記録する取り組みを主導してきたのは、こうした機能が一般化することを想定してのことだろう。

CAIは、コンテンツの“真正性“を担保すると共に、改変した場合の履歴を証明する仕組みだ。強力な編集技術が実装される際には、同様に強力な透明性確保の仕組みが不可欠となる。Adobe製品は既にCAI対応が進んでおり、履歴/改変情報はCAIが用意したビューアーで簡単に履歴確認できることが、もっと知識として広がる必要もある。

Sneaksセッションで示される技術の多くは早ければ公表された翌年、遅くとも3年以内に製品化されることが多い。2028年〜2030年頃には、ここで紹介したような機能はごく当たり前になっているだろう。

2025年のSneaksセッションが示したのは、AIが人間の創造性を置き換えるのではなく、解放し、拡張する未来だ。技術的な制約から自由になったクリエイターが、どんな作品を生み出すのか――それを見られる日が、今から楽しみだ。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

アドビが「Creative Cloud」を2026年版にアップデート 主力アプリに新しいAI機能/AIモデルを実装

アドビが「Creative Cloud」を2026年版にアップデート 主力アプリに新しいAI機能/AIモデルを実装

アドビのサブスクリプションサービス「Adobe Creative Cloud」が2026年版にアップデートする。この記事では、その概要をお伝えする。 合法的な「コンテンツ利用」と「生成AI活用」の実現に向けての第一歩 アドビがクリエイター支援ツールに取り組む理由

合法的な「コンテンツ利用」と「生成AI活用」の実現に向けての第一歩 アドビがクリエイター支援ツールに取り組む理由

アドビが、デジタルコンテンツの来歴を記録するWebアプリ「Adobe Content Authenticity」をパブリックβとして提供を開始した。生成AIが当たり前に使われるように今だからこそ、コンテンツの来歴や権利をしっかり管理することで、クリエイターの新しいチャンスにつなげることが必要だ。 「Adobe Creative Cloud」の主要アプリ/サービスがアップデート 使い勝手の向上に力点

「Adobe Creative Cloud」の主要アプリ/サービスがアップデート 使い勝手の向上に力点

アドビが「Adobe Creative Cloud」の主要アプリ/サービスと「Adobe Express」のアップデートを行った。使い勝手の向上に力点が置かれている。 Adobe Premiere Proに90種以上の新エフェクトやトランジション効果が追加される Film Impactのライブラリ統合で

Adobe Premiere Proに90種以上の新エフェクトやトランジション効果が追加される Film Impactのライブラリ統合で

動画編集ソフト「Adobe Premiere Pro」に90種類以上の新しいエフェクト、トランジション、アニメーションが追加される。 アドビ、Photoshopの合成/削除機能を強化する7月アップデートを実施

アドビ、Photoshopの合成/削除機能を強化する7月アップデートを実施

新機能は同日から利用できるようになる。