AI戦国時代、日本企業はどう動く?――国産LLM&AI半導体を開発中のPFN・岡野原代表のシナリオ(2/3 ページ)

オンラインイベント「ITmedia AI+ Boost」で、Preferred Networks(PFN)の代表取締役 最高研究責任者である岡野原大輔さんが基調講演を行った。ChatGPTやClaudeなどが世界をリードする中でも、国産AIの存在感を高める方策を示した。

AIモデルを小型化しても高い性能を維持する技術や、KVキャッシュ(トークンを保存するメモリ領域の一つ)の効率化、ハードウェアの改良などが組み合わさった結果、コストは「毎年およそ1/10のペース」で低下しているとみられている。

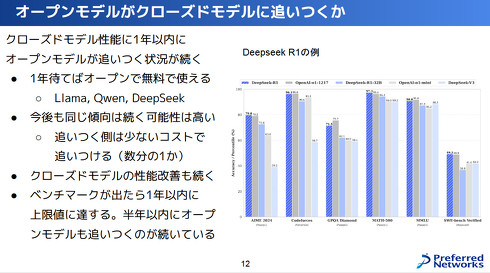

また、AI業界には面白いサイクルが生まれている。米OpenAIや米AnthropicなどによるクローズドなAIモデルが登場すると、半年から1年後には米MetaのLlamaや中国Alibaba CloudのQwen、中国DeepSeekなどのオープンモデルがほぼ同等の性能に追い付くという流れだ。

クローズド側もさらに改良を重ねるため、常に追いかけられる立場ではあるが、この「半年〜1年のギャップ」をどのように生かし、新サービスを先に展開するかがビジネス上の焦点になってきている。

国産LLM「PLaMo」シリーズの挑戦

こうした世界的な競争の中、PFNは、経済産業省による国内の生成AI開発を推進する「GENIACプロジェクト」の一環で、優れた日本語性能を持つLLM「PLaMo」(Preferred Language Model)シリーズを開発してきた。最大の特長は、日本語の理解と生成に強みを持つ点だ。

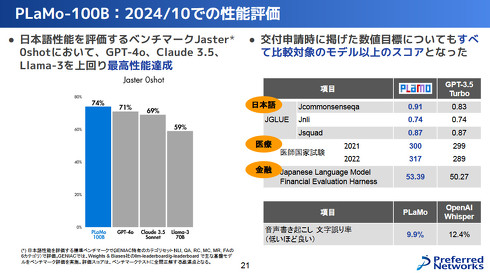

24年10月時点の評価では、1000億パラメータの「PLaMo-100B」が日本語性能の総合テスト「Jaster」においてGPT-4oやClaude 3.5 Sonnetを上回るスコアを記録し、正答率74%(GPT-4は71%)を達成。医師国家試験や金融関連の試験でも高い性能を示したという。

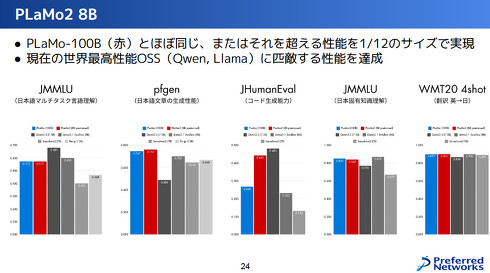

さらにGENIAC第2期では、「PLaMo2 8B」という80億パラメータの小型モデルを開発中だ。これは従来の12分の1の規模でありながら、100Bモデルに匹敵する性能を発揮する。

日本語の固有知識や専門領域における理解力でもトップクラスとのことで、小型化による導入しやすさとファインチューニングの容易さが大きな強みだ。これなら医療・金融分野など、機密データを扱う企業がオンプレミス環境で扱う際のハードルも下がる。中小企業や特定業界向けのAIソリューション開発が一気に進む可能性もある。

PFNはこれまで、大規模かつ高品質なデータセットの構築に力を入れてきたという。1000億トークンを超える膨大な日本語データを集めるだけでなく、LLM自身を活用してデータをフィルタリングしたり、読みやすく再編成したりする工程も取り入れ、性能を一段と高めているのだ。

これらの成果をもとに、PFNは24年12月より「PLaMo Prime」をクラウドサービスとして提供中。100万トークン当たり入力300円・出力1000円で、1万6000トークンの長文処理や文書検索(RAG)、関数呼び出し機能などもサポートする。

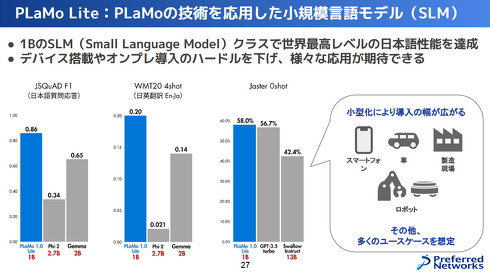

さらに10億パラメータ規模の「PLaMo Lite」も24年8月から提供中だ。これは最新のスマートフォン向けプロセッサ上で毎秒70トークン前後の処理が可能なSLM(小規模言語モデル)。クラウドに頼らず手元の端末で高度な言語処理が行えるため、製造現場やロボットなどエッジ環境での利用が現実的になる。

Copyright © ITmedia, Inc. All Rights Reserved.