生成AI市場で海外勢の巨大モデルが席巻する中、NTTが"小さく賢い"国産LLM「tsuzumi2」で反撃に出た。競合が数千億パラメータを競う中、同社は小型モデルに照準を定めた。1GPUで動作する軽量性を武器に、企業の機密データ活用という成長市場を狙う。

オンプレミス環境で動く純国産モデルは、経済安全保障を重視する企業の選択肢となり得るのか。2027年度にAI関連事業5000億円を目指す同社の勝算を探った。

「1GPUで動かせる」サイズに賭けたNTT 世界の大規模モデルに勝てるのか

生成AI業界の主戦場は、大規模化だ。OpenAIのGPT-4は推定で1兆パラメータを超え、GoogleのGeminiやMetaのLlamaも数千億パラメータ級のモデルを投入している。性能向上にはパラメータ数の拡大が欠かせないというのが、業界の常識だ。

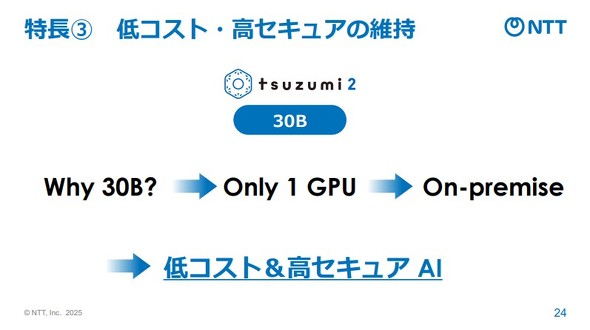

だがNTTは10月20日、この流れに相反する製品を発表した。大規模言語モデル「tsuzumi2」。パラメータ数は300億(30B)にとどまる。競合の10分の1以下という規模である。

島田明社長は記者会見で「経済効率を追求しつつ、いかに性能を高めていくかにフォーカスした」と語った。300億パラメータという規模は、GPU1基で動作する。クラウド上で提供される大規模モデルと異なり、企業が自社のサーバ内で運用するオンプレミス環境でも導入できる規模だ。

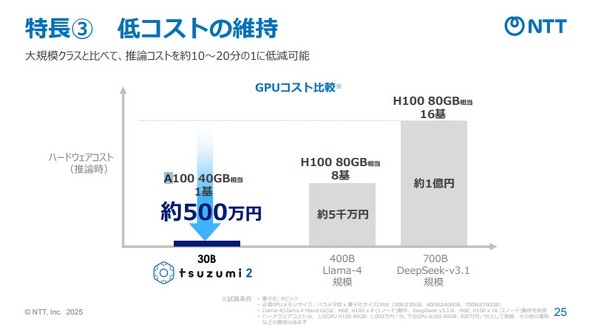

ハードウェアコストの差は歴然としている。tsuzumi2なら約500万円で済む。一方、競合の大規模モデルを動かすには、GPU8基から16基が必要で、コストは5000万円から1億円に跳ね上がる。

NTTは2024年3月に初代tsuzumiを70億(7B)パラメータで商用化した。だがユーザーから「もう少しパワーが欲しい」という要望が寄せられた。研究開発マーケティング本部長の木下真吾氏は「1GPUで動かせるサイズとして最適だから300億パラメータにした」と説明する。GPU自体の性能向上に伴い、1基で扱えるパラメータ数の上限も上がってきた。その「スイートスポット」を狙った判断だという。

小型だが性能は犠牲にしない。NTTは40年にわたる日本語研究の蓄積を武器に、日本の文化や慣習を深く理解するモデルを、ゼロから構築した。島田社長は「基盤となるところは負けられない」と述べた。海外勢の大規模モデルとは異なる土俵で戦う意図が滲む。

だが、小型で本当に勝てるのか。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

Geminiを業務で使いこなす! Google Cloudが指南する「プロンプト入力」4つのポイントは?

Geminiを業務で使いこなす! Google Cloudが指南する「プロンプト入力」4つのポイントは?

GoogleのAI「Gemini」を業務で使いこなすには──? Google Cloudの担当者がレクチャーした。 野村が捨てた「資産3億円未満」を狙え SMBC×SBIが狙う“新興富裕層”の正体

野村が捨てた「資産3億円未満」を狙え SMBC×SBIが狙う“新興富裕層”の正体

SMBC×SBIが、「Olive Infinite(オリーブ インフィニット)」というデジタル富裕層向けサービスを開始した。野村證券をはじめとする大手証券会社が切った「1億〜3億円層」に商機があるという。 流入「80%減」 AI検索で大打撃を受けたHubSpotは、どうやって“未来の顧客”を取り戻した?

流入「80%減」 AI検索で大打撃を受けたHubSpotは、どうやって“未来の顧客”を取り戻した?

米HubSpotはAI検索の影響を大きく受け、ブログへのトラフィックが80%減少した。同社はどうやって“未来の顧客”を取り戻したのか。ヤミニ・ランガンCEOが語る。