iPhone 17 Proで話題になった「8倍光学品質ズーム」って何? そのメカニズムを解説(1/2 ページ)

iPhone 17 Proシリーズの発表当初、構成を変えたアウトカメラにおける「8倍光学品質ズーム」という表現が賛否を集めた。この表現が一体何を意味するのか、解説してみよう。

以前話題になった、iPhone 17 Proシリーズの「8倍光学品質ズーム」問題。一体どういうことなのか、ちょっと解説してみたい。

- →「iPhone 17 Pro/Pro Max」、カメラ「光学8倍」は誤解に SNSで指摘が相次ぐ 正しく伝えた競合メーカーは?

- →Apple、iPhone 17 Proのカメラ「8倍光学ズーム」表記を「光学品質ズーム」に修正

今回は「8倍」が話題になったけど(まあ数字がでかいからね)、今までも、多くのスマートフォンでメインセンサー(1倍)を使った「2倍ズーム」とか「2倍相当ズーム」とか「画質が劣化しない2倍ズーム」とか、いろんな表現が使われていた。メインカメラを基準(1倍)にしてその「2倍」「4倍」、そしてさらに2倍の「8倍」というわけである。

なので、メインカメラ(1倍)と「2倍ズーム」の話である程度の説明はできるので、3行で書くとこんな感じだ(カメラアプリでは倍率が「1x」「2x」という表記なので、ここからはそうします)。

- iPhoneはカメラを「1200万画素」を基準に考えている

- iPhoneのメインカメラは「4800万画素」のセンサーを搭載している

- 2倍望遠にすると写る範囲は4分の1なので、画素数も4分の1の1200万画素となる

よって、2xにしても画素数は“足りている”ので、「光学2倍ズーム」と変わらないといっても過言じゃないんじゃね? ということである。

4800万画素センサーなのに基準が「1200万画素」なのはなぜ?

……と、3行で説明を終えるのはあまりに申し訳ないので、大きく2つに分けて、もうちょっと解説していこう。まずは「その1」として、カメラの「センサー画素数」と「基準画素数」の話を。

iPhone 17 Proのアウトカメラは、超広角/メイン(広角)/望遠のいずれも4800万画素のセンサーを搭載している。しかし、基本的には撮影時は1200万画素を基準にしている。なぜなのだろうか?

実はこれ、Androidスマホのカメラも同様で、5000万画素や1億画素のセンサーを積んでいても、標準では1250万画素相当のサイズの画像を記録することが多い。

なぜiPhoneはセンサーサイズの4分の1を基準としているのか――理由は2つ考えられる。

理由1:過去との整合性

iPhoneの場合、ずっと1200万画素のセンサーを採用してきた。その上、メインカメラが4800万画素になっても、超広角/望遠カメラを1200万画素のまま据え置く時代もあった。

過去の経緯を踏まえると、1200万画素を基準とした方が、撮影における整合性を取りやすいということはある。実際には1x時のデフォルトの画像サイズは2400万画素(24MP)だったりするから面倒くさいんだけど、基準はあくまでも1200万画素だよ、ってことだ。

その2:センサーが“1200万画素出力”を前提としている

もう1つは、搭載している4800万画素センサーが1200万画素での出力を前提とした設計となっているから、ということもある。理由としては、こっちの方が大きいかなと思う。

その秘密は、4800万画素センサーに並んでいる画素の構造にある。ここからはちょっとややこしいので、興味ある人だけ読んでください。

まず、1200万画素のセンサーを考えてみる。センサー上には1200万個のフォトダイオードが超びっしりと並んでいる。フォトダイオード(PD)1つを1画素だと考えればいい。

フォトダイオードは「光の量」しか感知しない、いわばモノクロのセンサーだ。これだけではカラー画像を作れないので、1つ1つの画素に「あなたは『赤(R)』、あなたは『青(B)』、あなたは『緑(G)』を担当してくださいね」という感じで、それぞれの画素にR/G/Bのいずれかのみを感知するフィルターを付けてやる。「なぜRGBか?」というと、光の三原色だから。これら3色さえあれば、全ての色を作り出せる。

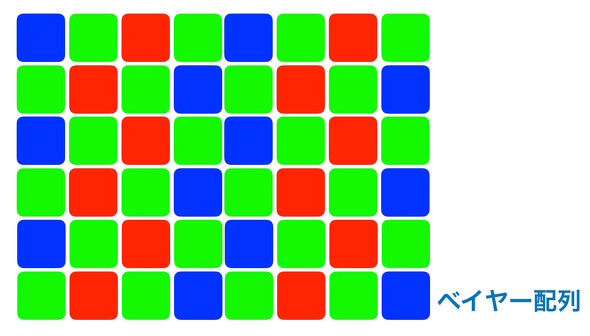

そのカラーフィルターの配列だけど、ブライス・ベイヤー氏が考案した「ベイヤー配列」というものが主流だ。ベイヤー配列はG成分を多めに配置した、いわば「RGBG」って感じの配列が特徴だ。これは、Gに輝度情報が多く含まれるためである。

1200万画素センサーの場合は「Gを600万画素、RとGを300万画素ずつ」という感じで配置しており、これらを組み合わせて「1200万画素のフルカラー画像」を生成している。

「え、それだと1200万画素のカラー画像を作るには、ちょっと足りなくならない?」って思うかもしれないけど、実際には周囲の画素の情報からうまいこと補完して、色を作っている。デジタルカメラの黎明(れいめい)期は、その補完のうまい/下手が画質に影響してたけど、今はそれを気にする人はいない。

カラーフィルターについては、ベイヤー配列以外にも配列はあるし、何ならRGBそれぞれの層を重ねて“ガチの”1200万画素画像を作れるセンサーもある(ガチのやつはディテールの描写力がめちゃ高くなる)。でも、それは話がややこしくなるので、今回はしない。今は、基本的にスマホもデジタルカメラも、カメラセンサーは基本的にベイヤー配列を使っている(といっていいはずだ)。

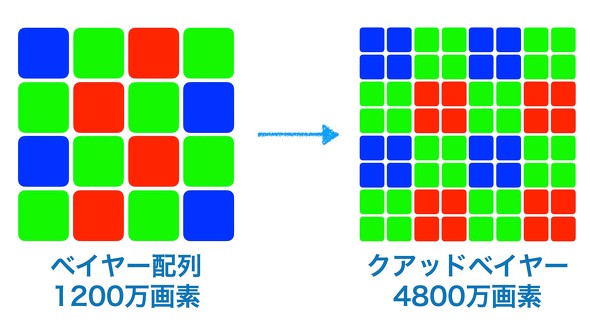

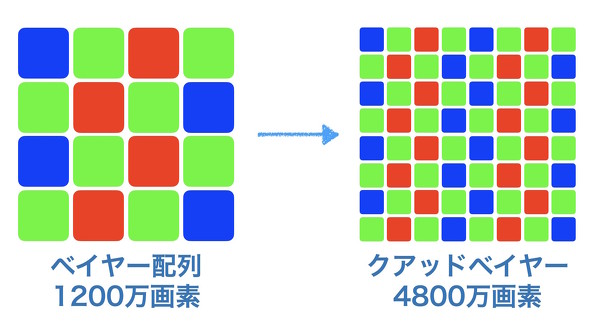

では、センサーのサイズは変えないで、4800万画素化してみよう。普通に考えると、以下の図のようになる。より画素を細かくするわけだね。

これだと1つの画素がより小さくなるため、1画素が受けられる光の量が減り、感度が落ちてノイズの影響が大きくなってしまう。

しかし、今のスマホが採用している4800万画素のセンサーはそうはなってない。「クアッドベイヤー配列」といって、同じ色を4画素ずつまとめた構成になってるのだ。

これ、初めから4画素を1つにまとめて、1200万画素として使うことを前提にした設計となっている(複数の画素を1つまとめることを「(ピクセル)ビニング」という)。

ビニングによって、1200万画素撮影をすると感度を上げてもノイズが少なくきれいな画を出せるのである。だからこそ、1200万画素を基準としてもよいのだ。しかも、画素ごとに感度を変えることで「リアルタイムHDR撮影」も可能になる(詳細はこちら)。

必要な時は「4800万画素モード」で読み出すことで、高画素画像も得られる。この場合、「色情報が足りなくね?」となるけど、そこは「リモザイク処理」をかけることで、うまいことフルカラー画像を作っているのである。ビニング処理ができない分、「高感度に弱い(≒ノイズが増える)」「ダイナミックレンジが狭い」「ディテールがちょっとアレ」だとか、デメリットもあるけれども、それはそれ、だ。

スマホのようにややこしいデジタル処理をかける前提であれば、クアッドベイヤー配列は有利なのだ。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

スマホカメラが進化した裏側で起きていること ソニーのイメージセンサー開発部隊に聞く

スマホカメラが進化した裏側で起きていること ソニーのイメージセンサー開発部隊に聞く

すごく暗い場所でもAFが効くようになったり、気がついたらダイナミックレンジが広くなったりと、ここ数年のスマホカメラはスペックで語られない基本性能が上がっている。そこでセンサーメーカーであるソニーセミコンダクタソリューションズに話を聞きにいった。 「iPhone 17 Pro/Pro Max」、カメラ「光学8倍」は誤解に SNSで指摘が相次ぐ 正しく伝えた競合メーカーは?

「iPhone 17 Pro/Pro Max」、カメラ「光学8倍」は誤解に SNSで指摘が相次ぐ 正しく伝えた競合メーカーは?

Appleが9月10日(日本時間)に発表した「iPhone 17 Pro」「iPhone 17 Pro Max」。このアウトカメラについて、日本語の表現が誤解を招きかねないのではないか? との指摘がX(旧Twitter)上で相次いでいる。真実は一体……? Apple、iPhone 17 Proのカメラ「8倍光学ズーム」表記を「光学品質ズーム」に修正

Apple、iPhone 17 Proのカメラ「8倍光学ズーム」表記を「光学品質ズーム」に修正

公式サイト上の表記が「最大8倍の光学ズーム」から「最大8倍の光学品質ズーム」に修正されている。 「iPhone 17 Pro」「iPhone Air」のインカメラは縦横自在! 自撮り派にうれしい作りに

「iPhone 17 Pro」「iPhone Air」のインカメラは縦横自在! 自撮り派にうれしい作りに

iPhone 17 ProとiPhone Airのカメラを撮り比べるレビューの後編は、普段だとあまり扱わないインカメラ。インカメラはあまり変わり映えしないことが多かったのだけど、今回は違う。センサーが正方形になったのだ。 「iPhone 17 Pro」と「iPhone Air」のアウトカメラを撮り比べ 話題の「光学品質8倍ズーム」もチェック

「iPhone 17 Pro」と「iPhone Air」のアウトカメラを撮り比べ 話題の「光学品質8倍ズーム」もチェック

iPhone 17 ProとiPhone Airのアウトカメラって、何が違うんでしょうか――撮り比べてみましたよ! 「iPhone 17 Pro」「iPhone Air」のインカメラは縦横自在! 自撮り派にうれしい作りに

「iPhone 17 Pro」「iPhone Air」のインカメラは縦横自在! 自撮り派にうれしい作りに

iPhone 17 ProとiPhone Airのカメラを撮り比べるレビューの後編は、普段だとあまり扱わないインカメラ。インカメラはあまり変わり映えしないことが多かったのだけど、今回は違う。センサーが正方形になったのだ。