手作業で膨大なデータを分析→クラウド基盤を整備 データ活用で営業活動の精度が誤差0.015%に

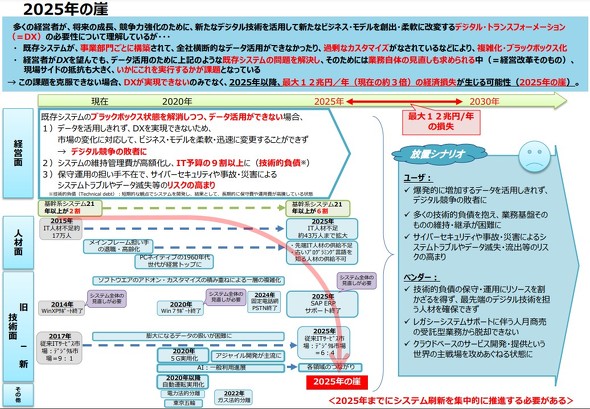

経済産業省は2018年に「2025年の崖」という問題を指摘した。これは企業においてDX(デジタルトランスフォーメーション)が進まず、課題を克服できないでいると、25年から30年に掛けて最大で年間12兆円の経済損失が出るというものだ。

同省はDXを阻む課題として既存システムの複雑化、ブラックボックス化を挙げている。レガシーシステムが改修も難しいほど複雑になってしまえば、システムを刷新してDXを実現することもできない。身動きがとれないままでは市場の変化に対応できずに競争に負けてしまう。

裏を返せば、企業が市場の変化に対応するには、レガシーシステムを刷新してDXを実現することが重要だ。より付加価値の高いビジネスを実現するには、業務を行う上で日々生まれる営業データや顧客情報などを分析し、活用する力も求められる。

このDXとデータ活用を推進するため、今まさに奔走している企業がNTTデータ先端技術だ。NTTデータ傘下のシステムインテグレーターでありながらも、つい最近までレガシーシステムの存在がデータ活用を拒む大きな要因の一つになっていた。

必要なデータを探し回り手作業で分析

1999年設立のNTTデータ先端技術では、営業データや顧客情報などを日々の営業活動や経営判断のために活用している。データ分析を担当するプラットフォーム事業部では経営陣などからの要望を受けて過去のデータを検索・整理し、結果を導きだす。

問題はデータの管理体制だ。分析担当者はこのような作業を自分の手でやらなければならない状態になっていた。

「オンプレミスサーバで運用する複数のレガシーシステムにデータが散在しており、システム同士の連携も取れていないため、分析業務に時間と人的リソースを著しく消費し、他の業務にも影響が及んでいました」

そう言って顔を曇らせるのはプラットフォーム事業部の加藤迪子氏だ。依頼を受けてデータを分析する際は、まず複数のシステム内を探索して必要なデータをダウンロード。Excelでデータを加工、集計するが、これら全てを手作業でしなければならなかった。この様子を聞いただけでも、非効率で生産性に課題があることが想像できる。

おまけに扱うデータは3万件以上。1件につき400もの項目がある上、データの重複やミスも含まれる場合がある。情報システム部門に収集や分析を依頼しても回答に時間を要することもある。

データ分析のニーズは確かにある一方で、業務負荷が非常に大きいため、プラットフォーム事業部は以前から社内で「専用のデータ分析基板が欲しい」と打診していた。それもやはり時間を要するため、プラットフォーム事業部長の高岡将氏は「ずっと手作業で頑張っていた」と苦笑する。

NTTデータ先端技術は、近年、売上や従業員規模が急成長しているさなかであり、それに合わせた組織改編が相次いでいるという。情報システム部門は、全社的な案件の対応に追われ、一事業部からの要望はどうしても優先度が下がるというのが実情だ。

急成長過程の企業にありがちなぜいたくな悩みとも取れるが、プラットフォーム事業部からすれば切実な問題だ。「当社では期初の売上目標から大きな乖離(かいり)のない範囲で目標金額を達成することが求められています。期末に近づくにつれて目標値と決算の数値が合致していることを確認するのですが、手作業による分析だと時間や精度面で課題があり、効果的な営業戦略を立てるのが難しい状態でした」(高岡氏)とこぼす。

結局、データ分析基盤はプラットフォーム事業部が自前で構築することになった。目標は、社内のデータを1カ所にまとめ、効率的に分析結果を得られるようにすることだ。

最終目標は、ユーザー自身の手で分析と可視化を実施すること

プラットフォーム事業部がシステム導入の検討を始めたのは21年1月。以前から交流があった日本マイクロソフトに相談を持ちかけた。3月末までに要件定義やシステムの構築を行い、4月から本番運用を視野に入れた検証に入った。

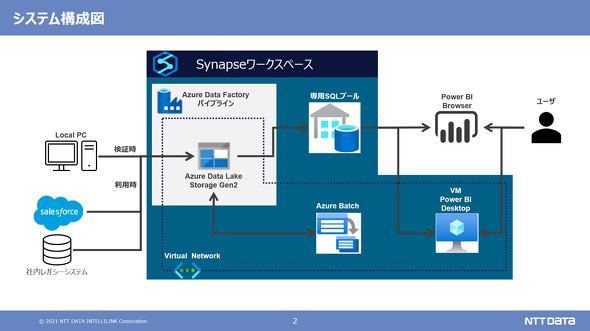

選んだのはMicrosoftのクラウド型データ分析プラットフォーム「Azure Synapse Analytics」と「Power BI」だ。

構築したシステムの仕組みはこうだ。まず、Azure Synapse Analytics内の「Azure Data Factory」機能でレガシーシステムなどから出るデータを抽出し1カ所に集める。分析に適した形になるようデータを加工。Azure Synapse Analyticsはさまざまなデータ可視化ツールと接続できるが、プラットフォーム事業部はPower BIを使ってデータ分析を行うことにした。

このシステムは、社内に散在している各種データをAzure Synapse Analyticsに集約し、営業職のユーザー自身で分析と可視化をできるようにするのが最終目標だ。

データ分析プラットフォームの中でもAzureを選んだのは、機能や性能、価格はもちろん、既存システムとの接続性がいい点や、すでにMicrosoftのアカウントを従業員が持っていたためだという。「Azureに落ち着いたのは、ある意味、必然だった」(高岡氏)

目標額に誤差0.015%の精度で迫る正確な営業活動が可能に

これまでデータ活用に苦戦していたプラットフォーム事業部だが、データ分析基盤の構築で分析精度が一気に向上。それまで丸1日かかっていた分析作業を瞬時に処理できるようになり、タイムリーな営業施策を打ち出せるようになった。

プラットフォーム事業部では社内向けのデータ分析の他にも、ハードウェアの物販、システムインテグレーション、教育、人材派遣などさまざまなサービスを提供している。誤差20%の範囲内で売上目標を達成するには、過去の実績を分析しながら、どのタイミングでどのサービスを強化するべきかという緻密な検討が重要になる。

「会社が許容する誤差はプラスマイナス20%でしたが、データ分析基盤を活用したところ、誤差0.015の精度で目標額に着地できました」

高岡氏はそう言って頬を緩める。効果的な営業戦略というのは次のような事例をいう。例えば、期末に向けて、目標に到達しない可能性がある場合、ハードウェア販売に力を入れ受注に至ったとしても、製品納期が間に合わなければ売り上げとして計上できない。しかし、教育や人材派遣サービスなどの販売に注力して受注すれば、短いリードタイムで売り上げを計上できる。Synapse AnalyticsとPower BIで構成された分析基盤のおかげで、好機を逃さない施策を実現することができるようになったというわけだ。

現状は検証運用ということもあり、一週間に一回の頻度で社内の各種システムからデータを読み込んでいる。今後は徐々にリアルタイムへ段階的に移行する予定だ。データの読み込み頻度を上げることで、各営業担当者の受注活動の確度を見極められることが期待されている。

前述のように、経営側から厳しい売り上げ目標が定められているなかで、各担当者が手掛けている案件の受注確度を逐次、全社に向けて報告しなければならない。ただ、現状では受注確度を正確に測れないものもある。最新のデータをリアルタイムに分析できれば、予想精度を向上させられる。

このようなビジネス上の効果は、データ分析基盤を整備する以前のシステムでは実現が難しかった。現場で行われたのは、データを1カ所にまとめて分析できるようにするというシンプルな取り組みながら、効果的な営業方針の策定が難しい状態から誤差0.015%の精度で目標に合わせるという実際の効果をたたき出したのは大きな価値だ。

重視すべきは、この取り組みを行う中でデータが増えたわけではない点だ。新たな営業支援ツールを導入してデータ量を積み上げることはなく、もともとあったデータを活用できるようにしたにすぎない。逆に、これまではそういったデータを死蔵させていたともいえる。NTTデータ先端技術の例を見れば、データを眠らせたまま2025年の崖に巻き込まれるか、活用して効果的な経営に役立てるかの違いの大きさに気付くだろう。

(後編)データはあるのに分散していて活用できない! “宝の持ち腐れ”解消に向け現場の技術者がとった手段

NTTデータ先端技術は営業活動や経営判断のためにデータ活用を行ってきたが、レガシーシステムにデータが分散してしまいせっかくの情報資源を活用しにくい状態にあった。

そこで同社はMicrosoftのデータ分析プラットフォーム「Azure Synapse Analytics」を導入。丸1日掛けていたデータ分析を数十分ほどできるようになるなど、大幅な業務効率改善を実現した。

Copyright © ITmedia, Inc. All Rights Reserved.

提供:日本マイクロソフト株式会社

アイティメディア営業企画/制作:ITmedia NEWS編集部/掲載内容有効期限:2021年8月25日

NTTデータ先端技術の加藤迪子氏(プラットフォーム事業部)

NTTデータ先端技術の加藤迪子氏(プラットフォーム事業部) NTTデータ先端技術の高岡将氏(プラットフォーム事業部長)

NTTデータ先端技術の高岡将氏(プラットフォーム事業部長)

左から、NTTデータ先端技術の煤田弘法氏(プラットフォーム事業部)、加藤氏、高岡氏

左から、NTTデータ先端技術の煤田弘法氏(プラットフォーム事業部)、加藤氏、高岡氏