いまあるハードウェアで、ちょっと先の未来へ:Research@Intel 2012(2/3 ページ)

Intelが米国で開催した「Research@Intel 2012」では、「暮らしに根ざしたソリューション」をテーマに、ITで生活をよくしていく具体的な提案を紹介した。

表情を伝えることで、気持ちのすれ違いもなくなる……はず

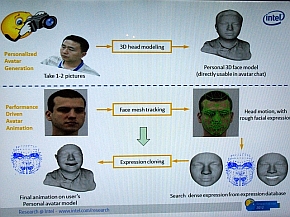

スマートフォンを使ったもう1つのデモとしては、「Avatar Video Chat」も面白い。この技術では、カメラで人物の表情を取得してデータ化した上で特徴を把握し、これをリアルタイムで画面に反映させてチャットを行う。直接人物の映像でビデオチャットを行わない理由の1つは、Xbox Liveなどで普及しているアバター同士のコミュニティで“違和感のない”コミュニケーションを実現するためだ。

加えて、2つめの理由がデータ容量の節約にある。Avatar Video Chatでは、ユーザーの顔にある表情の特徴だけを取得するため、送信データも軽くて済む。そのおかげで、通信条件の悪い3G回線でも問題なくビデオチャットができることになる(数十Kbps程度の通信速度でいいという)。なお、内蔵カメラを使った表情データの取得と処理は、スマートフォンでも十分可能だとIntelは説明している。デモでは、Lenovoの“Medfield”世代のAtomを内蔵したスマートフォン「K800」を用いていた。

Avatar Chatと呼ばれるシステムでは、内蔵カメラで取得した映像から、表情の動きの特徴を把握し、これをビデオチャットに応用する(写真=左)。表情の特徴に注目することで、低速のネットワーク環境しか使えない状況でも、少ないデータの送受信で相手の表情が分かり、ビデオチャットなどで意思疎通をスムーズに行えるなどのメリットが期待できる(写真=右)

Avatar Chatと呼ばれるシステムでは、内蔵カメラで取得した映像から、表情の動きの特徴を把握し、これをビデオチャットに応用する(写真=左)。表情の特徴に注目することで、低速のネットワーク環境しか使えない状況でも、少ないデータの送受信で相手の表情が分かり、ビデオチャットなどで意思疎通をスムーズに行えるなどのメリットが期待できる(写真=右)技術イベントで、こんなにKinectを見たのは初めてです

身近な生活をテーマにした展示では、自宅や外出先、特にショッピングなどで活用できそうなデモを行っていた。その中には、Intelの開発者カンファレンスである「Intel Developer Forum」(IDF)でも何度か登場している、大画面スクリーンの前に立つと人物のモーションを認識し、画面にある服をユーザーのジェスチャーで選択すると、実際に動きながら試着を楽しめるというデモもあった。この仕掛け自体は目新しいものではないが、服のオブジェクトに対して物理演算によるモーション処理を施していること、そして、ユーザーが行うジェスチャーの取得に「Kinect」を利用しているのが、これまでのデモから進化した部分といえる。

Kinectは、未来型リテールストアのデモでも使っていた。デジタルサイネージを兼ねた大型スクリーンに表示した各種メニューを、ジェスチャーを使って操作する。このシステムで最大のポイントは、「Andy」と呼ぶ自律タイプの小型ロボットだ。店内を移動してその状況をカメラを通して遠隔地の人間がリアルタイムで把握できる。ディスプレイの内容など、客が実際のリテール店舗をディスプレイで体験することが可能なだけでなく、店側にとっても、在庫状況の把握やディスプレイや陳列が適切に行われているかをテストするために利用できるという。

前に立つ人物のモーションを取得して、画面内のアバターを着替えさせてリアルタイムで動かす試着システム。モーション取得に利用しているのはKinectだ(写真=左)。未来型ショッピングのシステム。店内では情報KIOSKを兼ねたデジタルサイネージに対し、Kinectを使ったジェスチャーによる操作でウィンドウショッピングを楽しめる(写真=中央)。「Andy」と呼ばれる自律式小型ロボットが店内を徘徊し、店内や在庫の状況、配置が最適化されているかなどの情報を取得できる(写真=右)

前に立つ人物のモーションを取得して、画面内のアバターを着替えさせてリアルタイムで動かす試着システム。モーション取得に利用しているのはKinectだ(写真=左)。未来型ショッピングのシステム。店内では情報KIOSKを兼ねたデジタルサイネージに対し、Kinectを使ったジェスチャーによる操作でウィンドウショッピングを楽しめる(写真=中央)。「Andy」と呼ばれる自律式小型ロボットが店内を徘徊し、店内や在庫の状況、配置が最適化されているかなどの情報を取得できる(写真=右)関連キーワード

Intel | プロジェクター | Kinect for Xbox 360 | モーションセンサー | Intel Developer Forum | ビデオチャット | デジタルサイネージ | 議事録 | 開発者 | 展示会 | 研究機関 | 研究開発 | ユーザーインタフェース

Copyright © ITmedia, Inc. All Rights Reserved.