ニュース

NVIDIAがWindowsのAI推論をより簡単かつ高速化できる「TensorRT for RTX」を開発 Windows 11でプレビュー:COMPUTEX TAIPEI 2025

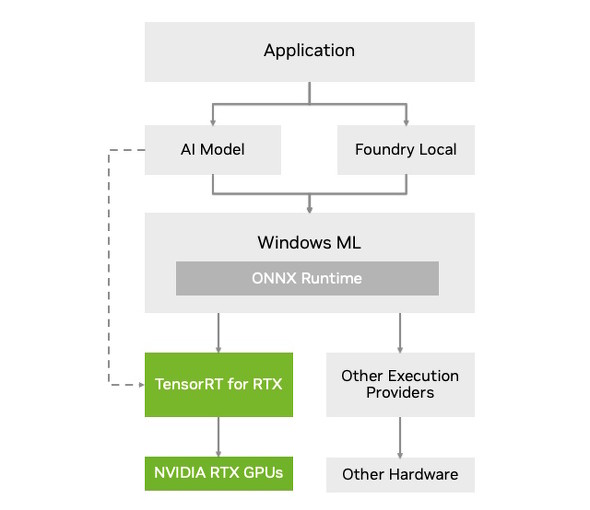

Microsoftが、Windows 11向けの「Windows ML」でハードウェアアーキテクチャに応じて推論ライブラリを入れ替える仕組みを導入した。これに合わせて、NVIDIAもTensorプロセッサを搭載するGPU向けのライブラリ「TensorRT for RTX」を開発した。

NVIDIAは5月20日(米国太平洋夏時間)、Windowsに特化したAI推論ライブラリ「NVIDIA TensorRT for RTX」を開発したと発表した。Microsoftが提供するWindows 11向け「Windows ML」の一部としてプレビュー提供が始まっており、6月中にはNVIDIAからもSDK(開発者キット)が提供される予定だ。

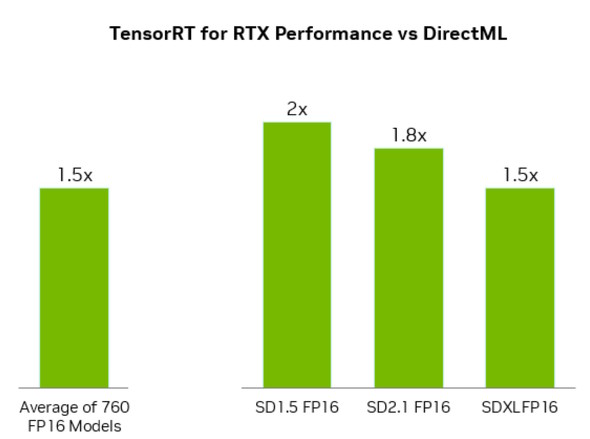

TensorRT for RTXはWindows MLに組み込めることが特徴で、Windows MLの標準API(ライブラリ)である「DirectML」と比べると最大2倍のパフォーマンスを発揮できるという。Tensorコアを統合した全てのNVIDIA製GPU(「RTX」という名称が含まれているもの)に対応していることも特徴だ。

Windows MLの一部として提供されるため、推論エンジンを事前にコンパイルする必要がないことや、ライブラリを事前にダウンロードしておく必要がないことがメリットだ。

NVIDIAによるとTensorRT for RTXは一部の開発者に先行提供されており、フィードバックの結果も良好だという。開発者がより気軽にTensorRTを活用でき、一般ユーザーが気軽に生成AIのメリットを得られる手段として普及が進む可能性がある。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

まるで“ファンミーティング”な熱気 NVIDIA基調講演でフアンCEOは何を語ったのか?

まるで“ファンミーティング”な熱気 NVIDIA基調講演でフアンCEOは何を語ったのか?

COMPUTEX TAIPEI 2025開幕の前日、NVIDIAのジェンスン・フアンCEOが基調講演を開催した。会場周辺は熱気に包まれ、さながら「ファンミーティング」のような様相だった講演の模様をお伝えする。 NVIDIAのAI特化型ミニPC「DGX Spark」、台湾の主要PCメーカーからも7月に発売

NVIDIAのAI特化型ミニPC「DGX Spark」、台湾の主要PCメーカーからも7月に発売

- 文部科学省が小中高向けの生成AIガイドラインを暫定公開/「TweetDeck」の新バージョンで事実上の有償化

NVIDIAのAIチャットbot「ChatRTX」に複数の脆弱性/ARM版に最適化されたGoogle Chromeが登場

NVIDIAのAIチャットbot「ChatRTX」に複数の脆弱性/ARM版に最適化されたGoogle Chromeが登場

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、3月24日週を中心に公開された主なニュースを一気にチェックしましょう! NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、2月11日週を中心に公開された主なニュースを一気にチェックしましょう!