新世代のLLM「Mercury Coder」 画像生成AIでおなじみ、拡散モデル採用 コード生成は最大10倍速く

AI開発企業の米inceptionは、新型の大規模言語モデル(LLM)「Mercury Coder」を発表した。

AI開発企業の米inceptionは2月28日(現地時間)、新型の大規模言語モデル(LLM)「Mercury Coder」を発表した。画像生成AIでよく使われている学習モデル「拡散モデル」を取り入れたLLMで、従来のLLMよりも最大10倍高速で動作するという。同社はこれを「diffusion large language models」(dLLM)と称し「新世代のLLM」と説明している。

Mercury Coderは、コード生成に特化したdLLM。従来型のLLMのように1トークンずつ生成する仕組みではなく、拡散モデルの“ノイズ除去を繰り返して鮮明化を図る”方法を採用している。これにより現行のLLMよりも5〜10倍高速で、低コストで高品質な出力結果を実現するという。

現在のLLMの多くは、順番に1つのトークンずつ文章を生成する「自己回帰モデル」を採用している。この場合、全てのトークンを一斉に生成することはできず、各トークンを生成するには数十億パラメータに及ぶニューラルネットワークを求められる。このため、膨大な推論タスクを実行する際などは、多大な計算コストと処理時間を必要とする。

同社はこの課題を解決するため拡散モデルに注目。拡散モデルは、ノイズ除去を繰り返すことで出力結果を鮮明化していく仕組みで、同社は「直前の出力のみを考慮するわけではないため、推論や応答の構造化に優れている」「出力を継続的に改善できるため、ミスやうそを修正できる」などと評価している。拡散モデルはこれまで画像や動画生成AIなどに活用されていたが、文章生成などへ適用できた成功例はなかったという。

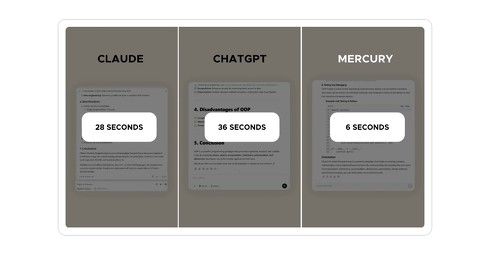

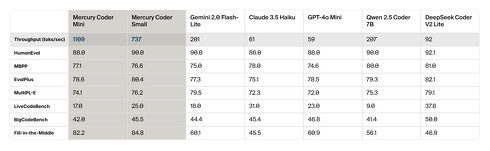

同社のWebサイトでは、GPT-4o MiniやClaude 3.5 Haikuなどとの性能比較結果を公開。他LLMと同等以上の性能を記録しており、特にスピード面では圧倒的な差を見せた。

「dLLMの優れた点は、そのスピードだ。スピードを最適化した自己回帰モデルでも、1秒間に最大200トークンしか生成できない。しかし、市販のNVIDIA H100上でMercury Coderを実行すると、1秒間に1000トークン以上のスピードで処理でき、5倍のスピードアップを実現可能としている」(同社)

Mercury Coder同社のWebサイトにて一般公開中。利用には氏名やメールアドレスを登録する必要がある。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

【詳報】GPT-4.5の特徴は? 教師なし学習で性能向上、OpenAI史上最大サイズ、API利用は超高価

【詳報】GPT-4.5の特徴は? 教師なし学習で性能向上、OpenAI史上最大サイズ、API利用は超高価

米OpenAIは2月28日(日本時間)、同社の大規模言語モデル「GPT-4.5」の研究プレビューを公開した。このモデルはGPT-4oをベースに構築されており、学習方法などを工夫することで“長考”をしなくても性能が向上したほか、会話の自然さも改善された。本記事ではOpenAIが公開したシステムカードのやブログ、APIなどの情報を基に、GPT-4.5の性能やモデルサイズ、安全性、利用価格などについて解説していく。 Google、科学者の研究を助けるマルチエージェントAI「AI co-scientist」提供開始

Google、科学者の研究を助けるマルチエージェントAI「AI co-scientist」提供開始

Googleは、科学研究を加速させるための新AIシステム「AI co-scientist」を発表した。「Gemini 2.0」ベースで、複数の専門エージェントを使って仮説を生成、評価、洗練する。 コロプラ、画像生成AI「Stable Diffusion」開発元と提携 「生産性の向上を加速」

コロプラ、画像生成AI「Stable Diffusion」開発元と提携 「生産性の向上を加速」

コロプラが画像生成AI「Stable Diffusion」開発元である米Stability AIとのパートナーシップを発表した。利用ガイドラインを設けた上でStability AIの画像生成AI技術を活用。生産性の向上や新しいゲーム体験の創出を強化するという。 君には見えるか? “錯視画像”を作り出す生成AI 「遠近で変わる絵」「白黒と色付きで変わる絵」など

君には見えるか? “錯視画像”を作り出す生成AI 「遠近で変わる絵」「白黒と色付きで変わる絵」など

米ミシガン大学に所属する研究者らは、人間の知覚に錯覚を引き起こすような画像を生成する手法を提案した研究報告を発表した。 話題のAIベンチャー「Sakana AI」が画像生成AIを公開 “自律進化”技術で、推論速度が約10倍高速に

話題のAIベンチャー「Sakana AI」が画像生成AIを公開 “自律進化”技術で、推論速度が約10倍高速に

AIベンチャーのSakana AIは、画像生成AI「EvoSDXL-JP」を公開した。同社が提案する生成AIの開発手法「進化的モデルマージ」によって構築したAIモデルで、従来の日本語AIモデルと比べて10倍速く画像を生成できるという。