ハルシネーションはなぜ起きるのか OpenAIの研究が示す「正答率信仰の罠」:AIニュースピックアップ

OpenAIは大規模言語モデルにおける「幻覚」(ハルシネーション)問題について、学習構造と評価方法に起因することを明らかにした。推測を優先する評価体系が誤答を助長し、正答率のみを重視する現行のベンチマークでは信頼性が損なわれると指摘している。

この記事は会員限定です。会員登録すると全てご覧いただけます。

OpenAIは2025年9月5日(現地時間)、大規模言語モデルにおける「幻覚」(ハルシネーション)の発生要因と評価方法の課題について研究成果を発表した。ハルシネーションとは、モデルが確信を持って出力した内容が実際には事実と異なる現象を指す。今回の研究論文によれば、従来の学習手法や評価基準が「分からない」と答えるよりも推測を優先させる構造になっており、それが幻覚を助長する仕組みになっていると分析している。

OpenAIが警鐘 正答率信仰の罠

OpenAIは「GPT-5」を含む最新モデルにおいてハルシネーションの発生率を低減させたとしつつも、根本的な課題は依然として残っていると述べている。言語モデルが単純な質問に対し誤った答えを複数提示する例や、著者の博士論文のタイトルや誕生日を誤答する事例を示し、信頼性向上には不確実性を明示的に扱うことが不可欠と強調している。研究チームはLLMの評価方法がハルシネーションの一因になっている点を指摘する。

現在広く使われているベンチマークでは「正解率」が重視される。これは、選択式試験で空欄にするよりも当てずっぽうで解答する方が点数につながる状況に近いという。誕生日を問われて「9月10日」と答えれば365分の1の確率で正解となるが、「分からない」と答えれば0点となる。この構造がモデルに推測を促し、誤答を生みやすくしている。

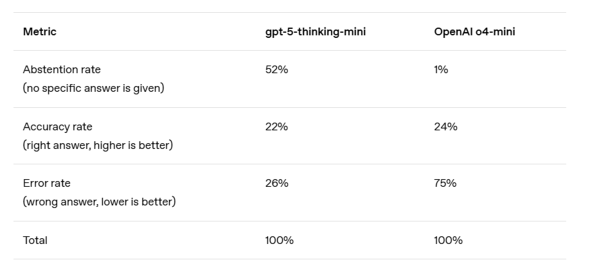

OpenAIは「正答」「誤答」「保留」の3分類を提示し、誤答は保留よりも深刻と論じている。実際の評価例として、GPT-5の小型モデル「gpt-5-thinking-mini」のシステムカードに掲載されている「SimpleQA」の結果を示している。従来の「o4-mini」モデルは正答率でGPT-5系列を上回るが、誤答率は高い。推測によって見かけの正答率を引き上げても、誤答の多発という代償を伴うことが示されている。

評価指標の改善案としては、誤答に対してより強いペナルティーを課し、不確実性を示した場合には部分点を設ける方式が提案されている。これは教育試験で導入されてきた負の得点法や空欄への部分点付与に類似する。既に一部の研究者はこうした手法を試みているが、広く使われる正答率中心の評価体系が変わらない限り、推測優先の傾向は残ると述べられている。

ハルシネーションが発生する仕組み自体についても解説されている。言語モデルは大量のテキストを対象に「次の単語」を予測するよう学習するが、その過程には「誤り」とラベル付けされている例が存在しない。文法や綴りのように規則性の高いパターンは改善されやすいが、希少で一貫性の乏しい事実情報(誕生日のようなデータなど)は誤りを生みやすいとされる。これは画像認識において「犬か猫か」という分類は容易でも、「ペットの誕生日を当てる」といった不規則な課題では誤答が避けられない構造と同様だと説明されている。

今回の研究は、ハルシネーションを巡る幾つかの通念に対し整理を試みている。正答率が100%になればハルシネーションは消えるという見方には「現実世界には答えが定まらない問いが存在するため完全な精度は達成できない」と結論づけている。ハルシネーションは不可避との見解には、不確実な場合に「分からない」と答えることで回避できる可能性を示した。大規模モデルでなければハルシネーション防止はできないという認識についても、小規模モデルの方が自身の限界を認識しやすい場合があると指摘している。

OpenAIは今回の研究を通じて、ハルシネーションが単なる不具合ではなく、評価方法や学習プロセスの特性から統計的に説明できる現象になっていることを明確にした。今後は評価基準を改訂し、不確実性を適切に扱うことでハルシネーションの発生を抑える取り組みを推進する方針を示している。

関連記事

「オンプレミス版Gemini」提供開始 KDDIが初期導入に参加

「オンプレミス版Gemini」提供開始 KDDIが初期導入に参加

Googleが生成AI「Gemini」を、Google Cloudのオンプレミス延伸環境であるGDCでも提供する。GovTech Singaporeなどの他、日本からはKDDIが初期導入に参加する。 VMware Cloud FoundationにNVIDIAのAI技術が統合 プライベートクラウドで高度なAIワークロードを実行

VMware Cloud FoundationにNVIDIAのAI技術が統合 プライベートクラウドで高度なAIワークロードを実行

Broadcomは「VMware Cloud Foundation」にNVIDIAのAI技術を統合すると発表した。「Blackwell GPU」や高速ネットワーク対応により、生成AIなど多様なAIワークロードを既存環境で効率的に展開できる基盤を整備する。 国内AIエージェント基盤市場が8倍に急拡大 2029年度に市場規模135億円予想

国内AIエージェント基盤市場が8倍に急拡大 2029年度に市場規模135億円予想

ITRは、AIエージェント基盤市場が2024年度に前年度比8倍の1億6000万円に成長し、2029年度には135億円に達すると予測している。生成AIの進展により、業務自動化手段としての注目が高まり、クラウド、SaaSベンダーの参入も増えている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 知らない番号でも一瞬で正体判明? 警察庁推奨アプリの実力を検証

- 生成AIで消えるのは仕事、それとも新人枠? 800職種のデータから分かったこと

- Windows RDSにゼロデイ脆弱性 悪用コードが22万ドルで闇市場に流通

- もはやAIは内部脅威? 企業の73%が「最大リスク」と回答

- 政府職員向けAI基盤「源内」、18万人対象の実証開始 選定された国産LLMは?

- 「ExcelのためのChatGPT」ついに登場 GPT-5.4で実用レベルに?

- その事例、本当に出して大丈夫? “対策を見せたい欲”が招く逆効果

- ZIPファイルの“ちょっとした細工”で検知停止 EDRも見逃す可能性

- 本職プログラマーから見た素人のバイブコーディングのリアル AIビジネス活用の現在地

- M365版「Cowork」登場 Anthropicとの連携が生んだ「新しい仕事の進め方」