「GeForce RTX 5080」への乗り換えはアリ? 「GeForce RTX 3080 Ti」搭載PCで試した結果(3/4 ページ)

まもなく「GeForce RTX 5080」が登場する。このGPUは「グラフィックスカードの置き換え」目線で考えた場合にどうなのか、「Intel NUC 13 Extreme Kit」のCore i9-13900Kモデルに実装して検証した。

動画のエンコードはどう?

別記事で解説したが、GeForce RTX 50シリーズは新世代の動画エンコーダー(第9世代)/デコーダー(第6世代)を搭載している。

今回比較している3つのGPUのエンコーダー/デコーダーの搭載状況は以下の通りだ。

- GeForce RTX 3080 Ti:エンコーダー1基(第7世代)/デコーダー1基(第5世代)

- GeForce RTX 4080:エンコーダー2基(第8世代)/デコーダー1基(第5世代)

- GeForce RTX 5080:エンコーダー2基(第9世代)/デコーダー2基(第6世代)

3080 Tiと比べると、5080はエンコーダーもデコーダーも2倍となっている。4080と比べた場合でも、デコーダーが1基増えているため、マルチストリーム再生時のパフォーマンスが改善しているものと思われる。

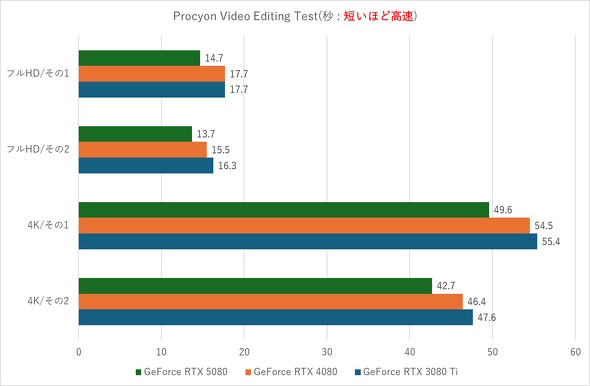

今回は時間の都合で、ULの総合ベンチマークテストアプリ「Procyon」に内包されたテスト「Video Editing Benchmark」を実施した。このテストは、「Adobe Premiere Pro」を使ってフルHD(H.264コーデック)と4K(H.265コーデック)の動画を2種類ずつ書き出す際のパフォーマンスを点数化する。負荷の大きい2つ目のテストは、エフェクト処理でGPUによるアクセラレーションを有効にできる。

総合スコアではなく、あえて書き出しに掛かった時間をチェックしてみると、以下の通りとなる。

- GeForce RTX 5080

- フルHD/その1:14.7秒

- フルHD/その2(GPUアクセラレーション):13.7秒

- 4K/その1:49.6秒

- 4K/その2(GPUアクセラレーション):42.7秒

- GeForce RTX 4080

- フルHD/その1:17.7秒

- フルHD/その2(GPUアクセラレーション):15.7秒

- 4K/その1:54.5秒

- 4K/その2(GPUアクセラレーション):47.6秒

- GeForce RTX 3080 Ti

- フルHD/その1:17.7秒

- フルHD/その2(GPUアクセラレーション):16.3秒

- 4K/その1:55.4秒

- 4K/その2(GPUアクセラレーション):47.6秒

順当に「5080>4080>3080 Ti」という結果となった。2つ目のテストは、GPUアクセラレーションをオフ(=CPU処理)にすると時間がめっぽう掛かり、ハイエンドCPU/GPUを搭載するPCであっても、全テスト終了までに1時間近く要することもある。エフェクトを多用する場合は、エンコーダー/デコーダーを含めたGPUの全体性能も重要となる。

5080は、グラフィックスメモリがGDDR7規格であり、PCとの接続にPCI Express 5.0バスを利用する。メモリやバスの高速化が積み重なった結果、従来モデルよりも高速な動画書き出しを実現できている。

動画の書き出しは、長尺になるほどわずかの差が大きな差となる。一層の時短を狙うなら、5080の導入は効果が高そうだ。

物体検知/生成AIのパフォーマンスは?

最近、NPUを搭載する「AI PC」が評判だが、AI(人工知能)の演算処理にGPUを用いるアプリ(プログラム)も多い。そこで動画の書き出しテストでも登場したULのProcyonを使って、GPU演算を利用するAIのパフォーマンステストを実施してみた。

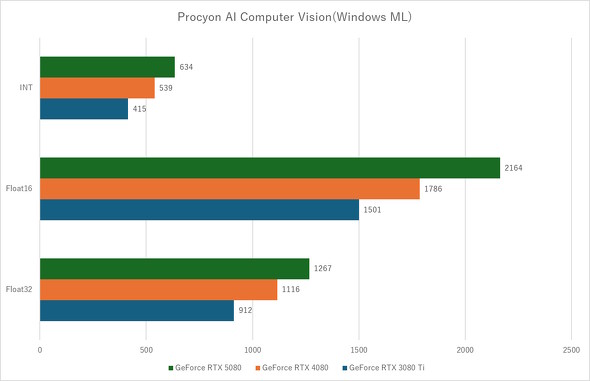

AI Computer Vision Benchmark

「AI Computer Vision Benchmark」は、機械学習データを使って物体を検知する「コンピュータビジョン」の処理パフォーマンスを確認するテストだ。複数のAPI(命令セット)で同種のテストを実行可能で、命令セットによってはCPU/NPU/GPUのパフォーマンス差もチェックできる。

NVIDIA製GPUを搭載しているWindows PCの場合、本来はGPU演算のAPIとして「Windows ML(Direct ML)」か「NVIDIA TensorRT」を選択できる。しかし、現在のAI Computer Vision BechmarkはGeForce RTX 50シリーズにおけるTensorRT APIに対応していない(対応に向けた修正を準備している)。そこで今回は、Windows ML APIを使った場合の演算パフォーマンスを比較する。総合スコアは以下の通りだ。

- GeForce RTX 5080

- INT(整数演算):634ポイント

- Float16(半精度浮動小数点数演算):2164ポイント

- Float32(単精度浮動小数点数演算):1267ポイント

- GeForce RTX 4080

- INT(整数演算):539ポイント

- Float16(半精度浮動小数点数演算):1786ポイント

- Float32(単精度浮動小数点数演算):1116ポイント

- GeForce RTX 3080 Ti

- INT(整数演算):415ポイント

- Float16(半精度浮動小数点数演算):1501ポイント

- Float32(単精度浮動小数点数演算):912ポイント

やはり順当な「5080>4080>3080 Ti」という結果だった。Windows MLという汎用(はんよう)APIを使うことによるオーバーヘッドはさておいて、5080は4080比で1.14〜1.21倍、3080 Ti比で1.39〜1.53倍のパフォーマンスとなっている。機械学習ベースのAIを使う場合は、やはり「なるべく新しいGPU(グラフィックスカード)」がよさそうである。

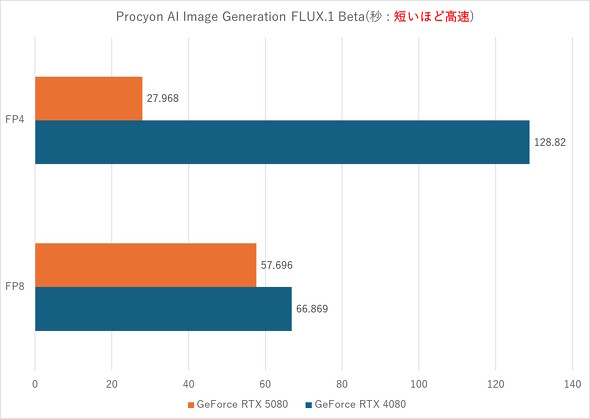

AI Image Generation Benchmark(FLUX.1 Beta)

ProcyonにはStable Diffusionベースの画像生成AIテスト「AI Image Generation Benchmark」もある。しかし、本テストも現時点ではTensorRT APIに対応していない。「ONNX」APIを使えばテスト可能なのだが、今回は時間の都合で見送った。

その代わり、ULとNVIDIAがβ提供しているFLUX.1ベースのAI Image Generation Benchmarkを実行してみた。このテストは、グラフィックスメモリの容量の都合から3080 Tiでの測定を行っていない。生成完了までの所要時間は以下の通りだ。

- GeForce RTX 5080

- FP4(4bit浮動小数点数演算):27.968秒

- FP8(8bit浮動小数点数演算):57.696秒

- GeForce RTX 4080

- FP4(4bit浮動小数点数演算):128.82秒

- FP8(8bit浮動小数点数演算):66.869秒

「5080>4080」なのはもちろんなのだが、FP4の演算で“大差”が付いている。これはGeForce RTX 50シリーズのTensorコアでFP4演算をネイティブサポートした成果である(GeForce RTX 40シリーズではFP8に変換してから演算するためオーバーヘッドが生じてしまう)。

生成AIにおいて、より高速な処理を行うには「精度をあえて低くする」ことが求められる場合がある。しかし、単に精度を低くしても演算器(ここではTensorコア)が低精度演算に対応していないと精度の変換にリソースを割かれてしまうという“本末転倒”な事態もあり得る。

その点、GeForce RTX 50シリーズでは低精度演算(FP4)をネイティブサポートしたのは、生成AI時代を踏まえた大きな変化といえる。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

NVIDIAが新型GPU「GeForce RTX 50シリーズ」を発表 新アーキテクチャ「Blackwell」でパフォーマンスを約2倍向上 モバイル向けも

NVIDIAが新型GPU「GeForce RTX 50シリーズ」を発表 新アーキテクチャ「Blackwell」でパフォーマンスを約2倍向上 モバイル向けも

NVIDIAが、ついにBlackwellアーキテクチャのコンシューマー向けGPUを発売する。今回はデスクトップ向けだけでなくモバイル(ノートPC)向け製品も一気に発表しており、GPUにおけるAI処理を一気に底上げする。 容積14Lで空冷だけどパワフル! Core i9-13900K搭載でコンパクトな「Intel NUC 13 Extreme Kit」を試す

容積14Lで空冷だけどパワフル! Core i9-13900K搭載でコンパクトな「Intel NUC 13 Extreme Kit」を試す

Intelが2022年12月末に発売した「Intel NUC 13 Extreme Kit」は、デスクトップ向け第13世代Coreプロセッサをあらかじめ組み込んだハイエンドベアボーンキットだ。ゲーミングあるいは動画編集の快適さを重視する人にとって、貴重なコンパクトボディーも魅力である。この記事では、Core i9-13900Kを搭載する最上位モデルの使い勝手をチェックする。 これから買うなら3090 Tiよりも「GeForce RTX 4080」 そのワケを探る

これから買うなら3090 Tiよりも「GeForce RTX 4080」 そのワケを探る

NVIDIAの新型GPU「GeForce RTX 4080」を搭載するグラフィックスカードの販売が11月16日に解禁される。最上位の「GeForce RTX 4090」や先代の最上位「GeForce RTX 3090 Ti」と比べてパフォーマンスはどうなのか、発売に先駆けてチェックしていこう。 今度のSUPERはどうだ? 17万円切りで4Kでも快適に使える「GeForce RTX 4080 SUPER」を試す

今度のSUPERはどうだ? 17万円切りで4Kでも快適に使える「GeForce RTX 4080 SUPER」を試す

NVIDIA製新型GPU「GeForce RTX 4080 SUPER」を搭載するグラフィックスカードの販売が解禁された。日本未発売の自社設計カードを使って、本GPUのパフォーマンスをチェックしていく。 3090 Tiより高速な「GeForce RTX 4070 Ti」突如登場 発売中止の「GeForce RTX 4080(12GB)」を“リネーム”

3090 Tiより高速な「GeForce RTX 4070 Ti」突如登場 発売中止の「GeForce RTX 4080(12GB)」を“リネーム”

NVIDIAが発売を中止した「GeForce RTX 4080(12GB)」が、「GeForce RTX 4070 Ti」として“復活”を果たすことになった。想定価格は発売中止前から100ドル値下げされているが、スペックはそのままとなっており、わずかだが手頃感が増している。