AIが求める大量の水と電力、どうまかなう? 環境と社会へ配慮したデータセンターの挑戦:AI×社会の交差点(2/3 ページ)

電力の消費拡大に対する取り組み

前述した米大手クラウドプロバイダーのような大規模なデータセンターを運営するクラウド企業では、脱炭素に関しても先進的に取り組んでおり、温暖化ガスを排出しない電力を確保しようとしている。

そのため、大手クラウドプロバイダー各社は、原子力発電所との契約や次世代の原子力発電である「小型モジュール炉(SMR)」への投資などを相次いで行っている。データセンターでは、24時間365日の安定稼働と、大規模な電力が求められることも原発が注目される要因の一つと考えられる。

一方で、原発だけで十分な電力量が確保できるかには疑問がある。電力市場などを専門とする米コンサルティング会社Grid Strategiesが出した試算結果によれば、生成AIなどの登場で電力需要は増大傾向で、米国のピーク時の電力需要が、2023年から2028年までの間に38ギガワット増加すると予測している。これはスリーマイル島原発1号機の約46基分に相当する。

2024年1月時点で米国で稼働している原発が93基であることを考えると、5年程度でその約半数の原発を新たに稼働させるのは高いハードルといえる。従って、新たな電力源の確保だけでは不十分と考えられるため、データセンター内の電力効率化の技術開発にも着目したい。

注目される技術の一つが、AIの処理に特化させて高効率化させたプロセッサである。米AIスタートアップEtchedはChatGPTなどで採用されるTransformerアーキテクチャに特化したASIC(Application Specific Integrated Circuit: 特定用途向け集積回路)であるSohuを発表した。

Sohuは、画像処理や音声処理、従来型のAI計算(リカレントニューラルネットワークなど)なども実行できないが、Transformerに特化させることでNVIDIA GPU「H100」よりも20倍以上高速で、消費電力も抑えられるとしている。

その他にも、Cerebras CS2、Groq LPU、Google TPU、AWS Trainium/Inferentiaなど、ASICアーキテクチャのAIチップが登場してきており、性能だけでなく消費電力の観点でも注目される技術である。

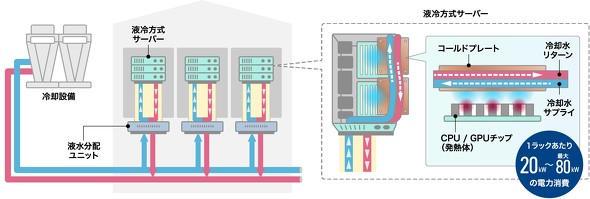

次に、データセンターの冷却方式を見直すことによる電力効率改善も注目されている。現在は、空冷が主流であるが、消費電力の観点では課題がある。送風機に使う電力が大きい点や、サーバの冷却効率が低い点などだ。

特にGPUのような筐体(きょうたい)あたりの発熱量が大きい機器に対しては、空冷の限界が見えつつある。そこで、サーバラック内の配管に冷却水を送る「液冷」や、絶縁性の液体にサーバを浸して直接冷却する「液浸」などが今後の候補となる。

国内のデータセンターにおいても、NTTコミュニケーションズがサーバのヒートシンク(GPUなどのチップからの熱を放熱するためにつけられている部品)へ直接液体を供給する「直接液冷」を採用したデータセンターサービス「Green Nexcenter」を2025年3月より提供を開始する計画である。

関連記事

欧米の製造現場でヒューマノイドロボット導入の動き 「人型」にこだわる本当の理由とは

欧米の製造現場でヒューマノイドロボット導入の動き 「人型」にこだわる本当の理由とは

配膳ロボットにヒューマノイドロボット。AI企業がロボット産業に挑む理由とは? 人間の「真の相棒」となる日も間近? Apple、Googleも発表「マルチモーダルAIエージェント」の今

人間の「真の相棒」となる日も間近? Apple、Googleも発表「マルチモーダルAIエージェント」の今

AppleやGoogleをはじめ、世界のメーカーが開発に力を入れる次世代AIエージェント。今後の可能性を考察する。 エヌビディアの株価急落、インテルの「内憂外患」 AI最前線で今何が起きているのか

エヌビディアの株価急落、インテルの「内憂外患」 AI最前線で今何が起きているのか

AIはデータセンターからエッジへ。AI半導体の次の注目分野はどれか。エヌビディア・インテルの決算から市場の今後を考察する 日本は“無防備”か 選挙で「ディープフェイク」はこう使われる

日本は“無防備”か 選挙で「ディープフェイク」はこう使われる

今年は世界中で重要な選挙が相次ぐ「選挙イヤー」である。注目されているのは、生成AI技術の進展による選挙戦術の変化だ。 「AIの恋人」のめりこみ自殺、米14歳の少年 そもそもどんなサービスだったのか

「AIの恋人」のめりこみ自殺、米14歳の少年 そもそもどんなサービスだったのか

米国で14歳の少年がAIキャラクターとの別れを苦に自ら命を絶った。AIが"完璧な理解者"を演じることの是非とその対策について考える。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR注目記事ランキング