ソフトバンクの人型ロボット「Pepper」――今、人工知能で人の感情はどこまで分かるのか?:短期集中連載「人工知能と生きる」第1回(2/3 ページ)

感情認識の方法はいろいろある

人間の感情を推測する方法は、実はいろいろとある。代表的なものはマイクやカメラを使い、相手の声の高低や喋る速度、また表情を読み取る方法だ。例えば、しかめっ面で声のトーンが高く、大きな声で話していると「怒っている」と判断し、落ち込んだ顔で、声のトーンが低かったら「悲しんでいる」と判断する。

今ではデジタルカメラなどにも人の顔を検出する機能が搭載されているが、表情を認識するというのは難しい技術だ。顔のパーツの位置や大きさ、口やまぶたの開閉といった情報を、すべて数値的な計算のみで分析するというような作業はハード、ソフトの両面で高度な処理が要求される。

また、実際のロボットに実装可能かは置いておいて、瞳孔の開き具合などでもある程度の感情推測が可能だ(対象に興味を持っているときは、アドレナリンの分泌量が増えて瞳孔が開く)。初対面のユーザーでは難しいが、ある程度の期間統計を取っていれば、ユーザーの動作速度がいつもより早いか、遅いかといったデータからも感情の推測は可能となる。このほか、脈拍や発汗量なども感情を知るには使えるデータだ。

SFチックな話ではあるが、最も正確なのは脳の活性化部位を調べることだ。さすがにこれが実装されるのはもう少し先の未来だろう。Pepperは、上に挙げた感情認識方法とはまったく異なる手法で解析しているのかもしれないし、さまざまな情報を複合的に判断している可能性もある。とはいえリリースにもあるように、声のトーンと表情認識が主な判断基準になるはずだ。

実際にPepperと話してみたが……

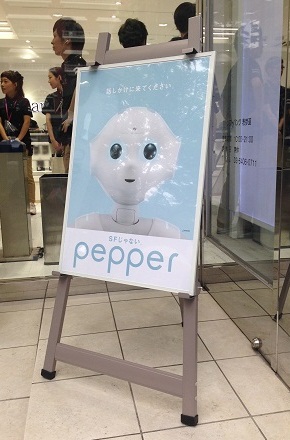

推測はいくらでもできるが、実際はどうなのか。筆者はPepperに会いにソフトバンク銀座に足を運んで、展示されているPepperに話しかけてみた。そこで、何回かコミュニケーションをとったところ、プログラムされた動きは得意なようだが、それ以外の動きはまだこなれていない、という印象を受けた。

こちらから話しかけてもうまく返答してくれなかったり(重ねて言うが、それでもPepperの音声認識はよくできていると思う)、発表会での孫社長との握手のように「握手して」と言っても握手はしてくれなかった。現段階ではPepper内に会話のシナリオパターンがあり、Pepperのほうから話しかけてその返答を認識してパターンに当てはめる、といった機能がメインだと感じた。発表会のようなスムーズな会話のやりとりを期待して行くと、少し拍子抜けするかもしれない。

現在、ソフトバンク表参道とソフトバンク銀座に設置されているPepper(参照リンク)は製品版とは異なるという。発売が半年以上先ということもあり、もしかすると、まだシステム面で開発や調整が終わっていない可能性も十分にある。「人とのコミュニケーションを通じて学習し、成長する機能も実装予定」としている。最初から、あまり過度な期待はしないほうがいいかもしれない。

関連記事

人型ロボット「Pepper」に興味があるのは半数――何を求めますか?

人型ロボット「Pepper」に興味があるのは半数――何を求めますか?

ソフトバンクが人工知能を搭載した人型ロボット「Pepper」を販売すると発表したが、Pepperに興味を持っている人はどのくらいいるのだろうか。20歳以上の男女に聞いた。MMD研究所調べ。 Pepperはなぜあのキャラクターになったのか 極秘開発プロジェクトが宿らせた「魂」

Pepperはなぜあのキャラクターになったのか 極秘開発プロジェクトが宿らせた「魂」

「1年半、誰にも言えなかった」 ソフトバンクのロボット「Pepper」くんの表参道店デビューに行ってきた!

ソフトバンクのロボット「Pepper」くんの表参道店デビューに行ってきた!

「プルンッ」という音が鳴り、Pepperの耳が青くなったらしゃべってOKの合図です。 ロボット化が進めば、中間層はどうなるのか

ロボット化が進めば、中間層はどうなるのか

「人間がロボットに支配される」――。こんな話を本で読んだり、映画で見たことがある人も多いだろう。ロボットの性能が向上しているが、このまま進化していけば人間はどうなってしまうのだろうか。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR注目記事ランキング

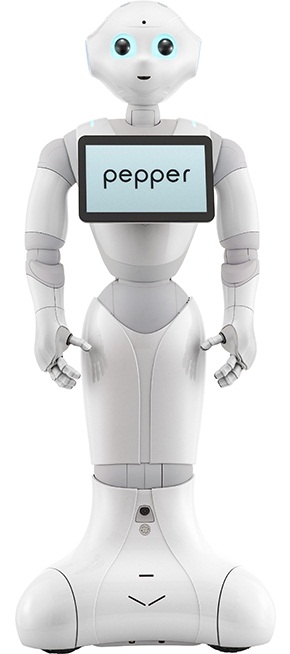

Pepperは付属するマイクとカメラで相手の感情を認識するという

Pepperは付属するマイクとカメラで相手の感情を認識するという ソフトバンク表参道とソフトバンク銀座にはPepperが設置されている

ソフトバンク表参道とソフトバンク銀座にはPepperが設置されている