AIを狙ったサイバー攻撃の知られざる世界 専門知識なしでどう対処するか?:AI×セキュリティの関係を考える

生成AIブームが訪れ、各企業がAI開発に乗り出しているが、AI開発プロセスには脆弱性が潜んでおり、これを悪用することでサイバー攻撃が可能になることは意外と知られていない。攻撃の詳細とそれを防御するための方法を解説する。

この記事は会員限定です。会員登録すると全てご覧いただけます。

情報処理学会(IPSJ)は2023年6月15日、オンラインイベント「AIセキュリティ −AIの脆弱性からシステムを守る−」を開催した。同イベントは「人とAIが共生する社会に向けた情報技術」をテーマに、全12回にわたり、開催される連続型セミナーの第1回だ。

「ChatGPT」をはじめとした生成AI(人工知能)ツールが流行しているが、今後これを本格的に活用するためには、AIに含まれた脆弱(ぜいじゃく)性やリスクを明らかにすることが非常に重要だ。ではそもそもAIにはどのようなセキュリティリスクがあり、これを防ぐためには何をすればいいのか。本稿はイベントにおける3つの講演内容からこれを解き明かす。

画像を誤認識させ事故を引き起こす? AI開発プロセスに潜む脆弱性とは

同イベントでははじめに、情報セキュリティ大学院大学の大塚 玲氏(情報セキュリティ研究科 教授)が登壇し、「AIセキュリティの研究動向」と題して講演した。

大塚氏はまず「AIとセキュリティに関連する話題は3つの観点に分けられる」と話す。1つ目は「AI for Security」だ。これはAIを使ったサイバー攻撃や、AIによってマルウェアなどの脅威を検知・防御・分析する手法を指す。2つ目は「Security of AI」で、AIの知的機能に内在する脆弱性を指す。そして3つ目は「Trustworthy AI」でAIによる欺瞞(ぎまん)やインフォデミックへの対抗策について考える観点だ。今回のセッションでは2つ目の「Security of AI」について取り上げる。

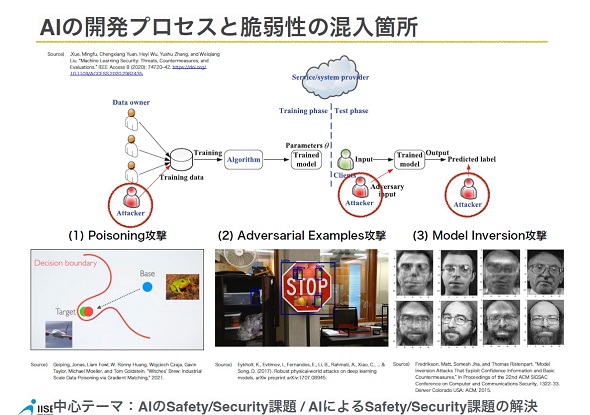

では、AIの知的機能に内在する脆弱性とは何か。大塚氏はAIの開発プロセスを整理した上で、「プロセスの中にある脆弱性を悪用すれば3つのサイバー攻撃が理論上実現可能になる」と指摘した。

大塚氏によると、機械学習(ML)の開発では、訓練データを特定のアルゴリズムに沿って学習させることでAIモデルを作成する。この際、全ての基となる訓練データに対して仕掛けられる攻撃が「ポイズニング攻撃」(バックドア攻撃)だ。

「AとBというデータを識別する境界面に、開発者が意図していない悪意のあるデータ(ポイズンデータ)を“わずかに”紛れ込ませることで、AIの識別境界面を意図的に変化させてモデルの誤識別を誘発する攻撃だ。ある顔認証システムにポイズンデータを注入されたAIが使われていたとして、例えば顔に特定のシールが貼ってある場合のみ、認証を許可するように誤認識させるといったことが理論上可能になる」(大塚氏)

大塚氏によると、AI開発プロセスにおいては「Transferability」(転移性)という性質があり、ニューラルネットワークが異なっていても、基となる訓練データが同一の場合、同様の影響が受けることがあるという。そのため使用する訓練データがポイズニング攻撃を受けていないかどうかといった真正性の確保は今後のAI開発において大きな課題になると大塚氏はみている。

2つ目は「モデルインバージョン攻撃」だ。これはAIモデルから訓練データを抽出する攻撃で悪用例を挙げると、顔認証システムではIDから登録ナンバーの顔を推定したり、医療情報システムでは病名から患者の個人情報を推定したりすることが可能になる。

「下図の右は訓練データに使った顔写真で、左はモデルインバージョン攻撃によってAIモデルから復元した顔写真だ。非常に特徴をつかんだ画像が復元できていることが分かる」(大塚氏)

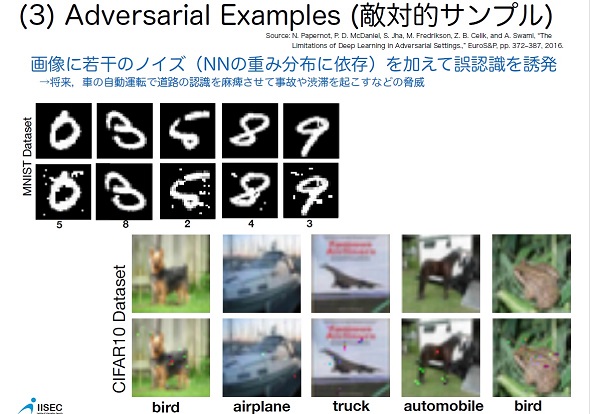

3つ目は「アドバーサリアルエグザンプル」(敵対的サンプル)で、画像に若干のノイズを加えることで、誤認識を誘発する攻撃だ。分かりやすい例でいうと、下図ように、ある画像に点などを打つことで、数字の「9」を「3」に、船を飛行機に誤認識させる。

大塚氏は最後に「これを悪用すると、道路標識を誤認識させて自動運転において事故や渋滞を引き起こすことが可能になる。将来的には、従来のシステムよりAIを使ったシステムの方が多くなると予想されるため、これらの観点は今後対策を講じる必要が出てくるはずだ」と講演を締めくくった。

従来のセキュリティ対策ではカバーできないML特有の課題にどう対処する?

こうした新種のサイバー攻撃を防ぐためにわれわれは何をすべきか。次に富士通の矢嶋 純氏(富士通研究所 AIトラスト研究センター プリンシパルリサーチャー)が登壇し、「AI開発者向けの機械学習システムセキュリティガイドライン」と題した講演でその詳細を語った。

矢嶋氏ははじめに「大塚先生の発表にもあった3つのサイバー攻撃に加えて、細かく見ると、AIモデルを無断で複製する『Model Extraction』や特定のデータが訓練データに含まれるかどうかを推測する『Membership Inference』という攻撃も脅威的だ」と話す。

こうしたサイバー攻撃によって、自動運転AIを誤判断させて事故を引き起こしたり、なりすまして建造物に侵入して金品を窃盗したり、複製したAIモデルを無料でばらまいたりといった被害が想定されるという。矢嶋氏は「これらを防ぐためにもサイバー攻撃に強いAIシステムを構築する必要がある」と主張する。

だがAIシステムには、正当なアクセス権限を持ったユーザーがサイバー攻撃者としてアクセスしてくる可能性があり、現行の技術ではこの判別が困難なことも多くある。そのためML特有のセキュリティ対策が必要だ。

矢嶋氏は「守り方としては、仕様や運用を変更してサイバー攻撃の機会を減らすという手法と検知やAIモデルの強化といった抜本的な対策を講じる手法の2つがあり、今回紹介する『機械学習システムセキュリティガイドライン』は前者を担う」と語る。

YES/NO形式の質問に答えるだけでリスク分析を実現?

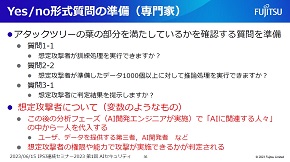

機械学習システムセキュリティガイドラインは、AI開発者がMLシステムのセキュリティを構築する際にリファレンスとして活用できるように、日本ソフトウェア科学会の公式研究会である機械学習工学研究会(以下、MLSE)によって2022年6月に第1版が作成された。MLSEが運営しているSNSコミュニティには350人以上の研究者やエンジニアが参加しており、MLシステムの開発や運用にまつわる生産性や品質の向上を追求して互いの研究やプラクティスを共有している。

同ガイドラインは、本編とリスク分析編、付録(攻撃検知概要)の3編に分かれている。本編では開発工程などセキュリティ対策の一連の流れを体系的に整理し、リスク分析編ではドキュメントと脅威分析ツールを、付録(攻撃検知概要)ではML特有のサイバー攻撃を検知する技術や実装すべき防御方法にフォーカスした内容になっている。矢嶋氏はこれらの中でも特にリスク分析について掘り下げて解説した。

矢嶋氏は「AIシステムにおけるセキュリティ対策はまだ、攻撃評価や防御手段が未成熟でベストプラクティスが確立されていない。そのため現状では、ML特有の防御手段と運用による防御手段を適切に組み合わせることが重要になる。このガイドラインは、MLシステム特有のサイバー攻撃に向けたセキュリティ対策の一連の流れを把握し、セキュリティ専門家ではないAI開発者自身でもセキュリティリスクを分析できることを目的としている」と話す。

同氏によると、一般的なサイバーセキュリティにおけるリスク分析の流れを振り返ると以下の図のようになる。特に重要なのが4の「脅威を実現する攻撃手法の調査」(脅威分析)と5の「脅威が実現した場合のリスクの評価」(影響分析)だ。これらを相互に適切に組み合わせることで「被害を及ぼす攻撃のうち実現可能性が高いものはどれか」「それに対してどのような対処を講じればいいか」が明確になる。

機械学習システムセキュリティガイドラインの第1版にはこのうち脅威分析を支援する、ML向けのサイバー攻撃シナリオをまとめたアタックツリーとこれに関連する質問形式のチェックシートが掲載されている(影響分析については第2版でまとめられている)。AI開発者が自社のAIシステムの仕様情報を基にYES/NO形式の質問に回答していくことで、実現可能性があるML向けのサイバー攻撃やそれに向けた防御方法がフィードバックされる仕組みだ。

「AIセキュリティに関する専門的な知識が乏しい場合でもこれに回答することでユーザーロールごとに攻撃が実現するまでの条件が明らかになる。そこで対策を講じる際にはこのツリーが不成立になる方法を考えればいい。ただ、どうしても条件や仕様を変更できないケースもあるため、そういう場合は専門家に相談し、検知やモデル強化といった抜本的な対策に切り替える必要がある」(矢嶋氏)

なお、機械学習システムセキュリティガイドラインには22種類の攻撃アルゴリズムに対応しているが、これに含まれていない攻撃は当然実施可否を評価するのは困難だ。矢嶋氏は「このツールは簡易的なセルフチェックやセキュリティ専門家と相談する際に活用してほしい」と話す。

「このチェック機構をAI開発プロセスの中に組み込むことで、AI開発者自身である程度リスク分析を実施して手戻りを防げるようになる。これを実施してなお、どうしても難しい部分だけを専門家に相談するというのが今後、目指すべき方向性だと考えている」(矢嶋氏)

MLの課題はまだまだある

その他、同イベントではデンソークリエイトの中神徹也氏(研究開発部)とデンソーの桑島 洋氏(ソフト生産革新部)による「自動車業界におけるAI Safety動向」と題した講演も実施された。

同セッションでは、物体認識や物体検出、セマンティックセグメンテーションといったMLベースの画像認識技術や、それらの自動運転技術への応用と現状のリスク、MLモデルの品質保証における技術的課題、ML開発の安全性強化に向けた国家や各産業の法規制およびガイドライン整備の最新動向などが語られた。

連続型セミナーの第2回では、AIによる誤情報やフェイクニュースといった悪質なデマにどのように対処すべきかを紹介する。

関連記事

生成AIをどうサイバー防御に生かすか 有効策をセキュリティ専門家が提言

生成AIをどうサイバー防御に生かすか 有効策をセキュリティ専門家が提言

生成AIは技術的な革新であり、多くの企業が有効に活用する方法を模索している。セキュリティにおいてもそれは同様だ。攻撃・防御側それぞれでどのような使い方が考えられるか。 ビジネス向け生成AI開発最前線、日本IBMが仕掛けるアプローチ

ビジネス向け生成AI開発最前線、日本IBMが仕掛けるアプローチ

「ChatGPT」の登場で急速に進む生成AIブーム。企業が自社のビジネスに特化した生成AIを開発するためにはどうすればいいのか。AI開発の歴史を振り返りつつ最適なアプローチを日本IBMが推奨した。 経営者とセキュリティ担当者が分かり合うためのフレームワークを知っているか?

経営者とセキュリティ担当者が分かり合うためのフレームワークを知っているか?

ランサムウェア攻撃が高度化する今、全社一丸となってセキュリティ対策を講じるには、経営層から現場のセキュリティ担当者までが同じ言葉で語り合い、足並みをそろえる必要がある。これを実現するフレームワークを解説しよう。 企業の「OSSただ乗り」はもう限界 Log4jの悪夢から何を学ぶか

企業の「OSSただ乗り」はもう限界 Log4jの悪夢から何を学ぶか

Tideliftの調査によると、OSSの主要な製作者に対する報酬の格差が明らかになり、ソフトウェアのサプライチェーンを適切に保護する方法についての疑問が呈されている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 知らない番号でも一瞬で正体判明? 警察庁推奨アプリの実力を検証

- 生成AIで消えるのは仕事、それとも新人枠? 800職種のデータから分かったこと

- Windows RDSにゼロデイ脆弱性 悪用コードが22万ドルで闇市場に流通

- もはやAIは内部脅威? 企業の73%が「最大リスク」と回答

- 政府職員向けAI基盤「源内」、18万人対象の実証開始 選定された国産LLMは?

- 「ExcelのためのChatGPT」ついに登場 GPT-5.4で実用レベルに?

- その事例、本当に出して大丈夫? “対策を見せたい欲”が招く逆効果

- 本職プログラマーから見た素人のバイブコーディングのリアル AIビジネス活用の現在地

- セキュアな開発を強力支援 OpenAIが新エージェント「Codex Security」を公開

- 監査対策のはずが現場崩壊? 情シスがハマるツール導入のわな

情報セキュリティ大学院大学の大塚 玲氏

情報セキュリティ大学院大学の大塚 玲氏

富士通の矢嶋 純氏

富士通の矢嶋 純氏