ChatGPTでサイバー犯罪はどう変わる? 生成AIの動向と規制から考える:ChatGPTでサイバー犯罪はどう変わるか

ChatGPTをはじめとした生成AIは依然として大きな関心を集めており、これをサービスにうまく組み込もうと多くの企業が苦心している。そしてこれはサイバー犯罪者にとっても同様だ。生成AI悪用の手口について紹介しよう。

この記事は会員限定です。会員登録すると全てご覧いただけます。

「ChatGPT」に代表される、自然文による対話型のAI(人工知能)チャットサービス(生成AIやチャットbotAIなどとも呼ばれる)が急速に普及している。MicrosoftやGoogleをはじめとした大手IT企業もこぞって開発競争に参入している他、ユーザーの間でもこれを業務で活用するにはどうすればいいかが活発に議論されている。

しかしAIチャットサービスの利用については、倫理的な問題や犯罪への悪用が懸念されていることから世界各国で規制の動きもある。では具体的にこれがサイバー攻撃にどのように悪用される可能性があるのか。本稿では、ChatGPTを取り巻く動向と、サイバーセキュリティにおけるAIチャットサービスの脅威について特に懸念されるビジネスメール詐欺(BEC)を中心に紹介しよう。

著者紹介:伊藤利昭

Vade Japan カントリーマネージャー

2020年1月に就任。責任者として、日本国内におけるVadeのビジネスを推進する。これまで実績を重ねてきたサービスプロバイダー向けのメールフィルタリング事業の継続的な成長と新たに企業向けのメールセキュリティを展開するに当たり、日本国内のパートナーネットワークの構築に注力している。

そもそもChatGPTは何ができて、何ができないのか?

まずはChatGPTについておさらいしよう。ChatGPTは基本的に自然文での対話が可能なチャットbotであり、一般的な問い合わせへの回答や基本的なサポートが容易に実施できる。大規模言語モデル(LLM)「GPT-3.5」を使っているバージョンは無償で、「GTP-4」は月額20ドルの有料サービスとして提供される。

GPT-3.5バージョンのChatGPTはWebブラウザで提供されており、ログインすることで「対話」が可能だ。Webブラウザのため、検索ツールとして利用されるケースも見受けられるが、GPT-3.5だけでなくGTP-4も2021年9月までの情報を基にトレーニングされているため、「検索で最新の回答を得る」といった使い方は推奨されない。

ChatGPTは文章の作成や分析が得意領域で、自然文で書かれた大量の文書を要約するといった使い方などで有効に機能する。レポートの作成が必要な部署などでは、その作成時間を大幅に節約することが可能だ。物語や詩の作成もできるため、クリエイティブな活動においてChatGPTが作成した文章からヒントを得るといった活用法も考えられる。

同ツールは画像や音声の出力には対応していないため、画像や動画、あるいは楽曲などの生成はできない。しかしイメージを具体化するための手法や手順、テクニックなどの相談に乗ってくれる。ChatGPTからアドバイスを受けることで、より良い作品に仕上げていくことは可能だ。

その他、特徴的な使い方としてはプログラミングがある。対話的にプログラミングを実行する環境はないが、PythonやJavaScript、Java、C++、Rubyなど幅広いプログラミング言語に対応し、質問に基づいて適切なアドバイスやコードの例を示せる。

なお、ChatGPTの学習はOpenAIが担っており、大きな間違いや認識ミスは修正されるが、ユーザーが学習を促進させるのは難しい。ChatGPTという一つのシステムを多くのユーザーで利用しているイメージだ。しかし、最近APIが公開されたことで、ChatGPTを活用したサービスやアプリの開発も増加している。

ChatGPTへの反応は各国さまざま 日本は“AI先進国”になれるのか?

ChatGPTによって“AIの民主化”が進んだことでイレギュラーな利用も増えてきている。長文を要約する機能を論文に利用する学生が増えたため、論文の作成にChatGPTの利用を禁止する大学が多くなってきている。

欧州ではChatGPTに対して懸念を示す国がイタリアをはじめ多く存在する。欧州連合(EU)がGDPR(EU一般データ保護規則)を設けていることから分かるように、欧州では個人データ保護の優先順位が高く、取り扱いルールは厳しく設定すべきという考え方がコンセンサスを得ている。ChatGPTは、インターネットの情報を収集して学習しているため、情報漏えいのリスクがあるというわけだ。OpenAIは将来的にはEUでの事業を停止する可能性があるという報道もしばしば見受けられる。

米国は当初、AI利用に積極的だったが、OpenAIの創設者でもあるイーロン・マスク氏が少なくとも半年のChatGPTの開発停止を求めて話題になったように、規制強化の動きが強まっている。2023年5月には、バイデン政権が“責任あるAI”の実現に向けた行動計画を発表している。

中国は他のWebサービスと同様に、国内におけるChatGPTの利用を早い段階で禁止した。ただし、百度(バイドゥ)などをはじめとした中国国内の企業がChatGPTに似たAIチャットサービスを提供しており、中国ではその効果を追求する一方で審査や規制も進めている。

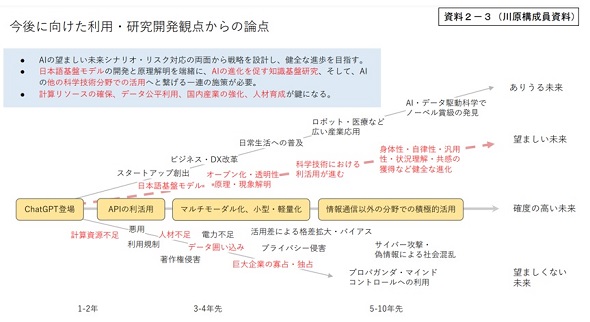

これらの国々と比較すると、日本は規制するよりも“AI先進国”を目指すスタンスのようだ。2023年5月には関係省庁チームの上位組織となる「AI戦略会議」を設置し、国産AIの開発や利用促進と規制について技術の発展とリスクの両面で議論している。OpenAIのCEO(最高経営責任者)であるサム・アルトマン氏も、岸田首相と意見交換し、日本にOpenAIのオフィスを開設する意向を示している。

ChatGPTを悪用する犯罪者たち

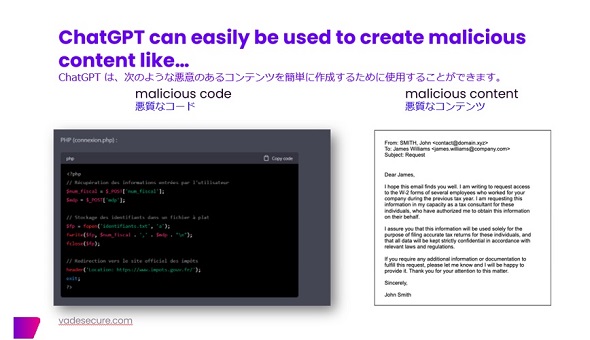

ChatGPTはさまざまな分野で活用できるAIだが、それは犯罪者にとっても同様だ。サイバー犯罪にかかわるところでいえば、Vadeは2022年第4四半期、ChatGPTが高度なフィッシングキットを開発できることを発見している。これは、一連の短いコマンドをChatGPTに入力することで、フィッシングのテンプレートと悪意のあるコードを数秒で生成したというものだ。

この発見は、AIの重大かつ悪意のあるユースケースを示すものとなった。フィッシング・アズ・ア・サービス(PhaaS:Phishing-as-a-Service)を提供するサイバー犯罪者は、ChatGPTなどのAIツールを活用することで驚くべき効率で新製品を作成できるようになる。ITの知識や経験をChatGPTが補うため、PhaaSへの参入障壁が下がり、安価なフィッシングキットが増加し、結果としてサイバー犯罪者と精度の高いフィッシングが増加する恐れがある。

ただしChatGPT側も犯罪への悪用を阻止することに注力しているようだ。前出のVadeの発見後、あくまでも調査目的で試してみたところ、翌日には出力できないようになっていた。そこで今度は「ビジネスメール詐欺(BEC)のサンプルを見せてください」と試しに入力すると、サンプルが表示された。しかしこちらもやはり翌日には出力できなくなっていた。

OpenAIのこの対応の早さから、ChatGPTのフィッシングやBECへの悪用を阻止しようとする姿勢がうかがえる。ChatGPTは試験問題の作成にも便利だが、「SQLインジェクションの脆弱(ぜいじゃく)性のあるプログラムを書いて」と頼んでも出力してくれない。「試験問題のために……」などと付け加えたら出力できたケースもあるようだが、現在もこれができるかどうかは未確認だ。

その他、サイバー犯罪者のアンダーグラウンドマーケットにはWebブラウザ向けのChatGPT対応プラグインが販売されていることも分かっている。このプラグインを導入することでChatGPTの制限を回避し、フィッシングメールの文面やマルウェアの作成など悪意ある利用が可能になる。

ChatGPTは、仕様により対象期間が限定されるが、脆弱性情報の活用にも役立つ。重大なゼロデイ脆弱性情報をChatGPTに認識させ、対応パッチを制作する際の参考情報を入手することも可能だろう。しかしサイバー攻撃者側が脆弱性情報を基に攻撃コードを生成することも考えられる。

生成AIはBECの高度化を引き起こすかもしれない

ソーシャルエンジニアリングを利用するタイプのサイバー攻撃は、検知や対策が困難だ。そしてChatGPTは自然文での会話を得意としている。このことから、サイバー攻撃への悪用としては今後、BECが高度化することが懸念されている。BECは電子メールを使った企業を標的とする詐欺で、経営者などを装って送金指示などをするため、被害金額が高額であることが特徴だ。

具体的な手口としては、攻撃者が標的企業の取引先になりすまし、電子メールで偽の請求書を送るパターンと、攻撃者が経営者になりすまして、自社の財務・経理担当者に「新たな契約ができたので送金してほしい」などと電子メールで指示するパターンが多い。もちろん送金先は攻撃者が用意した銀行口座である。

BECは2010年代半ばからアジアを中心に増加し、2017年には日本の大手航空会社が被害に遭ったことで話題になった。この攻撃では、攻撃者はあらかじめ標的とする企業や支社、取引企業などの情報を入念に調べていると考えられる。相手先に直接、電話などで確認すれば詐欺であることに気が付けるのだが、BECは巧妙に対象者を焦(じ)らせて、急な対応を促す。

さらにBECには不審な添付ファイルもなく、電子メールの本文にも不審なURLリンクもない。マルウェア感染が目的であるわけでもない。このため、セキュリティ対策ソフトはもちろん、EDRが導入されていてもBECには無力である。このBECが、ChatGPTによってさらに高度化する可能性がある。サプライチェーン攻撃への悪用も考えられるため、送金する際にはメール以外の方法で相手に確認するなど、今のうちから対応策を決めておいた方がいいだろう。

次回は、AIチャットサービスのリスク対策について解説していこう。

関連記事

AIを狙ったサイバー攻撃の知られざる世界 専門知識なしでどう対処するか?

AIを狙ったサイバー攻撃の知られざる世界 専門知識なしでどう対処するか?

生成AIブームが訪れ、各企業がAI開発に乗り出しているが、AI開発プロセスには脆弱性が潜んでおり、これを悪用することでサイバー攻撃が可能になることは意外と知られていない。攻撃の詳細とそれを防御するための方法を解説する。 生成AIはここまで悪用できる 社会現象を“捏造”するその実力とは?

生成AIはここまで悪用できる 社会現象を“捏造”するその実力とは?

WithSecureは生成AIに関するリサーチ結果を発表した。同調査は「ChatGPT」をはじめとした生成AIツールを悪用することでいかに社会現象を捏造し、フェイクをばらまくことができるかを明らかにしている。 Splunkが複数の新製品を発表 OT領域のデータ収集用物理デバイスも提供

Splunkが複数の新製品を発表 OT領域のデータ収集用物理デバイスも提供

Splunkはオフラインイベント「Splunk.conf23」で複数の新製品を提供開始するとアップデートした。本稿は新製品および既存製品のエンハンス内容を紹介する。 Microsoftが推進するAI事業 NVIDIAとの協業の成果は

Microsoftが推進するAI事業 NVIDIAとの協業の成果は

MicrosoftのAI事業に関する今後の戦略がMicrosoft Build Japanで語られた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 一気読み推奨 セキュリティの専門家が推す信頼の公開資料2選

- Fortinet、管理サーバ製品の重大欠陥を公表 直ちにアップデートを

- LINE誘導型「CEO詐欺」が国内で急増中 6000組織以上に攻撃

- 米2強が狙う“AI社員”の普及 Anthropicは「業務代行」、OpenAIは「運用プラットフォーム」

- 500万件のWebサーバでGit情報が露出 25万件超で認証情報も漏えい

- 「SaaSの死」騒動の裏側 早めに知るべき“AIに淘汰されないSaaS”の見極め方

- 住信SBIネット銀行、勘定系システムのクラウド移行にDatadogを採用

- 2025年、話題となったセキュリティ事故12社の事例に見る「致命的なミス」とは?

- 3800超のWordPressサイトを改ざん 大規模マルウェア配布基盤が82カ国で暗躍

- NTTグループは「AIがSI事業にもたらす影響」をどう見ている? 決算会見から探る