HPC向けストレージがAI時代に輝く理由 DDNの新製品はRAGを“22倍”高速化

DDNジャパンによればLLMの学習と推論には高性能なストレージが不可欠だという。HPC向けストレージの仕組みをAIに転用する利点はどこにあるのだろうか。

この記事は会員限定です。会員登録すると全てご覧いただけます。

HPC(ハイパフォーマンスコンピューティング)やAI向けのストレージを提供するデータダイレクト・ネットワークス・ジャパン(以下、DDNジャパン)は2025年9月9日、記者発表会を開催した。生成AIの普及で爆発的に増大するデータ処理の要求に応えるための新戦略と、それを支える新製品「Infinia」を発表した。スーパーコンピュータの世界で培われた技術は、AIサービス開発のボトルネックをいかに解消するのか。

AIインフラの課題はGPUだけじゃない

DDNのストレージは、理化学研究所と富士通が開発するスーパーコンピュータ「富岳」にも採用されるなど、アカデミックや研究機関向けのHPC市場で長年の実績を誇る。

DDNジャパンのロベルト・トリンドル氏(代表取締役社長)は「アプリケーションのリソースは結局のところ『データ』だ。そのデータをどのようにアプリケーションに提供するか、どのように分散するかということがアプリケーションの運用効率に影響を与えている」と述べ、HPCの世界で培った知見が、現在のAIサービス開発が直面する課題解決に直結すると強調した。

DDNジャパンの井原修一氏(プリンシパルエンジニア)によれば、AIとHPCに必要とされる要素には共通項が多い。ハードウェア面では大規模なクラスタの構築、低遅延かつ高帯域なネットワーク、高速なストレージなどが挙げられる。ソフトウェア面でもそれらの大規模なクラスタを管理する仕組みや並列処理フレームワークが必要になる。

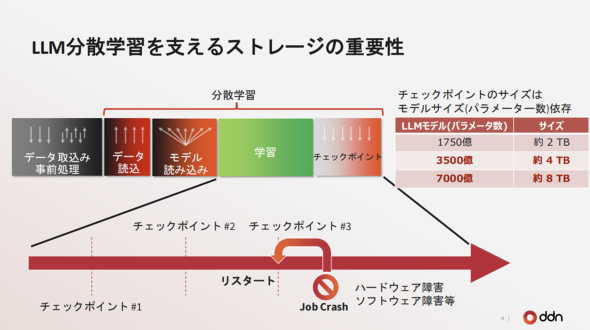

生成AIの活用が企業にとって課題となり、これらの要素の中でもGPUサーバに真っ先に投資をする企業もある。しかし、膨大なデータを効率的に処理するには、計算能力だけでなく、データを滞りなく供給するストレージの性能も重要だ。井原氏によれば大規模言語モデル(LLM)の学習は数カ月に及ぶケースもあるため、途中で障害があった場合に備えてメモリのデータのスナップショットをストレージに保存する。一定時間ごとにスナップショットを保存するには高速にデータを書き込めるストレージが必要だ。

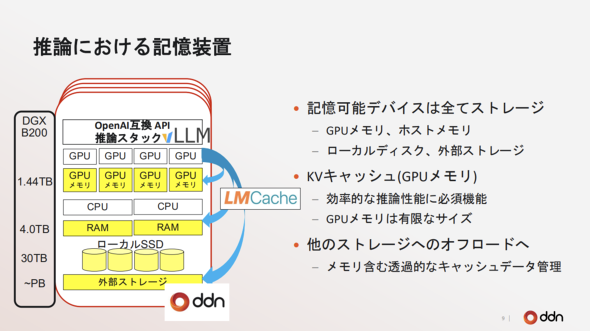

LLMの推論においてもストレージの性能が重要になる。LLMはユーザーとのやりとりを逐一KVキャッシュとして保存し、次の生成の際の文脈理解に利用している。LLMとユーザーのやりとりが長大になるほど、LLMが記憶しておく必要があるデータ量が雪だるま式に増えていく。GPUメモリは容量が限られているため、オープンソースツール「LMCache」などを介してRAMやストレージにKVキャッシュをオフロードする必要がある。この場合においても、高速にデータを読み書きできるストレージがあるに越したことはない。

新製品「Infinia」がRAGを22倍高速化

今回の発表会では同社の新しいストレージプラットフォーム「Infinia」が発表された。その特徴はアプリケーションがデータに直接アクセスできるSDK(Software Development Kit)を提供し、データ処理のワークフローを高速化する点にある。

標準的な「Amazon S3」互換ストレージが複数のソフトウェア層を介するのに対し、InfiniaはSDKを通じてドライブと直接通信することで中間処理を省略し、低レイテンシを実現するという。発表会では、NVIDIAとの協業で実施したRAG(Retrieval-Augmented Generation)パイプラインの高速化事例が紹介された。Amazon Web Services(AWS)の標準的な実装と比較して、ストレージをInfiniaに置き換えることで、RAGパイプラインにおけるインデックスの速度が22倍に向上したという。

AIサービス事業の成否は、GPUの計算能力だけでなく、ストレージを含めたインフラ全体の効率性にかかっている。HPCの世界で磨かれたDDNの技術が、AIサービス開発市場で新たな輝きを放つことができるか、その動向が注目される。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 悪いのは本当にVPN? 日本医科大武蔵小杉病院のランサムウェア事件をダークWebから解明

- SMBC日興証券が「パスキー」で口座乗っ取り対策 約5カ月で実現したのはなぜ?

- アサヒGHDがランサムウェア被害の調査報告書を公開 152万の個人情報が漏えいの恐れ

- 関西電力が「AIファースト企業」化に本気 脱JTCを図る背景と全従業員“AI武装化”の全貌

- 日本IBMのAI戦略“3つの柱” 「制御できるAI」でレガシー資産をモダナイズ

- 生成AIの記憶機能を悪用して特定企業を優遇 50件超の事例を確認

- 東海大学、ランサムウェア被害を報告 19万人超の個人情報が漏えい

- 保守の「脱・人月ビジネス」化は進むか それでも残る仕事は何か

- そのセキュリティ業務、自前と外注のどちらが正解? 勘に頼らない判断のこつ

- 初期侵入口は“またVPN” 日本医大武蔵小杉病院にランサムウェア攻撃

DDNジャパン ロベルト・トリンドル氏(出典:筆者撮影)

DDNジャパン ロベルト・トリンドル氏(出典:筆者撮影)