1時間6.5ドルでAIを開発できる時代へ――TPUをクラウドで提供したGoogleの真意:画像認識や音声認識にすぐ使える「リファレンスモデル」も公開(1/2 ページ)

Googleは2018年6月27日、「Cloud TPU」の本番公開に踏み切った。これは、同社の機械学習用ライブラリ「TensorFlow」の処理を高速化するプロセッサ「TPU」のクラウド版だ。「TPUは外販しない。あくまでクラウドで提供する」と同社が強調する理由とは一体何か。

「従来あった『大規模な投資ができる企業でないと、AIは使えない』というイメージを変えたい。だからこそ、TPUの外部向け販売はせず、顧客にとってメリットの大きいクラウドの形式で提供する」――グーグルでGoogle Cloudのデベロッパーアドボケイトを務める佐藤一憲氏は、2018年7月6日に同社が開いたメディアセミナーに登壇し、そう語った。

Googleは、オープンソースで公開している機械学習用ライブラリ「TensorFlow」での高速処理に特化したプロセッサ「TPU(Tensor Processing Unit)」の機能を、同社のクラウド「Google Cloud Platform(GCP)」上で、「Cloud TPU」として2018年6月27日から提供している(注)。

注:Googleは、2018年2月にCloud TPUのβ版を公開。6月27日に本番サービスを公開(GA:generally available)とした。

TPUが機械学習に登場した意味

「TPU(Tensor Processing Unit)」は、もともとGoogle社内の機械学習ライブラリとして作られ、2015年にオープンソースソフトウェアとして公開された「TensorFlow」での高速処理に特化したプロセッサだ。

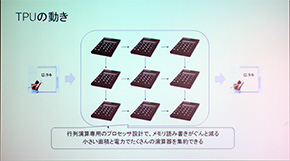

機械学習には、大量のデータを集めて「学習」させる段階と、学習結果を基に「推論」を行う段階があり、どちらも大量の演算処理を必要とするが、CPUやGPUで主流の32bitもの演算精度は求められていない。またCPUやGPUでは、1つの演算処理を行うたびに記憶領域に書き込む処理を行うなど、演算速度の限界や消費電力の大きさに課題があった。

一方、TPUは「単純な計算処理を大量に高速で行う」という機械学習の要件を反映し、16bit(学習向け)や8bit(推論向け)などに演算精度を最適化した上で、記憶領域に処理を書き込む頻度を削減。計算コストや消費電力を縮小し、演算速度の高速化を実現した。

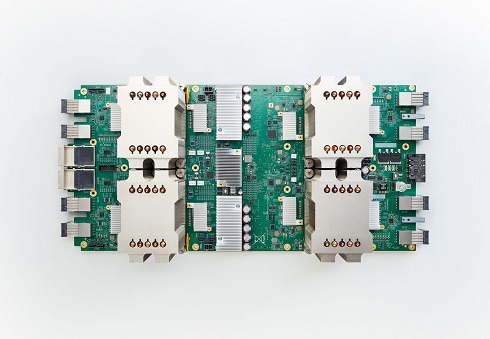

2016年に、推論に特化した最初のモデル「TPU v1」を発表して以来、GoogleはTPUの改良を繰り返し、その次世代モデルである「TPU v2」および2018年5月発表の最新モデル「TPU 3.0」は、推論と学習どちらのニーズにも対応する。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 初期侵入口は“またVPN” 日本医大武蔵小杉病院にランサムウェア攻撃

- 「2027年1月12日」は運命の日? サポート切れOSを使い続ける会社の末路

- 富士通、ソブリンAIサーバを国内製造開始 自社開発プロセッサー搭載版も

- ホワイトハッカーが明かす「ランサムウェア対策が破られる理由」と本当に効く防御

- Googleが「AI Threat Tracker」レポートを公開 Geminiを標的にした攻撃を確認

- シャドーAIエージェントを検出 Oktaが新機能「Agent Discovery」を発表

- SOMPOグループCEOをAIで再現 本人とのガチンコ対談で見えた「人間の役割」

- AIエージェント普及はリスクの転換点 OpenClawを例に防御ポイントを解説

- NTTデータ、仮想化基盤「Prossione Virtualization 2.0」発表 日立との協業の狙いは

- 「AI前提」の国家戦略と「思考停止」の現場 大半の企業で“何も起きない”未来を予見

Google Cloudのデベロッパーアドボケイトを務める佐藤一憲氏

Google Cloudのデベロッパーアドボケイトを務める佐藤一憲氏