【新連載】コンピュータの進化はもう限界? ITの歴史で読み解くその真相:「ムーアの法則」を超える新世代コンピューティングの鼓動(1/2 ページ)

日進月歩で発展し続けてきたコンピュータの世界ですが、技術的な限界が近づきつつあると言われています。果たしてそれは本当なのでしょうか? これまでの常識にとらわれない新しい動きを紹介していきましょう!

2016年に入ってからも、コンピュータの進化を説明する「ムーアの法則」が限界に近づいていると話題になっています(関連記事)。もうコンピュータは、これまでのような進化を見られないのでしょうか? 実は従来とは異なる形の新しいコンピュータが実現されようとしています。この連載ではその姿を解き明かします。まずはおさらいの意味で、これまでのITの歴史とコンピュータの進化を振り返りたいと思います。

コンピュータ通信からクラウドへ

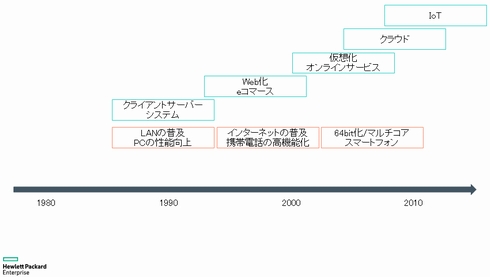

1950年代に最初の商用コンピュータの販売から80年代にかけて、コンピュータは徐々に相互接続ができるようになっていきました。ただし、今のように多くのデータをやりとりするわけではなく、バッチ処理などの結果をコンピュータ同士で渡し合うといった程度でした。

90年代に入るとCPUの性能向上や低価格化によって、PCの処理性能が上がってきます。企業でもLANが普及しと、クライアント・サーバシステムに代表されるような分散型システムの時代になりました。それまで中央のコンピュータ作業させるための端末として使用されていたPCは、中央のコンピュータにおける処理の一部を担うことが可能になり、PC用のアプリケーションがサービスを提供し、必要なデータのやりとりだけが中央のコンピュータに任かされるようになったり、支店業務のほとんどを支店内のサーバ群で処理するようになったりしました。

分散型になることで個々のコンピュータの規模は小さくなるものの、管理するコンピュータの台数は増えることになります。そこで、管理者がより操作しやすく、アプリケーションの開発もしやすいUNIXやWindows NTといったオープンな環境が増えていくことになりました。またLinuxが登場したのもこの頃です。私が大学で情報工学を学び、IT業界に就職したのはちょうどこんな時代でした。

90年代後半にインターネットが一般にも普及し始めると、多くのアプリケーションがWeb化していきます。携帯電話の普及と端末の能力向上によって、ユーザーが常に持ち歩く端末もWebの世界へ参加するようになります。それに伴ってAmazonや楽天といったeコマースが普及し始めますが、それでも当初はWebサーバに当てられるようなコンピュータの能力はあまり高くはなかったため、多くのトラフィックをさばくために静的ページを司るサーバと動的なページ生成を行うサーバを分けるといったシステム構成も多くみられました。その頃はx86アーキテクチャがまだ32ビットだったため、扱えるメモリ領域はわずか4Gバイトという制約も起因していたのでしょう。

2000年代に入り、x86が64ビット化して飛躍的に扱えるメモリ量が増えました。プロセスルールの微細化も進んで、1つのプロセッサに複数のコアを搭載したり、クロック数を向上させたりするなどのアプローチにより、CPU自体の処理能力が大きく向上していきます。

すると、今度は余ったリソースをより効率的に使うための仮想化技術が脚光をあび始めました。現在ではほとんどのコンピュータシステムに仮想化技術が使われています。同時にネットワーク機器の価格が下がり、一般家庭ではブロードバンドが普及します。携帯電話の能力もさらに向上し、それらを利用したオンラインサービスが普及してきます。この時代はクラウドの始まりでした。

関連記事

第14回 「Software-Defined Storage」にまつわるウソホント

第14回 「Software-Defined Storage」にまつわるウソホント

ハイパーコンバージドのための先端キーワードが「Software-Defined Storage」。欧米では「これまでの聖域に対する“破壊的イノベーション”」とされています。そんなSDSの真相と現状、課題を解説します。 第13回 欧州でトレンド 「ハイパーコンバージド」って何?

第13回 欧州でトレンド 「ハイパーコンバージド」って何?

コンバージドインフラが人気の欧米では、また新たなトレンドが生まれています。「ハイパーコンバージド」をご存じですか? 第21回 難しい? Software-Definedとx86サーバの誤解

第21回 難しい? Software-Definedとx86サーバの誤解

クラウドがマーケ寄りのトレンドなら、技術寄りのトレンドは「Software-Defined」です。でも、Software-Definedについて多くの方が誤解していること、そして日本でそれほど伸びていない現実……があります。その理由は何でしょう。 第21回 難しい? Software-Definedとx86サーバの誤解

第21回 難しい? Software-Definedとx86サーバの誤解

クラウドがマーケ寄りのトレンドなら、技術寄りのトレンドは「Software-Defined」です。でも、Software-Definedについて多くの方が誤解していること、そして日本でそれほど伸びていない現実……があります。その理由は何でしょう。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 悪いのは本当にVPN? 日本医科大武蔵小杉病院のランサムウェア事件をダークWebから解明

- VS Code拡張機能4件に重大な脆弱性 累計ダウンロード数は1.2億

- 「SaaSの死」論議の本質はどこにあるか? Salesforceの取り組みから探る

- 中国AI3社がClaudeに大規模蒸留 Anthropicが指摘する「重大なリスク」

- 生成AIを悪用か 世界55カ国で600台超のFortiGate侵害が発生

- 「VPNをやめれば安全」というほど簡単じゃない 真の「脱」を達成するには

- Anthropicが「Claude Code Security」発表 脆弱性発見・修正はもうお任せ?

- AIに代替される人材の特徴は? 「2029年までに定型業務のみ人材の90%がAIに」

- アサヒGHDがランサムウェア被害の調査報告書を公開 152万の個人情報が漏えいの恐れ

- なぜ予算を掛けてもセキュリティは強化できない? 調査で分かった3つの理由