AI時代の軸「データ」はどう扱うべきか Just Worksなインフラに求められるものは(1/3 ページ)

2024年、企業が抱えるデータの在り方はどう変わるか。市場トレンドの予測から考える、2024年のインフラ像を聞いた。

この記事は会員限定です。会員登録すると全てご覧いただけます。

「2024年、企業はデータをどのように再考するか」――。企業のデータを受け持つのはデータベースなどのアプリケーションミドルウェアか、ストレージか、はたまた別のITソリューションか。ハイブリッド/マルチクラウドを利用する中でAI時代に突入した企業ITインフラにおいて、散らばるデータをどう扱っていくべきだろうか。

ストレージベンダーが主張するのは、アーキテクチャの統一と「ちゃんと動く」を重視した構成だ。

AI時代にあってAIモデル構築よりも重要なものとは?

2024年も企業におけるAI利用のトレンドは継続する。その中でも、AIの扱い方に変化が出てきている。

ネットアップのCTOオフィス チーフテクノロジーエヴァンジェリストの神原豊彦氏が、2024年1月30日、メディア向けラウンドテーブルを開催、2024年の企業のデータの技術動向の予測と見解を説明した。

ネットアップは毎年、新年度に向けて米NetAppの有識者による市場予測や分析を公表している。今回の予測は、米NetAppチーフエヴァンジェリストのマット・ワッツ氏が2023年12月に公開したレポート「2024年、企業はデータをどのように再考するか」(原題:How businesses will rethink data in 2024)を基にしたものだ。

「AIモデルはデータに置き換えられる」

予測の1つ目は「AIの革新においてモデルはデータに置き換えられる」だ。

「生成AIが良い例だが、今までのAIの活用はベンダーが作ったAIモデル――例えば『ChatGPT』などの大規模言語モデル(LLM)――をいかに活用するかがテーマだった。しかし、2024年はそうした『AIモデルの活用』がデータの活用に置き換えられていくと見ている。与えられたAIモデルを使うのではなく、データを使って自分たちのAIモデルを作り出すアプローチへのシフトだ」(神原氏)

ベンダーが提供する既存のAIモデルだけは業務目的にそぐわない部分があるため、個々の企業にとって適切なデータに基づくAIの使い方が主流になるということだ。

実際、多くの企業が、AIモデルをカスタマイズしたりチューニングしたりして、業務に合ったAIを整備する動きが進んでいるという。

「われわれも社内ポータルサイトで技術文書の翻訳や記事の推敲(すいこう)、要約などで生成AIを活用している。ただし、社内限定のデータをそのまま使ってしまうと、機密情報もAIの学習に利用されてしまい、その内容が外部に漏れてしまうかもしれない。そこで、チューニングしながら既製のAIモデルを補うデータを用意して、業務目的に合わせて利用している。生成AIは自社データでファインチューニングをしないと使い物にならないとも言える。こうした事情からも(AIを最適化するための)データの重要性が高まっていくと考えている」(神原氏)

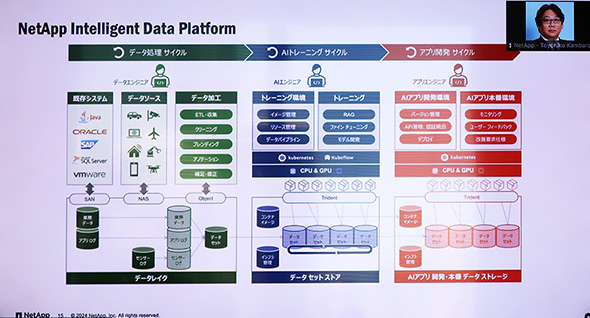

データパイプラインの整理とデータ管理、プライベート環境でのAIモデル活用がカギ

データが重要になれば、そのデータを統合的に管理する仕組みも必要になる。そこで、ネットアップはデータの収集から準備、学習、デプロイ、分析と階層化といったデータのパイプラインに注目し、データがどこにあっても簡単に取り扱えるようなAIプラットフォーム リファレンスアーキテクチャ「NetApp Data Pipeline」を提供している。

NetApp Data Pipelineは「データの流れ」にフォーカスしたアーキテクチャだ。ストレージのハードウェアだけでなくソフトウェアツールセットを提供することで、データの自由な移動をシンプルかつセキュアに実現するとしている。

これに加えて、ネットアップではプライベート環境で生成AIサービスを利用する仕組みも用意する。Googleと協力して提供する「Google Cloud NetApp Volumes with Vertex AI」、AWSと協力して提供する「FSx for ONTAP」がそれだ。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 知らない番号でも一瞬で正体判明? 警察庁推奨アプリの実力を検証

- 生成AIで消えるのは仕事、それとも新人枠? 800職種のデータから分かったこと

- Windows RDSにゼロデイ脆弱性 悪用コードが22万ドルで闇市場に流通

- もはやAIは内部脅威? 企業の73%が「最大リスク」と回答

- 政府職員向けAI基盤「源内」、18万人対象の実証開始 選定された国産LLMは?

- 「ExcelのためのChatGPT」ついに登場 GPT-5.4で実用レベルに?

- その事例、本当に出して大丈夫? “対策を見せたい欲”が招く逆効果

- 本職プログラマーから見た素人のバイブコーディングのリアル AIビジネス活用の現在地

- セキュアな開発を強力支援 OpenAIが新エージェント「Codex Security」を公開

- M365版「Cowork」登場 Anthropicとの連携が生んだ「新しい仕事の進め方」

ネットアップ CTOオフィス チーフテクノロジーエヴァンジェリストの神原豊彦氏

ネットアップ CTOオフィス チーフテクノロジーエヴァンジェリストの神原豊彦氏