Googleの人工知能「DQN」、アタリゲームで人間よりハイスコア叩き出す

米GoogleのDeepMindチームは2月25日(現地時間)、人工知能(AI)アルゴリズム「deep Q-network(DQN)」についての論文を発表した。DQNはゼロからゲームのルールを学習し、「Breakout」や「Pong」(ブロック崩し)などの「Atari 2600」の2次元ビデオゲームで最終的には人間よりハイスコアを獲得するまでに成長した。

DQNについての「Human-level control through deep reinforcement learning(深層強化学習による人間レベルの制御)」と題する論文が科学雑誌Natureのサイトに掲載された。

DQNは、米IBMのWatsonのようにビッグデータを解析した結果を提示するのではなく、ゼロから学習して進化していく人工エージェント。“ピクセルとゲームスコアを入力するだけで”ゲームに繰り返しトライしてマスターしていく。Atari 2600の49種類のゲームで実験したところ、29種類のゲームでプロのゲーマーより高得点だったという。

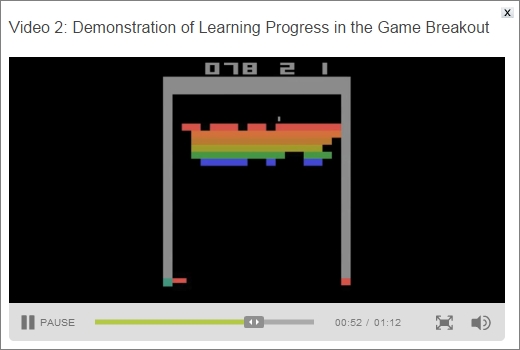

Breakoutでは、ブロックに開いた穴からボールを壁の後ろに送り、背面からブロックを崩すという手法を自ら編み出した(動画はNatureのページで観ることができる)。

Googleは、DQNはわずかなインプットに基いて様々なタスクに対応するよう訓練できる初の学習エージェントだと説明し、こうした技術は将来、さらに有用な製品の構築に役立つとしている。例えば、Googleのアプリに向かって音声で「OK Google、バックパックでの欧州旅行を計画して」といった複雑な命令を与え、実行させられる日が来るかもしれないという。

DeepMindは昨年1月にGoogleが買収した英国に拠点を置く人工知能企業。「機械学習とシステム神経科学の技術を使って強力な汎用学習アルゴリズムを構築する」というミッションを掲げている。

DQNをGoogle傘下のBostn Dynamicsが先日発表した犬型ロボット「Spot」や、プロトタイプをテスト中の自動運転カーに搭載したら面白いことになりそうだ。

関連記事

Boston Dynamics、足蹴にしても踏ん張る犬型ロボット「Spot」(動画あり)

Boston Dynamics、足蹴にしても踏ん張る犬型ロボット「Spot」(動画あり)

Google傘下のBoston Dynamicsが、体重が約73キロで階段の昇降やギャロップができる犬型ロボット「Spot」の動画をYouTubeで公開した。人と一緒にジョギングしたり、思い切り足蹴にしても踏ん張って体勢を立て直すシーンが紹介されている。 Googleの創業者コンビ、人工知能や自動運転カーを語る

Googleの創業者コンビ、人工知能や自動運転カーを語る

Googleのラリー・ペイジCEOとGoogle Xを統括するサーゲイ・ブリン氏がSun Microsystemsの共同創業者でベンチャーキャピタリストのビノド・コースラ氏とGoogleの様々な取り組みについて語った。 Googleのラリー・ペイジCEO、TEDで人工知能を語る

Googleのラリー・ペイジCEO、TEDで人工知能を語る

Googleのラリー・ペイジCEOがTED 2014に登壇し、買収した人工知能企業DEEPMINDの技術で取り組んでいることなどについて語った。 Google、人工知能企業DEEPMINDを買収

Google、人工知能企業DEEPMINDを買収

ロボット企業やスマートホーム企業を積極的に買収しているGoogleが、往年の天才ゲーム開発者で認知神経科学の博士号を持つデミス・ハサビス氏が立ち上げたAI企業を買収する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR