ひっそり成長「合成声優」ヒカリちゃん(21) 「声優さんの仕事を代替したい」――VoiceText開発者の挑戦(2/2 ページ)

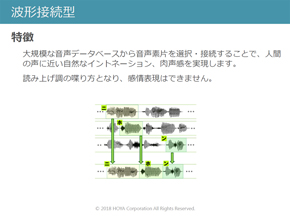

音声合成にはいくつか手法がある。同社が最初に採用したのは「波形接続型」と呼ばれるモデル。その名の通り、実際の声の波形を組み合わせて文章を読み上げるものだ。人の話し声の質感に近づけやすい一方、さまざまな文章にぴったり合う波形を用意する必要があるため、声の吹き込み(サンプリング)に数十時間を要するデメリットもある。

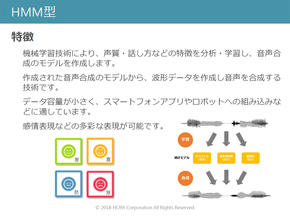

そこで2010年ごろに採用したのがHMM型(隠れマルコフモデル)という手法だ。

元となる音声から声質・話し方などの特徴を機械学習させ、音声合成のモデルを作成。そのモデルから文章に合う波形データを作成し、音声を合成する。録音した音声そのものをつなぎ合わせる波形接続型と異なり、計算によって音声を生み出すため、サンプリング時間を抑えられる。また、感情の高ぶった声、落ち着いた声の2通りを学習させることで、その間の細かい感情表現も可能になったという。

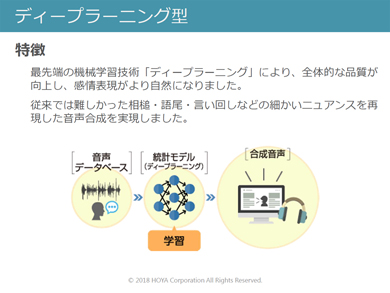

だが、言葉の抑揚や語尾のニュアンスなど、細かい表現が苦手な欠点もあった。そこで新たに導入したのが、ディープラーニングを用いた音声合成モデルだ。

従来のHMM型と違うのは、音声合成モデルの作成にディープニューラルネットワークを活用する点。言葉の抑揚など細かい特徴も学習させて音声合成モデルを作るため、より人間らしい自然な表現が可能になったという。その違いは、ディープラーニングを用いたヒカリと、HMM型のキャラのかけ合いを聞けばよく分かる。

※先に話し始めるのがHMM型の従来キャラ、後に話し始めるのがディープラーニング版のヒカリ

ディープラーニング版の先にあるもの 「WaveNet」の衝撃

だが2018年現在、ディープラーニング版でも「まだまだクオリティー面で不満がある」と金田さんは話す。

「音声合成の声優事務所を作った当時は、世の中の声優さんの仕事を音声合成で置き換えてやるぞという意気込みで始めたんですが、まだそこまで技術が追い付いていなくて……」。ディープラーニングによって音声合成モデル作成の精度は上がったものの、そのモデルを基に実際に音声を生み出すボコーダーに改善の余地があるという。

そんな金田さんたちが可能性を感じているのが「WaveNet」という技術だ。

WaveNetは、囲碁AI「AlphaGo」を生んだ米Google傘下の企業、DeepMindが開発した音声合成アルゴリズム。音声の要素を極限まで分解したものをディープラーニングによって学習し、点と点をつなぎ合わせるように自然な音声合成を実現する(関連記事:自然な音声作る「WaveNet」の衝撃 なぜ機械は人と話せるようになったのか)。

「WaveNetのボコーダーを使えば、人間の声と本当に遜色のないレベルの音声を生み出せる」と、金田さんと立花さんは声をそろえる。同社がWaveNetに準じた技術を採用するかどうかは「検討中」だが、「数年後には、(日本語の音声合成でも)人の声と聞き分けられないレベルまで到達する可能性が高い」と展望する。

「WaveNetは非常にクオリティーの高い音声を作れる反面、クラウド上の大量のコンピュータリソースで計算する必要がある。VoiceTextの強みは、音声読み上げのための処理が非常に軽いことと、声質の異なるキャラクターを簡単に展開できること。ただ、アナウンサーや声優の仕事を完全に代替できるレベルにするには、WaveNetのような仕組みが欠かせない。VoiceTextで今後同じような技術を採用する可能性もあると思う」(金田さん)

アナウンサー、声優の仕事はどう変わる?

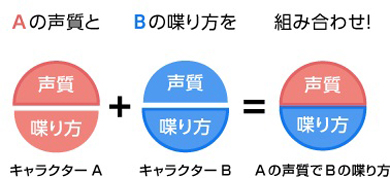

WaveNetのように膨大な計算を必要とする仕組み以外で、音声合成の用途を広げる取り組みもある。HOYAが最近開発を進めているのが「声質変換」という技術。これは、すでに作成済みの合成音声モデルに、別の声質を適用するものだ。

例えば、ヒカリの読み上げ方のモデルを使い、実在するタレントやアナウンサーの声質でしゃべらせる――といったことができる。新たにサンプリングするのは声質だけで済むため、好きな声の合成音声を簡単に生み出せるのがメリットだ。

※声質変換のデモ

「例えばニュース原稿の読み上げなどは平易な読み方が求められるため、声質変換で置き換えられる可能性も十分ある」と金田さん。では、感情を込めた話し方が求められる声優はどうか――。「WaveNetやそれに近しい技術を使えば、近い将来、代替できるのでは」というのが金田さんの見方だ。

「声優さんの仕事は多くが不安定で、アニメキャラなどの声に起用しても次回作までに廃業してしまうこともある。今から数年後には、声優さんの仕事を音声合成で違和感なく置き換えられるようになるのではないか。ただし、声質をゼロから生み出すのは難しく、モデルとなる声は必要。将来は声優さんの仕事も“声質のライセンスモデル”のような新しい形になるかもしれない」(金田さん)

人の仕事を代替するだけでなく、音声合成ならではの新しい用途が生まれる可能性もあるという。「例えばアニメキャラで、身長が高いけど声も高いという場合があるが、人の身体のつくりを考えると本来はあり得にくい。ただ、そうした人間には不可能な『全く新しいきれいな声』を生み出すことにも価値があるのでは」

ディープラーニングで成長を遂げたヒカリもまだまだ“発展途上”。あと数年後には、アニメのエンドロールに音声合成キャラクターの名前を見かけることも普通になる――かもしれない。

関連記事

自然な音声作る「WaveNet」の衝撃 なぜ機械は人と話せるようになったのか

自然な音声作る「WaveNet」の衝撃 なぜ機械は人と話せるようになったのか

流ちょうな日本語を発声するスマートスピーカー。「こんな音声合成ができるにはあと10年かかると思っていた」と研究者は衝撃を受けている。これを実現したWaveNetとは何か。スマートスピーカーを作る技術がどんなものかを研究者に聞く。 音声合成はアナウンサーや声優の仕事を奪うのか?

音声合成はアナウンサーや声優の仕事を奪うのか?

「AIアナウンサー」など、コンピュータが人間の代わりに音声の読み上げを務める機会が増えている。音声合成はどこまで人間のようにしゃべることができるのか。 「声を自由に変えられる技術」でコミュニケーションはどう変わる?

「声を自由に変えられる技術」でコミュニケーションはどう変わる?

特定の他人の声になれる、音声変換技術はコミュニケーションにどのような影響を及ぼすのか。 実在の声優事務所に“合成音声キャラ”が正式所属 きっかけは? 開発元に聞く

実在の声優事務所に“合成音声キャラ”が正式所属 きっかけは? 開発元に聞く

カプコンのゲームに登場する合成音声キャラクター「ツクモ」が、声優事務所「響」に所属。きっかけと狙いを聞いた。 プロ声優を起用した音声合成用データ、無償公開 研究用途に期待

プロ声優を起用した音声合成用データ、無償公開 研究用途に期待

プロの声優が発声した、音声合成ソフトの作成や言語研究などに使われるデータを公開。 バーチャル女子アナ「沢村碧」、ソニーが提供開始 原稿を自動読み上げ

バーチャル女子アナ「沢村碧」、ソニーが提供開始 原稿を自動読み上げ

バーチャルアナウンサーが原稿を読み上げる「アバターエージェントサービス」を、ソニーが提供開始。入力した原稿を音声へ自動変換するCGキャラクターだ。【訂正】

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR

HOYAの立花綱治さん(HOYA SPEECH 技術グループ チームリーダー)

HOYAの立花綱治さん(HOYA SPEECH 技術グループ チームリーダー)