ITmedia NEWS >

AI+ >

深層学習でリップシンク動画生成 SiriやAlexaにも対応する「Neural Voice Puppetry」:Innovative Tech

» 2020年01月17日 09時00分 公開

[山下裕毅,ITmedia]

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

ミュンヘン工科大学と独Max Planck Institute for Informatics(MPII)の研究チームが2019年12月に発表した「Neural Voice Puppetry」は、任意の音声を入力を元に、その音声に合わせた写実的な顔のアニメーションを生成する深層学習を用いた手法だ。

この手法を用いると、指定する顔の口元を操り人形のように音声駆動でアイデンティティを保持しながら動かせる。また、テキストを変換した音声合成からも生成できるため、Siri、Alexa、Google Assistantなどのデジタルアシスタントの音声も顔アニメーションに変換可能だ。

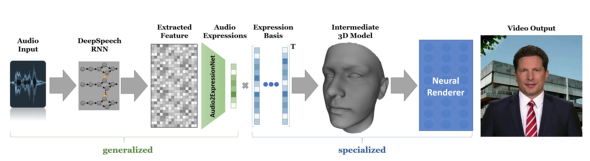

パイプラインは、2つの主要部分で構成される。

音声入力からDeepSpeech RNNを用い、ブレンドシェイプで顔の3Dモデルを駆動する基礎係数を予測。

予測した基礎係数を基に、ターゲットの顔モデルをレンダリングするための最適化を行い出力する。

指定する顔が動く2〜3分の短いビデオがあれば訓練可能で、インターネット上の短いビデオも利用できるのが特徴。

活用例として、遠隔会議で自分のキャラクターを表示してしゃべらせる、デジタルアシスタントの上半身をプロジェクター等で投影し動かす、動画制作で有名人に話をさせる――などが挙げられる。

関連記事

漫画キャラのせりふを、感情のこもった音声合成に変換 北京理工大学などが新技術

漫画キャラのせりふを、感情のこもった音声合成に変換 北京理工大学などが新技術

漫画に登場するキャラクターのせりふから感情の状態を抜き出し、それに合わせた音声を生成する技術が開発された。 NVIDIA、1枚の静止画で動きを合成 GANを用いた手法を開発 ダビデ像も踊り出す

NVIDIA、1枚の静止画で動きを合成 GANを用いた手法を開発 ダビデ像も踊り出す

ダビデは踊り、モナリザは表情を変える。 AirPodsでヒソヒソ音声入力 口を手で押さえるジェスチャーで 清華大学など発表

AirPodsでヒソヒソ音声入力 口を手で押さえるジェスチャーで 清華大学など発表

直感的なジェスチャーでひそひそ音声入力を起動できる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR