ITmedia NEWS >

AI+ >

人の動画を別人の動きに 深層学習でリアルに操作:Innovative Tech

» 2020年02月13日 07時30分 公開

[山下裕毅,ITmedia]

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

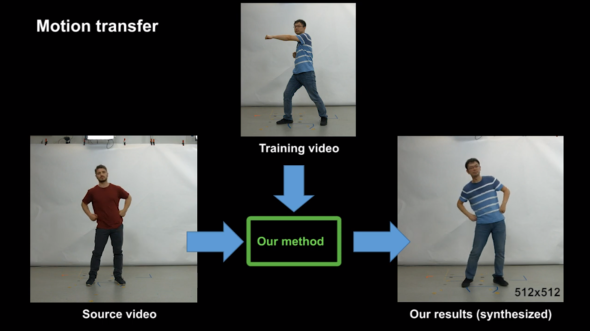

独Max Planck Institute for Informatics、香港大学、スタンフォード大学による研究チームが2020年1月に発表した「Neural Human Video Rendering」は、 Convolutional Neural Network(CNN)を用い、動画内の衣服を着た人物の全身運動を制御する合成技術だ。

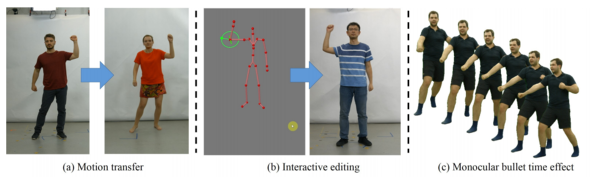

研究チームは3種類のユースケースを紹介している。

- (a) ドライバー動画(操る側)の動きをターゲット動画(操られる側)へ転送するアプローチ。ターゲット動画内の人物を、外見を保持しながらドライバー動画内の人物の動きと同じように動かせる。

- (b) 人型スケルトンを動かし制御するアプローチ。モデルをインタラクティブに動かし、ターゲット動画内の人物を同じように動かせる。

- (c)単一カメラの固定ビューからBullet-time効果を生成するアプローチ。さまざまな角度から見た特定のポーズを生成できる。

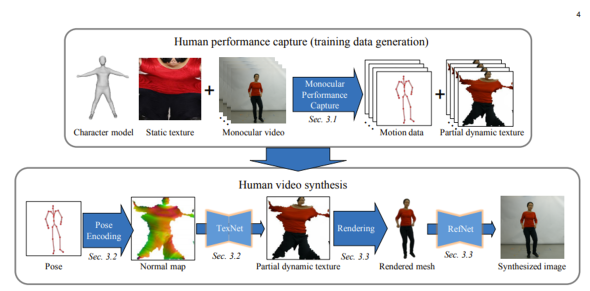

本技術は、1台の単眼カメラで撮影した動画から学習して、スケルトンを入力とした人物のリアルな映像を生成するデータ駆動型のアプローチだ。

事前トレーニングでは、静的な人型3Dモデルとテクスチャ、動画から人物の動きを訓練する。出力はモーションデータとフレーム毎の部分的な動的テクスチャ。合成ステップでは、テクスチャマップを計算するためのネットワーク(TexNet)と、前景と背景を自然にブレンドし、シルエットで見られるトラッキング/スキニングエラーを修正した最終出力を生成するネットワーク(RefNet)の2段階で構成される。

このような合成技術では、転送後の動画で体の一部や衣服のシワが欠落するといった課題があった。本技術はこの課題を軽減している。

関連記事

カメラ映像から複数人の動きを骨格・筋レベルで同時検出 東大とドコモがモーションキャプチャ技術発表

カメラ映像から複数人の動きを骨格・筋レベルで同時検出 東大とドコモがモーションキャプチャ技術発表

動きの激しい、多人数がプレイするスポーツでモーションキャプチャが可能な技術が開発された。 NVIDIA、1枚の静止画で動きを合成 GANを用いた手法を開発 ダビデ像も踊り出す

NVIDIA、1枚の静止画で動きを合成 GANを用いた手法を開発 ダビデ像も踊り出す

ダビデは踊り、モナリザは表情を変える。 Google、全身キャプチャと深層学習で3Dアバター生成 任意のシーン、照明に合わせレンダリング可能

Google、全身キャプチャと深層学習で3Dアバター生成 任意のシーン、照明に合わせレンダリング可能

既存の全身キャプチャシステムを改良し、ディープラーニング技術を投入することで、フォトリアリスティックな3Dアバターを実現する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR