GPT-4やLlama 2の透明性をスタンフォード大HAIが評価 トップはMetaでOpenAIは3位

米スタンフォード大学Human-Centered AI Institute(HAI)は10月18日(現地時間)、AIの基盤モデルを公開している10社の透明性を評価するスコアリングシステム「Foundation Model Transparency Index」(FMTI)を公開した。

基盤モデルとは一般に、教師なし学習で大量の生データでトレーニングされたAIニューラルネットワークを指す。例えば米OpenAIのGPT-4や、米Googleの「PaLM 2」などで、それぞれChatGPTやBardを介して一般人も利用している。

HAIの基盤モデル研究センター(CRFM)のリシ・ボンマサニ氏は、基盤モデル分野の企業の透明性が低下していると警鐘を鳴らし、FMTIは透明性評価のために設計したと語った。

システムは、基盤モデルの構築方法、機能方法、ユーザーにどのような形で使われるかなど、透明性に関する100の側面を評価する。

評価対象はMetaなど10社。このうち9社はAIによってもたらされるリスクを管理する意向を米連邦政府に約束している。

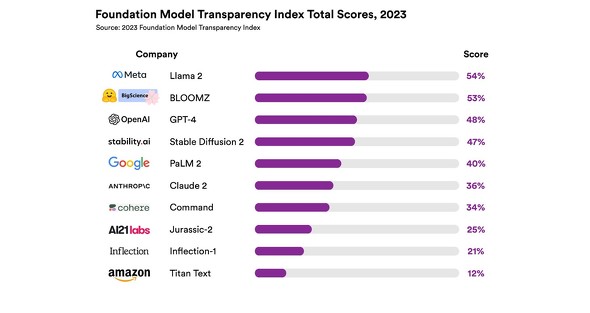

評価の結果、透明性が最も高いのは米MetaのLlama 2でスコアは54%、2位はオープンなワークショップBigScienceのBLOOMZで53%。OpenAIのCPT-4は3位(48%)、GoogleのPaLM 2は5位(40%)、米AnthropicのClaude 2は6位(36%)だった。最下位は米AmazonのTitan Textで12%。

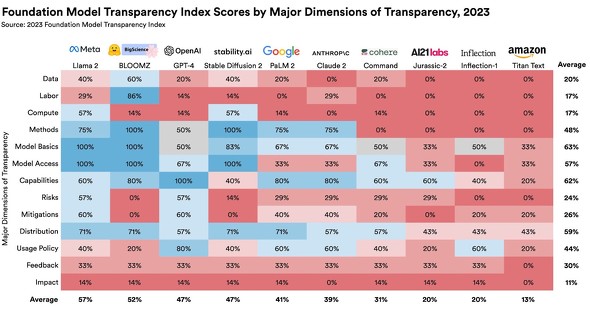

インデックスの内訳は、トレーニグデータなど基盤モデルの構築方法に関連するものが3分の1、モデルの機能、信頼性、リスクなど、モデル自体に関するものが3分の1、モデルの配布、ユーザー データ保護、モデルの動作に関する企業ポリシーの開示、影響を受ける個人によるフィードバックや救済の機会を企業が提供するかどうかなどに関するものが3分の1。

CRFMは、透明性の欠如は長い間問題になっていると指摘する。商業基盤モデルの透明性は、AI政策の推進から一般ユーザーによる活用までのために重要だとしている。

FMTIはこちらで、100のインデックスはこちらで確認できる。

関連記事

OpenAIやMetaなどAI大手7社、米連邦政府に「責任あるAI開発」を“自主的に”約束

OpenAIやMetaなどAI大手7社、米連邦政府に「責任あるAI開発」を“自主的に”約束

米連邦政府はAIを手掛ける7社の代表をホワイトハウスに招集し、AIの安全性、セキュリティ、透明性の高い開発に向けた取り組みを支援するため、これらの企業から自主的な取り組みを確保したと発表した。 OpenAI、「AI の安全性に対する当社のアプローチ」を説明 「年齢確認オプション検討中」

OpenAI、「AI の安全性に対する当社のアプローチ」を説明 「年齢確認オプション検討中」

OpenAIが「AIの安全性に対する当社のアプローチ」を説明した。「GPT-4より強力なAIの開発を直ちに停止せよ」という署名運動などを受けたものとみられる。「悪用する方法をすべて予測することはできない」が新しいシステムのリリースは慎重に行っていると主張する。 AI開発停止要求署名は無意味、透明性と説明責任の改善を──Hugging Faceのルッチョーニ博士

AI開発停止要求署名は無意味、透明性と説明責任の改善を──Hugging Faceのルッチョーニ博士

イーロン・マスク氏などが署名した「GPT-4より強力なシステム開発を停止せよ」という公開書簡について、AI研究者が「非現実的で不必要」と評した。それよりもガイドラインを作成し、透明性と説明責任を改善すべきだと主張する。 スタンフォード大のフェイ・フェイ・リー博士、人間中心AIラボ「HAI」立ち上げ

スタンフォード大のフェイ・フェイ・リー博士、人間中心AIラボ「HAI」立ち上げ

Google Cloud AIのチーフサイエンティストの経験も持つスタンフォード大学のフェイ・フェイ・リー教授が、人間中心のAI研究所「Human-Centered AI Institute(HAI)」を立ち上げた。AIが人間社会に与える影響と可能性を研究し全人類にとってのよりよいAIを目指す。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR