オフライン、オンプレミスでの独自LLM開発を1ケタ安く ELYZAがLLM開発支援プログラムを開始

言語生成AIのスタートアップが企業独自のLLM開発支援プログラムを立ち上げた。AI専門チームならではの精度向上のノウハウや開発基盤を提供するとしている。

この記事は会員限定です。会員登録すると全てご覧いただけます。

ChatGPTの登場以来、国内外の多数の企業が企業向けのLLM開発支援に手を挙げている。ディープラーニングの第一人者でもある東京大学 松尾 豊氏の研究室から生まれたAI系のスタートアップ企業であるELYZAも、企業が独自の大規模言語モデル(以下、LLM)を構築するための支援プログラム「独自LLM開発支援プログラム」の提供を開始する。

企業独自のLLM開発のコストを1ケタ安く

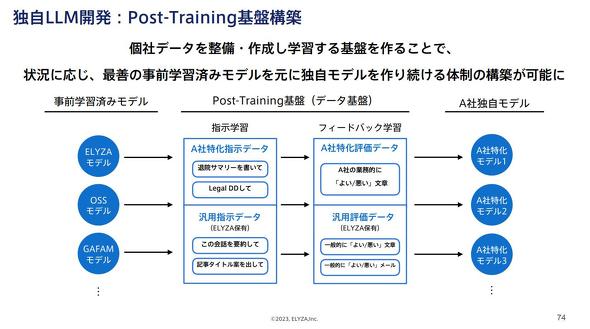

独自LLM開発支援プログラムは、事前学習(Pre-Training)のプロセスを効率化しつつ、精度向上のカギを握る事後学習(Post-Training)については専用の基盤を構築して企業ごとのチューニングと運用を効率化するものだ。学習データの継続的な整備やフィードバック学習の運用も支援する。

ELYZAは、Pre-Trainingを効率化することで、独自のLLM開発にかかる費用を1ケタ安く提供できるとしている。

精度向上の鍵を握るPost-Trainingのノウハウを提供

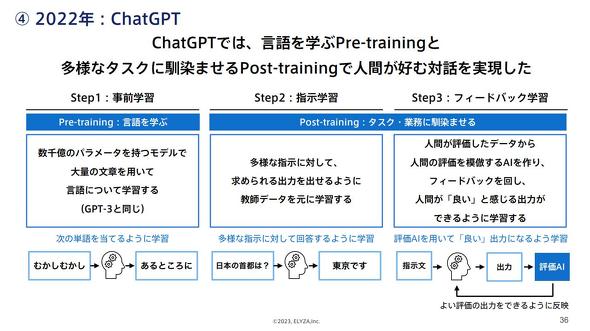

ChatGPTのようなLLMモデルは、汎用(はんよう)的な言語学習フェーズ(Pre-Training)と専門知識を伴う情報を学習するフェーズ(Post-Training)がある。同じLLMモデルでも、Post-Trainingの品質次第でLLMの精度を向上させられることが分かっている。

汎用のLLMモデルはオープンソースソフトウェアで開発されているものも多く、今後さらに増えることが予想される。そこで、ELYZAはPre-Trainingは既存のLLMを採用し、個社の事情を加味したPre-Trainingの学習データの精度向上に注力するアプローチを取る。

Post-Trainingによって出力の精度を向上させるには、人間が言語生成AIに対して提示した要求や指示に関するデータを学習させる必要がある。Post-Trainingでは、この学習データの多様性と総量を確保できる環境が重要になる。集積したデータをPost-trainingに利用できる形式に加工する技術と知見も必要だ。

ELYZAは、2022年11月からPost-Trainingの研究を強化し、独自のPost-Training基盤を構築している。また開発したAIモデルを実装するための基盤環境も持つため、独自LLMの成果検証を素早く実現できるとしている。

これに加えて、実際に人間が入力することでしか得られない学習用データを収集するためのチャット形式のアプリケーション基盤も保有する。

同社はChatGPTの利便性には一定の評価をしており、企業のDX推進には有効としている。一方で、企業利用においては自社固有の業務に特化した利用を求める声が強く、汎用のモデルではなく自社業務に特化したチューニングが施された応答性能の高いAIモデルへのニーズが強い。また、情報セキュリティの観点からはオンプレミスでの利用を望む声もある。

同社では、特に次のような事業ドメインにおいては独自LLMの開発が有効だとしている。

- 金融や法務といった個人情報などのセンシティブな情報を扱っており、情報漏えいが高いリスクとなるため、オンプレミスにデータを置く必要がある事業ドメイン

- 産業機械や自動車製造など、インターネット接続が不可能なエッジ環境でLLM利用を想定する事業ドメイン

- 製薬や医療、金融などの専門用語が多く高い専門性が求められる事業ドメイン

関連記事

「3年で日本語の自然言語処理がどこまで進化したかを知ってほしい」ELYZA DIGEST開発企業に聞く

「3年で日本語の自然言語処理がどこまで進化したかを知ってほしい」ELYZA DIGEST開発企業に聞く

「人間を超える正確性を獲得した」とする日本語要約エンジンが話題だ。言語処理の技術的なブレークスルーとされる「BERT」の技術をベースにしているというが、その精度や実務での可能性はどのくらいあるだろうか。 技術資産の持ち腐れはなぜ発生するか R&D部門のアナログ業務にメスを入れるAIスタートアップが登場

技術資産の持ち腐れはなぜ発生するか R&D部門のアナログ業務にメスを入れるAIスタートアップが登場

大ヒット製品のコア技術が実はその他市場での新しい商品開発に活用できていない、他チームが開発した技術と連携できておらずに市場ローンチに時間が掛かっているなど、笑えない機会損失はなぜ起こるのか。R&D部門のサイロ化を解消するAIサービスを提案する企業に話を聞いた。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 知らない番号でも一瞬で正体判明? 警察庁推奨アプリの実力を検証

- 生成AIで消えるのは仕事、それとも新人枠? 800職種のデータから分かったこと

- Windows RDSにゼロデイ脆弱性 悪用コードが22万ドルで闇市場に流通

- もはやAIは内部脅威? 企業の73%が「最大リスク」と回答

- 政府職員向けAI基盤「源内」、18万人対象の実証開始 選定された国産LLMは?

- ZIPファイルの“ちょっとした細工”で検知停止 EDRも見逃す可能性

- M365版「Cowork」登場 Anthropicとの連携が生んだ「新しい仕事の進め方」

- 「ExcelのためのChatGPT」ついに登場 GPT-5.4で実用レベルに?

- その事例、本当に出して大丈夫? “対策を見せたい欲”が招く逆効果

- 本職プログラマーから見た素人のバイブコーディングのリアル AIビジネス活用の現在地