ディープフェイク悪用の実態 攻撃/防御側の研究成果をひもとく:AI×セキュリティの関係を考える

近年、顔映像や音声を加工するディープフェイクを悪用する事例が注目を集めている。この分野は今どのような発展を遂げているのか。研究成果が明らかになった。

この記事は会員限定です。会員登録すると全てご覧いただけます。

情報処理学会(以下、ipsj)は2023年6月27日、オンラインイベント「AIセキュリティ−インフォデミックから人々を守る−」を開催した。同イベントは「人とAIが共生する社会に向けた情報技術」をテーマに、全12回にわたり、開催される連続型セミナーの第2回だ。

前回はAI(人工知能)開発におけるセキュリティリスクを紹介した。今回は国立情報学研究所の越前 功氏(情報社会相関研究系 教授)の講演「インフォデミック時代におけるフェイクメディア克服の最前線」の内容から、ディープフェイクをはじめとした悪用が進むAI技術の動向を見ていこう。

顔を対象にしたAI技術最前線 フェイク映像の作成は簡単だ

インフォデミックとはSNSで不確かな情報を拡散して社会に不安や恐怖、混乱を引き起こすことだ。コロナ禍では新型コロナウイルス感染症(COVID-19)に関連したデマや臆測、陰謀論などが飛び交った。最近ではウクライナ侵攻に関連したインフォデミックも発生している。

インフォデミックを引き起こすために、愉快犯や攻撃者が利用しているのが「フェイクメディア」だ。フェイクメディアには複数の分類があるが(後述)、世論の誘導などを目的とし、映像や音声に意図的な加工を施すことを指す。AIを使って元データと異なるものを作成するディープフェイクもその一つだ。その中でも本稿は、顔を対象にしたフェイクメディアの生成について解説する。

越前氏ははじめに以下の3枚の顔写真を見せた。同氏によると、これら全ての写真がAIによって生成されたものだという。

「以前までは髪の生え際や首の周辺に違和感があった。しかし今は、髪の毛の一本一本や肌の質感などが非常に緻密に再現されており、パッと見で本物かどうかの判別を付けるのが難しくなってきている」(越前氏)

越前氏によると、このような顔や音声、身体、自然言語など人間の情報をAIが生成する技術は2019年ごろから発達してきた。技術の進化に伴い、フェイク音声で企業の幹部になりすまして現金を窃取したり、実在/架空の人物になりすまして株価を操作したりする事例も発生している。

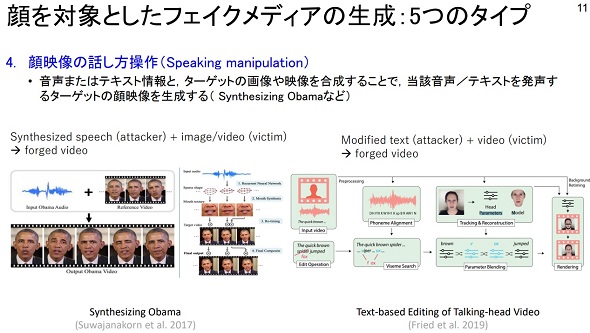

越前氏によると、顔を対象にしたAIによるフェイク生成には「顔全体の合成」「顔の属性操作」「顔映像の表情操作」「顔映像の話し方操作」「顔の入れ替え」といった5つのパターンがある。

顔全体の合成は、現実世界に存在しない顔画像を「StyleGAN」や「Stable Diffusion」のような画像生成AIで作成する技術で、顔の属性操作は画像生成モデル「StarGAN」などを使用してターゲットの顔画像の髪や肌の色、表情を変えることを指す。

「近年、顔全体の合成は非常に発展しており、著名人の顔画像を用いて『Stable Diffusion』をチューニングすることで、著名人の顔を含む任意の画像を生成することも簡単にできてしまう」(越前氏)

顔映像の表情操作は、サイバー攻撃者の表情とターゲットの顔画像や映像を合成し、攻撃者の表情とリアルタイムで同期させる技術だ。これを悪用すればあたかも特定の人物が話しているかのように見せかけることが可能になる。これをさらに発展させたのが、顔映像の話し方操作で、音声・テキスト情報とターゲットの顔映像を合成することで、任意のテキストを発声するターゲットの顔映像を生成できるようになる。

顔の入れ替えは映像の顔部分だけをターゲットの顔と入れ替える技術だ。近年は「FaceSwap」のように動画や画像の顔を入れ替えるフリーのソフトウェアも出回っている。

フェイクメディア検出の最前線 研究成果に迫る

先に挙げた技術を組み合わせてフェイクメディアを生成すれば、攻撃者はインフォデミックを引き起こすことが可能になる。では防御側としてはどのような対策を講じているのだろうか。次に、越前氏を研究代表者とする研究プロジェクトCREST FakeMediaの研究成果について解説しよう。

CREST FakeMediaは3種類のフェイクメディアを想定し、研究に取り組んでいる。

1つ目のフェイクメディアは「メディアクローン(MC)型」だ。MC型は上述したような、いわゆるディープフェイクを利用して生成された本物に限りなく近いが偽物の映像や画像、音声のことだ。2つ目は「プロバガンダ(PG)型」で、世論操作などを目的として素材となる動画といったメディアを意図的に編集して生成される。3つ目は「敵対的サンプル(AE)型」で、人間には識別できないが、AIを誤作動や誤判定させることを目的とする。

「近年は特に、MC型フェイクメディアの脅威が現実味を帯びてきている。国内では機械学習(ML)で生成および配布したサンプル顔画像を、企業が自社の宣伝に不正利用したり、2021年には加藤勝信官房長官の記者会見映像が改ざんされたりする事件が発生している」(越前氏)

CREST FakeMediaはこれらの脅威に対して「高度なフェイクメディア生成技術」「高度なフェイクメディア検出・防御技術」「フェイクメディア無毒化技術」「意思決定支援技術」といったソーシャル情報基盤技術の研究に力を入れている。

例えばフェイクメディア無毒化技術の研究としては、保護したい顔映像にサイバーワクチンを接種しておくことで、顔の入れ替えなどの攻撃を受けても、フェイクの顔画像の周辺から復元情報を取り出して、オリジナルの顔画像を復元する取り組みを進めている。

その他、2021年9月にはAIaaS(AI as a Service)である「SYNTHETIQ VISION」も開発した。これはディープフェイク映像の真偽を判定する一連のプロセスをAPIとして提供するものだ。SYNTHETIQ VISIONの判定方法は、人間による分析を一切必要とせず、大量のデータに基づいて自動で識別する。越前氏によると、サイバーエージェントなどが同サービスを有償ライセンス契約しているという。

こうした研究が進むフェイクメディア検出だが課題もある。SNS共有や再配信のタイミングで画像・映像にリサイズ、再圧縮といったノイズが生じるため、品質が劣化し真偽判定の精度が低下することもある。その他、フェイクメディア検出で用いる機械学習モデルは未知の手法で生成されたフェイクメディアを高精度で検出できないため、定期的な学習データのアップデートが必要になってくるだろう。

関連記事

AIを狙ったサイバー攻撃の知られざる世界 専門知識なしでどう対処するか?

AIを狙ったサイバー攻撃の知られざる世界 専門知識なしでどう対処するか?

生成AIブームが訪れ、各企業がAI開発に乗り出しているが、AI開発プロセスには脆弱性が潜んでおり、これを悪用することでサイバー攻撃が可能になることは意外と知られていない。攻撃の詳細とそれを防御するための方法を解説する。 生成AIをどうサイバー防御に生かすか 有効策をセキュリティ専門家が提言

生成AIをどうサイバー防御に生かすか 有効策をセキュリティ専門家が提言

生成AIは技術的な革新であり、多くの企業が有効に活用する方法を模索している。セキュリティにおいてもそれは同様だ。攻撃・防御側それぞれでどのような使い方が考えられるか。 ビジネス向け生成AI開発最前線、日本IBMが仕掛けるアプローチ

ビジネス向け生成AI開発最前線、日本IBMが仕掛けるアプローチ

「ChatGPT」の登場で急速に進む生成AIブーム。企業が自社のビジネスに特化した生成AIを開発するためにはどうすればいいのか。AI開発の歴史を振り返りつつ最適なアプローチを日本IBMが推奨した。 経営者とセキュリティ担当者が分かり合うためのフレームワークを知っているか?

経営者とセキュリティ担当者が分かり合うためのフレームワークを知っているか?

ランサムウェア攻撃が高度化する今、全社一丸となってセキュリティ対策を講じるには、経営層から現場のセキュリティ担当者までが同じ言葉で語り合い、足並みをそろえる必要がある。これを実現するフレームワークを解説しよう。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- なぜ日本のITエンジニアは優遇されない? 「世界給与ランキング」から見えた課題

- 新たな基準になる? NSA、ゼロトラスト実装指針「ZIGs」のフェーズ1・2を公開

- 長期記憶で能力を進化 Googleらが脆弱性解析を自動実行するLLMを提案

- 「年齢で落とされる」は6割超 シニアエンジニアが直面する採用の壁と本音

- 3800超のWordPressサイトを改ざん 大規模マルウェア配布基盤が82カ国で暗躍

- なぜアスクルのランサム被害は長期化した? 報告書から見えたレジリエンスの穴

- Active Directoryの心臓部を狙うNTDS.dit窃取攻撃の全貌とは?

- Gartner、2026年のセキュリティトレンドを発表 6つの変化にどう対応する?

- 2027年に35%の国は「地域特化AI」でロックイン AI主権の確立が進む

- 中国電力、RAGの限界に直面し“電力業務特化型LLM”の構築を開始 国産LLMを基盤に

国立情報学研究所の越前 功氏

国立情報学研究所の越前 功氏