Google、プライバシー保護と性能の両立目指すLLM「VaultGemma」発表:AIニュースピックアップ

Googleが、ユーザーのプライバシー保護とLLMの性能を両立させたAIモデル「VaultGemma」を公開した。その性能や課題を紹介する。

この記事は会員限定です。会員登録すると全てご覧いただけます。

Googleは2025年9月12日(米国時間)、プライバシーの保護に特化した大規模言語モデル(LLM)「VaultGemma」を開発したと発表した。

従来のLLMには、訓練データに含まれるプライバシー情報を記憶し、意図せず漏えいさせるリスクがある。VaultGemmaは、個別の学習データの詳細を記憶せずに、プライバシーを守りながら高性能な出力が可能な点が特徴だ。

ユーザーのプライバシー保護を実現したLLM その仕組みと性能、課題とは

VaultGemmaに利用されている中核技術が「差分プライバシー」(DP)だ。DPは、個人情報を含むデータに意図的なノイズデータを加えることで、データ全体の統計情報から特定の個人を識別できないようにする技術だ。VaultGemmaは、GoogleのオープンソースのAIモデル「Gemma」をベースに差分プライバシーを適用して訓練されたモデルを基盤としており、パラメータ数は10億(1B)。

しかし、VaultGemmaには課題もある。

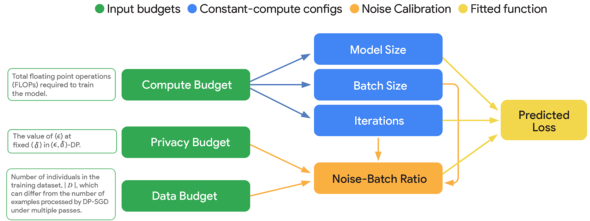

DPをLLMの学習に適用すると、LLMの性能や精度が低下しやすくなったり、計算コストが増加したりする。VaultGemmaの研究チームは、この問題を解消するため、計算量、データ量、プライバシー強度のバランスからLLMの最良の性能を引き出すための理論的な枠組み「DPスケーリング則」を確立した。

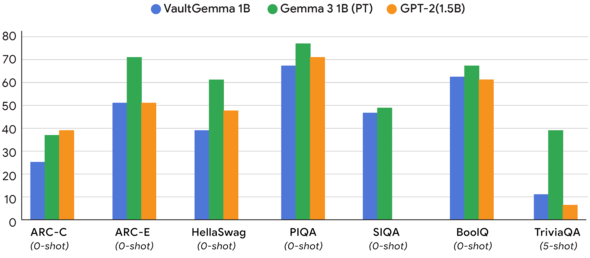

性能評価はどうか。VaultGemmaとGemmaモデルを比較した結果をGoogleは公開している。「Gemma 3」(パラメータ数1B)やOpenAIの言語モデル「GPT-2」(パラメータ数1.5B)と比較した結果、VaultGemmaはGemma 3には及ばないものの、2019年に公開されたGPT-2に匹敵する性能を示している。

VaultGemmaは、モデルの重みを公開した「オープンウェイトモデル」であり、誰でも利用できる。モデルの重みは「Hugging Face」と「Kaggle」で公開されている。

関連記事

トレンドは生成AIから「ソブリンAI」へ Gartner、行政サービスのハイプ・サイクル2025を発表

トレンドは生成AIから「ソブリンAI」へ Gartner、行政サービスのハイプ・サイクル2025を発表

Gartnerは2025年の行政サービスのハイプ・サイクルにおいて、ソブリンAIとAIエージェントを中核技術と位置付けた。各国政府がテクノロジー主権や市民対応の自動化を推進する中、日本でも導入が進むと予測される。 OpenAIがMicrosoftと提携強化 非営利組織による再資本化の狙い

OpenAIがMicrosoftと提携強化 非営利組織による再資本化の狙い

OpenAIはMicrosoftとの新たな提携段階として覚書に署名し、非営利組織が公益目的会社(PBC)を支配する体制で再資本化する計画を発表した。AIの安全性と公共利益の両立を目指す体制を構築する。 エージェント型AI導入、26年に25%に拡大見込み 経営層が挙げる導入のメリット

エージェント型AI導入、26年に25%に拡大見込み 経営層が挙げる導入のメリット

IBMはAIエージェントに関する日本企業の導入状況と将来展望を調査し、現在3%の導入率が2026年には25%へ拡大すると予測している。経営層はAIを業務の中核と位置付け、業務効率や財務成果への寄与を期待している。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 悪いのは本当にVPN? 日本医科大武蔵小杉病院のランサムウェア事件をダークWebから解明

- SMBC日興証券が「パスキー」で口座乗っ取り対策 約5カ月で実現したのはなぜ?

- アサヒGHDがランサムウェア被害の調査報告書を公開 152万の個人情報が漏えいの恐れ

- 関西電力が「AIファースト企業」化に本気 脱JTCを図る背景と全従業員“AI武装化”の全貌

- 日本IBMのAI戦略“3つの柱” 「制御できるAI」でレガシー資産をモダナイズ

- 生成AIの記憶機能を悪用して特定企業を優遇 50件超の事例を確認

- 東海大学、ランサムウェア被害を報告 19万人超の個人情報が漏えい

- 保守の「脱・人月ビジネス」化は進むか それでも残る仕事は何か

- 初期侵入口は“またVPN” 日本医大武蔵小杉病院にランサムウェア攻撃

- そのセキュリティ業務、自前と外注のどちらが正解? 勘に頼らない判断のこつ