ITmedia NEWS >

AI+ >

「一時停止」は「進め」? AIを騙す近未来:連載:ITの過去から紡ぐIoTセキュリティ(2/3 ページ)

» 2018年11月22日 07時00分 公開

[高橋睦美,ITmedia]

セキュリティベンダーの側もそのことを認識し、リサーチに取り組み始めています。米McAfeeは、10月に米国で開催した年次カンファレンスの場で、AIの力を借りた「人とマシンの共同作業」の重要性を訴えましたが、同時に「敵(攻撃者)がAIを使えばどうなるか」についても展示会場で検証していました。

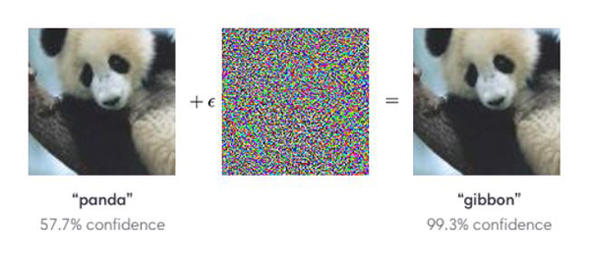

展示されていた例は2つありました。1つは、多くの特徴点を抽出することを逆手に取って、悪意あるファイルが検出エンジンをすり抜けるというもの。もう1つは、イメージデータにノイズデータを加えることで画像認識エンジンに誤認識を引き起こさせるもので、いずれも昨年から盛んに議論されている手法です(参考:Attacking Machine Learning with Adversarial Examples)。

デモンストレーションでは、オリジナルの画像に特定のノイズを加えると、人が見れば一目で違いに気が付くのに、画像認識エンジンには同一のものとして認識させたり、全く違う意味を持つ画像として認識・処理させたり、といっただましのテクニックを紹介していました。将来、自動運転が現実のものとなったとき、「一時停止」の標識を「進め」とクルマに誤認識させてしまうといった悪用のシナリオも考えられるといいます。

ブースの担当者は「AIはとてもスマートだし、高速な処理を可能にしてくれるが、脆弱なところもある」と述べ、学習データを慎重にインプットするだけでなく、サンプルの適切な分類や特徴点の偏りを補正する方法も含め、こうした脆弱性に強いAIの開発を進めていきたいと説明していました。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR