Google、実写の3D映像を記録する46台のカメラシステムを開発:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Googleの研究チームが開発した「Immersive Light Field Video with a Layered Mesh Representation」は、実写の3D映像を撮影できる46台のカメラを配置したライトフィールドカメラシステムだ。VR/ARシステムでストリーミング再生可能な6自由度(6DoF)の立体映像を作成する。

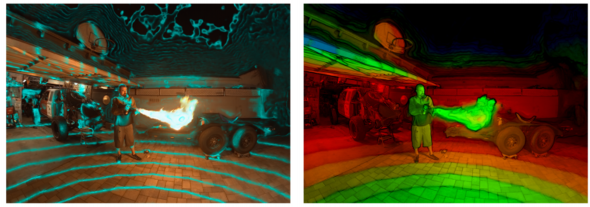

ここで言う実写の3D映像とは、平面による360度映像ではなく、頭を動かすことで視点と遠近感が変化し、運動視差による奥行き感や、光の反射によってシーンがどのように構成されているかをより実感できる立体的な映像を指す。

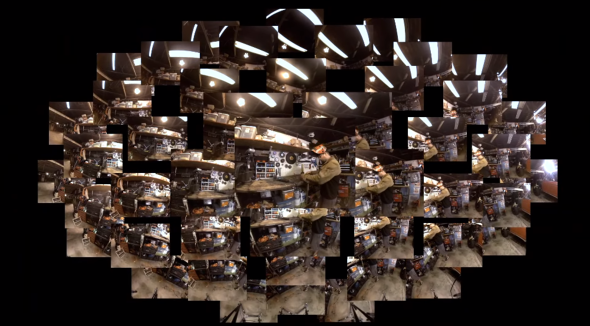

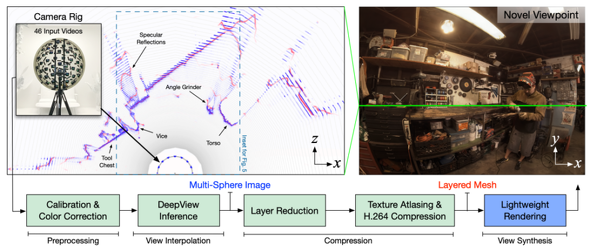

この3D映像を作り出すには、撮影する機材と、映像の圧縮やレンダリングなどを処理するシステムを必要とする。撮影機材は、直径92cmの半球ドームの20面体の頂点に取り付けた46台のアクションカム(カメラ間の平均間隔は18cm)からなるアレイを用い、全て同期させて使用する。 記録する視野角は220度以上。

46台のカメラで撮影された画像は、キャリブレーションと色補正を施した後、 Multi-sphere image (MSI)を生成するために、訓練済み深層学習ベースのDeepViewネットワークにで処理する。

ただし、生成されるMSIはデータ量が1フレームあたり100枚以上の高解像度RGBA(RGB + Alpha)画像であり、ストリーミング経由やモバイル端末上でのレンダリングは困難だ。そこで、MSIをRGBAテクスチャを持つLayered Mesh(LM)に変換し、圧縮しやすくすることで解決するという。

最終的に圧縮されたデータは軽量で、モバイルやVR/ARシステム、Webブラウザ上でのレンダリングが可能になる。出力結果はプロジェクトページにて、さまざまなサンプルシーンを閲覧しながらグリグリ移動し、試すことができる。

今後は、カメラリグを増やして視野を360度まで拡張する計画だ。

関連記事

AIで1枚の人物写真から高精細3Dモデル作成 Facebookなど開発

AIで1枚の人物写真から高精細3Dモデル作成 Facebookなど開発

人物の正面からの写真があれば、背後も補完して3Dモデルを生成する夢の技術が開発された。 他人の化粧を自分に転写できるバーチャルメイク技術「PSGAN」 動画にも対応

他人の化粧を自分に転写できるバーチャルメイク技術「PSGAN」 動画にも対応

あの人のお化粧を自分にも、そして動きたい、というニーズに応えられる。 人物のライティングを深層学習で自由自在に メリーランド大とAdobe、Amazonが開発

人物のライティングを深層学習で自由自在に メリーランド大とAdobe、Amazonが開発

将来のLightroom、Photoshopに搭載されるとうれしい機能。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR