見えていない自分の姿勢を推定する「You2Me」 自分視点カメラから深層学習で:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

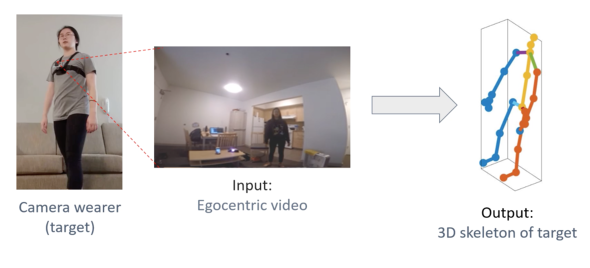

テキサス大学オースティン校、カーネギーメロン大学、Facebook AI Researchによる研究チームが開発した「You2Me」は、カメラ着用者の3次元姿勢を推定する深層学習ベースの手法だ。推定に用いるのは、ユーザーが胸に取り付けた1台のカメラで撮影した一人称視点(FPV)映像だ。

一人称視点映像に記録された自分と相手との動きの相互作用に着目し、カメラ装着者の3次元姿勢を推定する。誰かが握手をしようと手を伸ばしてきたら自分は反射的に握手するために手を伸ばすといった、認知科学の法則を利用している。

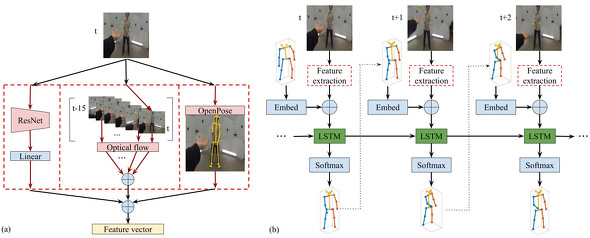

カメラ着用者の3次元関節を予測するために、一人称視点映像から一人称(自分)と二人称(相手)の特徴をRNN(Recurrent Neural Network)を利用して抽出する。

抽出する特徴は3種類。(1)カメラの動きから一人称の動的な特徴を得る。走ったりしゃがんだりするとカメラも動くように、カメラの動きは装着者の姿勢を推定する手掛かりになる。(2)周囲の風景の特徴。立っている・座っているときの視点など、周りの変化を手掛かりにする。(3)二人称の動きの特徴。相手の姿勢と動きを捉える。

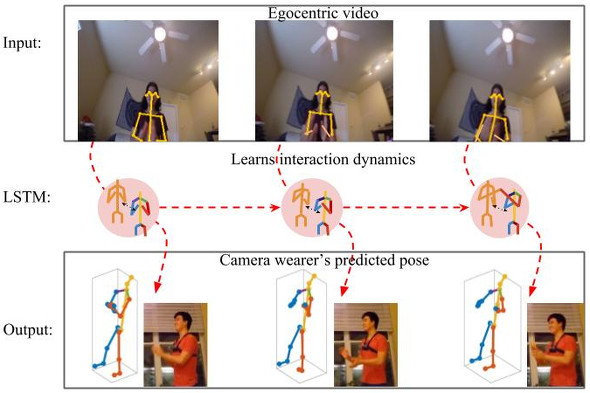

これらの特徴を入力に用いたRNNアーキテクチャであるLSTM(Long short-term memory)で、カメラ装着者、シーン、対話している相手の現在の状態を学習し、カメラ装着者の次の姿勢を予測する。

実験では、会話、スポーツ、手遊び、ボール投げの4つの異なるアクションで3次元姿勢の推定に成功した。特にカメラ装着者がしゃがんだり座ったりするとき、アイテムを受け取るために手を上げたりキャッチしたりするとき、会話でジェスチャーを使っている時は正確に判別する。

カメラには自分の身体がほとんど映っていないにもかかわらず、相手の姿勢が有用な手がかりとなり、一人称の3次元的な動きをカメラの動きとシーンのコンテキストだけで予測できることを実証したとしている。

関連記事

グランツーリスモSPORT最速完走をAIで 達人を凌駕する技術、ソニーなどが開発

グランツーリスモSPORT最速完走をAIで 達人を凌駕する技術、ソニーなどが開発

タイムトライアルを最速で。達人のドライビングテクを学習することで、AIが全ユーザーを抜き去った。 “顔写真の邪魔な影”を後から消せるAI技術 UCバークレーやGoogleなどが開発

“顔写真の邪魔な影”を後から消せるAI技術 UCバークレーやGoogleなどが開発

ライティングに失敗したけど二度と撮れない写真。そんな写真を修復できるかもしれない。 Webカメラ1台で多人数モーションキャプチャーする「XNect」 深度センサーも専用スーツも使わずリアルタイムで

Webカメラ1台で多人数モーションキャプチャーする「XNect」 深度センサーも専用スーツも使わずリアルタイムで

安価なWebカメラで深度センサーや専用スーツを使ったモーションキャプチャーシステムを凌駕する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR