ITmedia NEWS >

企業・業界動向 >

Microsoft、3秒分の音声だけでその人の声を真似るAI「VALL-E」のサンプル公開

» 2023年01月10日 11時36分 公開

[ITmedia]

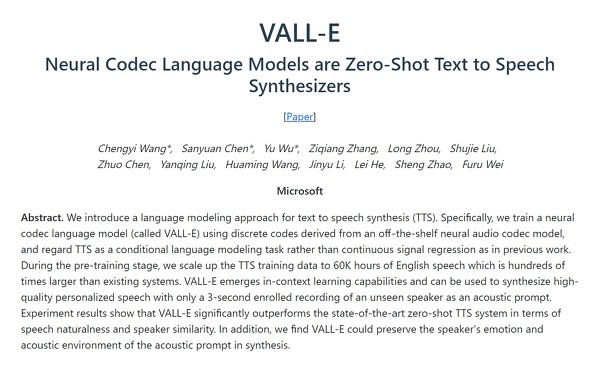

米Microsoftの研究者らは1月5日(現地時間)、人間が話す声の3秒分のデータを与えると、その人のようにテキストを読み上げられるようになるAI「VALL-E」を発表した。GitHubで公開されたサンプルでは、怒りや眠そうな様子などのトーンも追加できている。

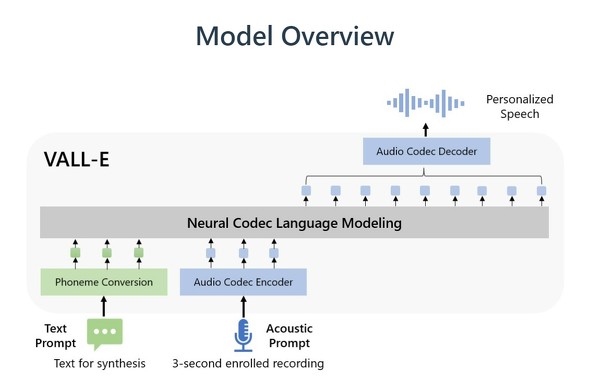

Microsoftが「ニューラルコーデック言語モデル」と呼ぶVALL-Eは、米Metaが昨年10月に発表した「EnCodec」に基づいて構築された。分析した人間の声をEnCodecで個別の「トークン」に分割し、トレーニングデータを使ってトークンを生成するという。

VALL-Eの音声合成機能は、やはりMetaが作成した音声ライブラリ「LibriLight」でトレーニングした。このライブラリには7000人以上の人間による6万時間分の英語音声が含まれている。

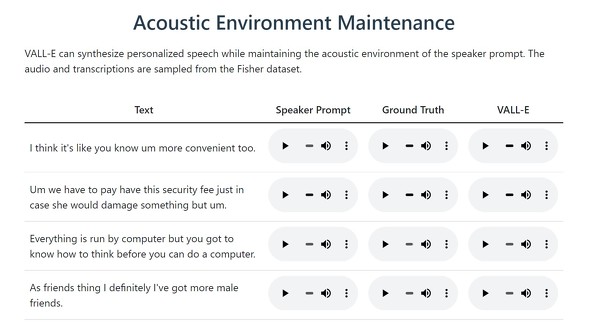

VALL-EのWebサイトのサンプルの、「Speaker Prompt」は与えられた3秒間の音声データ、中央の「Ground Truth」は実際に同じ人間が話したフレーズで、「VALL-E」がVALL-Eが生成した同じフレーズだ。これにより、聴き比べができるようになっている。

この技術をディープフェイク動画と組み合わせると危険なレベルで悪用できそうだ。Microsoftは論文で「VALL-Eは音声によるなりすましなど、潜在的なリスクを伴う可能性がある。そうしたリスクを軽減するために、音声クリップがVALL-Eで合成されたかどうかを識別するモデルを構築することが可能だ。また、モデル開発の際にはMicrosoftのAI原則を順守する」としている。

関連記事

呪文で高精細な3Dアバターを生成するAI「Rodin」 Microsoftが開発

呪文で高精細な3Dアバターを生成するAI「Rodin」 Microsoftが開発

Microsoft Researchに所属する研究者らは、人物の静止画像やテキストプロンプトから高品質な3Dアバターを生成する拡散モデルを提案した研究報告を発表した。 NVIDIAとMicrosoft、「AIクラウドスパコン」で提携

NVIDIAとMicrosoft、「AIクラウドスパコン」で提携

NVIDIAは「AIクラウドスーパーコンピュータ」構築でMicrosoftと提携すると発表した。AzureのインフラとNVIDIAのGPU、ネットワーク、AIソフトを組み合わせる。Azureユーザーは大規模な言語モデルトレーニングなどが可能になるとしている。 「DALL・E 2」採用の新デザインアプリ「Microsoft Designer」無料プレビュー開始

「DALL・E 2」採用の新デザインアプリ「Microsoft Designer」無料プレビュー開始

MicrosoftはOpenAIの画像生成AI「DALL・E 2」採用のWebアプリ「Microsoft Designer」を発表した。テキストと画像を使ってInstagram投稿用コンテンツやパンフレットなどをデザインできる。Bingで無料で使える「Image Creator」も発表した。 AIが生成した“偽音声”を見抜く技術 99%以上の精度で検出

AIが生成した“偽音声”を見抜く技術 99%以上の精度で検出

米フロリダ大学の研究チームは、音声生成モデルで作成された合成音声を見抜く検出器を開発し検証した研究報告を発表した。音声から声の通り道「声道」を作成して、その声道から人の音声か偽物の音声かを識別する。精度は99%以上だという。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR