AIブームで声で人をだます犯罪も増加か 闇サイトでは音声クローンサービス「VCaaS」が台頭:この頃、セキュリティ界隈で

AIを使って音声を合成する音声クローン技術が、人をだましたり偽情報を拡散させたりする目的で悪用される危険が強まっている。闇サイトでは、そうした悪用に手を貸すサービスも台頭しているという。

音声クローンを利用すれば本物そっくりの音声を合成することができ、ディープフェイク動画などと組み合わせて偽情報をもっともらしく見せかけられる。過去にはアメリカのバイデン大統領や女優エマ・ワトソンといった有名人の偽音声が出回ったこともあった。

そうしたツールを使って合成した音声は質が高く、本物か偽物かの区別がつきにくい。有名人の声で差別発言や暴力的な発言を拡散すれば、情報操作や情報かく乱に結び付くこともある。

サイバーセキュリティ企業の米Recorded Futureは、闇サイトでの会話を分析した結果、悪用目的の音声クローン利用に言及する内容が増えていると発表した。簡単に音声を合成できるAIプラットフォームの普及に伴い、それほどのスキルがなくてもサイバー犯罪に参入するのが容易になったという。

特に注目度が高いのは、文章を音声に変換できる米ElevenLabsの音声クローンプラットフォームだ。同製品の有料サービスを利用して、犯罪集団が有名人の音声をアップロードしたり、なりすましなどの犯罪に利用したりしていた形跡もあった。

闇サイトでは音声クローンサービス「VCaaS」が台頭

Recorded Futureによると、闇サイトでは犯罪集団が独自の音声クローンツールを開発して提供する「サービスとしての音声クローン」(Voice Cloning-as-a-Service=VCaaS)も台頭。音声クローンを使った経営者のなりすましや、コールバック詐欺や音声フィッシング詐欺などに利用する手口も話題になっている。

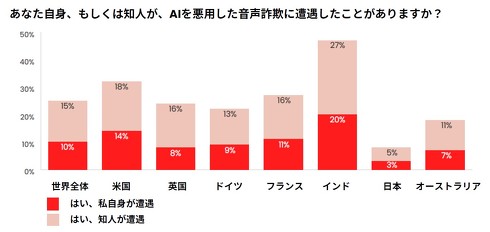

実際、サイバーセキュリティ企業の米McAfeeが日本など7カ国で23年に実施した調査によれば「自分がAI音声詐欺に遭ったことがある」という回答は10%、「知人が詐欺に遭った」という回答は15%に上り、そのうち77%が実際に金銭被害に遭っていた。

「家族や友人を装って助けを求め、金銭をだまし取る特殊詐欺はAI音声クローン技術によってこれまで以上に容易になった」とMcAfeeは見ている。

ただし日本の場合「AI音声詐欺に遭った」という回答は自分が3%、知人が5%にとどまり、7カ国の中では最も少なかった。

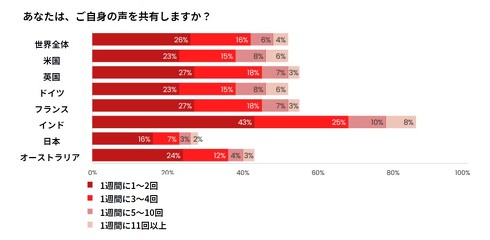

この調査は7カ国で18歳以上の成人7054人を対象に実施。その過半数は、SNSやボイスメモを通じて自分の音声データを週に1回以上ネットで共有しているという。サイバー犯罪者はそうした声をコピーし悪用している。

McAfeeの調査によれば、音声クローンツールを利用することで最大95%の精度で特定の人物の音声を再現できることが分かった。回答者の70%は「本物かどうか識別できるか分からない」または「識別できないと思う」と答えていた。

Recorded Futureは他にも、企業幹部になりすまして従業員や取引先をだまし、多額を送金させる手口に音声クローンを利用する手口や、合成音声を使って銀行の音声による多要素認証を突破できる可能性も指摘している。

関連記事

音声変換した声の“元の声”を復元する技術 中国の研究者らが開発

音声変換した声の“元の声”を復元する技術 中国の研究者らが開発

中国の浙江大学と武漢大学に所属する研究者らは、音声変換技術によって処理した音声から、ソース話者の声紋を復元する手法を提案した研究報告を発表した。 「AIに毒を盛る」──学習用データを改ざんし、AIモデルをサイバー攻撃 Googleなどが脆弱性を発表

「AIに毒を盛る」──学習用データを改ざんし、AIモデルをサイバー攻撃 Googleなどが脆弱性を発表

Google、ETH Zurich、NVIDIA、Robust Intelligenceに所属する研究者らは、学習用データセットの一部を改ざんし、それらを学習した機械学習モデルを攻撃する手法を提案した研究報告を発表した。 ChatGPTは舎弟気質? 「高圧的な命令でマルウェア作成など悪用可能」との指摘 犯罪目的の利用に懸念

ChatGPTは舎弟気質? 「高圧的な命令でマルウェア作成など悪用可能」との指摘 犯罪目的の利用に懸念

多彩さと便利さで話題に事欠かない対話型AIの「ChatGPT」だが、マルウェアの作成やフィッシング詐欺といった犯罪目的で利用される恐れもあると、米国のサイバーセキュリティ企業が警鐘を鳴らしている。 「.zip」ドメイン誰でも登録可能に 悪用の懸念も

「.zip」ドメイン誰でも登録可能に 悪用の懸念も

Googleが一般登録受付を始めたTLD「.zip」や「.mov」について、悪用を懸念する声が出ている。 Google、2年放置のアカウントを削除へ 悪用される危険があるため

Google、2年放置のアカウントを削除へ 悪用される危険があるため

Googleは2年間使われていないGoogleアカウントを削除するようポリシーを改定した。削除されたくない場合は2年に1度はそのアカウントで何らかの操作をする必要がある。実際のアカウント削除は2023年12月から開始する。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR