「AIに毒を盛る」──学習用データを改ざんし、AIモデルをサイバー攻撃 Googleなどが脆弱性を発表:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。Twitter: @shiropen2

米Google、ETH Zurich、NVIDIA、Robust Intelligenceに所属する研究者らが発表した論文「Poisoning Web-Scale Training Datasets is Practical」は、学習用データセットの一部を改ざんし、それらを学習した機械学習モデルを攻撃する手法を提案した研究報告である。

機械学習モデルの学習用データセットには、インターネットをクロールして収集した大量のデータサンプルが含まれるWebスケールデータセットがある。だが、これらの収集したデータの信頼性が保証されているわけではない。信頼性を保証するには、手作業でデータを収集して各サンプルの品質を保証しなければならないが、大規模になるとほぼ不可能である。

この研究では、学習データセットに使われる前にデータへ毒(悪意ある改ざん)を仕込み、それらを学習した機械学習モデルを攻撃する手法を提案する。このような攻撃を「データポイズニング」(Data poisoning)と呼び、攻撃者がデータセットを操作して機械学習モデルをだます。

例えば、人種差別や性差別などのバイアスを悪化させたり、モデルに何らかのバックドアを埋め込んで学習後のモデルの動作を制御したりすることを可能にする。

今回は2種類のデータポイズニング攻撃(Split-view data poisoningとFrontrunning data poisoning)を紹介する。

1つ目の攻撃(Split-view data poisoning)では、大規模データセット(LAION-400Mなど)を対象とし、データセット管理者が収集時に見たデータと、エンドユーザーが学習時に見たデータが(有意かつ任意に)異なる場合があるという事実を利用するもの。

具体的には、攻撃者が期限切れのドメインをいくつか購入し、Webサイト内を変更することで攻撃を行う。この攻撃は、ドメインネームシステム(DNS)が特定の個人や組織にドメインの永久的な所有権を与えるのではない事実に基づいており、期限切れのドメインに内在する信頼を悪用するというものである。

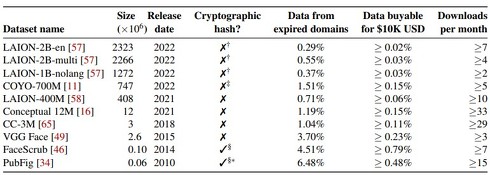

実験では、10種類の一般的なWebスケールデータセットを用い、この攻撃の実現可能性を実際に調査した。その結果、60米ドル程度で2022年にLAION-400MまたはCOYO-700Mデータセットの0.01%に毒を注入することに成功した。

2つ目の攻撃(Frontrunning data poisoning)では、ユーザーが作成したコンテンツの定期的なスナップショットからなる一般的なデータセットを利用するというもの。ここでいうデータセットの代表的なのは、Wikipediaである。

WikipediaのようなWebサイトでは、データのクロールを阻止するために、コンテンツのスナップショットを直接ダウンロードできるようにしている。攻撃者としては、スナップショットに含まれる前に、Wikipediaの記事に対して悪意ある修正を行って毒を盛ることができる。

Wikipediaは、この攻撃に限らず、悪意ある編集が行われると短い時間で修正される。短時間で修正されると攻撃が成り立たないため、この攻撃では修正される前にスナップショットされるタイミングを予測して適切な時期に修正を行う。各Wikipedia記事のスクレイピング時間を予測してピンポイントで攻撃するわけだ。

データセットに毒を盛ることは、たとえデータのごく一部に影響を与えたとしても、機械学習モデルに大きな影響を与える可能性がある。例えば、良性ラベルが付いた画像全ての一部(右下など)に小さなマークを追加したとする。すると、機械学習モデルはそのマークが付いた画像を良性と判断するようになり、バックドアのように攻撃者に後から制御されてしまう。

研究チームは、今回の結果を踏まえ、データポイズニング攻撃を防ぐための緩和策を提案している。例えば、画像やその他のコンテンツが事後的に切り替えられないようにする「データインテグリティ」を実行するなどである。

Source and Image Credits: Carlini, Nicholas, et al. “Poisoning Web-Scale Training Datasets is Practical.” arXiv preprint arXiv:2302.10149(2023).

関連記事

スマートテレビのリモコン操作から個人情報を盗み出す攻撃 屋内のIoTエアコンなどを悪用

スマートテレビのリモコン操作から個人情報を盗み出す攻撃 屋内のIoTエアコンなどを悪用

香港中文大学などに所属する研究者らは、スマートテレビを操作する家庭用の赤外線(IR)リモコンからIR信号を取得し、機密情報を抽出する攻撃を提案した研究報告を発表した。 ChatGPTに詐欺メールの相手をさせたら? 最大18回のやりとりを記録 詐欺師の時間の浪費に成功

ChatGPTに詐欺メールの相手をさせたら? 最大18回のやりとりを記録 詐欺師の時間の浪費に成功

イタリアのNational Research Council of Italyに所属する研究者らは、詐欺師が送る詐欺メールとのやりとりをChatGPTにしてもらったらどうなるかを検証した研究報告を発表した。 YouTubeで“聞こえない音”を流し、スマホを遠隔操作する攻撃 音声アシスタント機能を悪用

YouTubeで“聞こえない音”を流し、スマホを遠隔操作する攻撃 音声アシスタント機能を悪用

米テキサス大学サンアントニオ校と米コロラド大学コロラドスプリングス校に所属する研究者らは、スマートフォンやスマートスピーカーの音声アシスタント(Siri、Google Assistant、Alexa、Cortana)に対する不可聴攻撃を提案した研究報告を発表した。 QRコードにレーザーを当てて「偽装QRコード」に変える攻撃 悪性サイトに誘導 東海大が発表

QRコードにレーザーを当てて「偽装QRコード」に変える攻撃 悪性サイトに誘導 東海大が発表

東海大学に所属する研究者らは、QRコードへのレーザー照射により、任意のタイミングで悪性サイトへ誘導可能な偽装QRコードを生成する方法を提案した研究報告を発表した。 テスラを15秒で乗っ取る攻撃 ドライバーに気付かれずドアを開け、運転まで 専用キーに脆弱性

テスラを15秒で乗っ取る攻撃 ドライバーに気付かれずドアを開け、運転まで 専用キーに脆弱性

中国のShanghai Fudan Microelectと復旦大学に所属する研究者らは、Tesla Model 3のキーカードとフォンキーの脆弱性を利用し、ドアのロック解除から運転までを可能にした研究報告を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR