革命かパンドラの箱か、新AIツールGPT-3の波紋:星暁雄「21世紀のイノベーションのジレンマ」(3/5 ページ)

GPT-3は大規模化を追求した「言語モデル」

GPT-3の正体を一言で説明するなら、「テキスト生成のための巨大な学習済みモデルを備えているAIツール」だ。GPT-3の特徴は、とにかく規模が巨大なことだ。

OpenAIの開発者らは論文中で、GPT-3を「1750億のパラメータ(変数)を持つ自己回帰型言語モデル」と呼んでいる。また機械学習のため、Webサイトから数年にわたり収集した1兆語におよぶデータセットを用いている。

かみ砕いて説明すると、こうなる。1兆語から成るきわめて巨大な例文集を元に、1750億種類の変数を持つ「言語モデル」に言葉と言葉の関連の度合いを記憶させておく。この「言語モデル」に対して「数種類の実例と課題文」を与えると、それらしい文章を出力する。これがGPT-3の動作だ。GPT-3は学習した大量の文章のパターンの中から最も「それらしい」回答を返すだけなのだが、データセットと言語モデルが巨大なため多様な応用が可能で、多くの人々を驚かせた。

GPT-3のすべてが公開されているわけではない。GPT-3の本体といえる「言語モデル」そのものは非公開で、「数種類の実例と課題文(タスク)」をインプットして文章をアウトプットするインタフェース(API)が公開されているだけだ。それも現時点では申し込み制で外部の開発者向けに公開している段階だ。今後は、有償サービスとして利用可能にしていく方向性ということだ。「言語モデル」そのものを公開しない理由のひとつは、後述する危険性が懸念されているからである。

GPT-3の規模は、AIプロジェクトのチャンピオン級

GPT-3の狙いは、「AIの言語モデルを大規模にすることで何ができるか」を確かめることにある。その規模の度合いはどれほどのものなのかを見ていこう。

GPT-3については、75ページにおよぶ論文"Language Models are Few-Shot Learners"が発表されている。この論文は開発者らが執筆した第一次資料だ。これを手がかりに見ていこう。

GPT-3のモデルのサイズは複数あり、その最大のモデル(1750億パラメータ)を学習させるための計算量は、"3640 petaflop/s-day"である。"petaflop/s-day"とはAI分野特有の単位で、「1秒間に1ペタ(10の15乗)回のニューラルネット上の演算操作を、1日分行った計算量」という意味である(OpenAIによる説明)。

GPT-3の最大モデルの学習に要した計算量3640 petaflop/s-dayは、毎秒1ペタ回のニューラルネット演算をほぼ10年にわたり実施した計算量に相当する。Googleが18年に発表したAIチップ「第3世代TPU」を約1000個搭載した「ポッド」(ラックの集まり)は100ペタFLOPSの性能を発揮するといわれている。この「ポッド」を37日間占有して計算させれば、GPT-3の言語モデルを学習させる計算量に相当することになる。第一線級のAI企業でなければ手を出しづらい水準だといえるだろう。

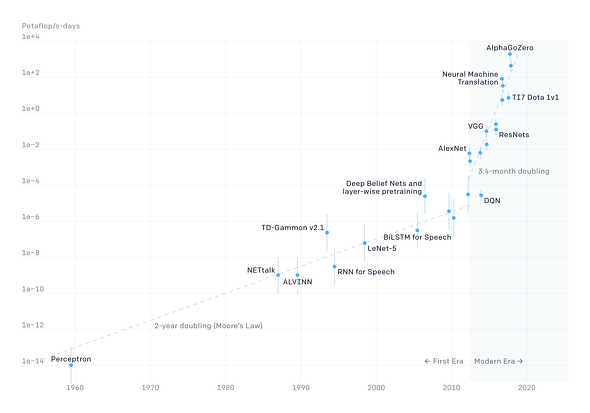

各種AIプロジェクトの計算量をグラフにしたもの。縦軸は計算量(単位のpetaflop/s-dayについては本文を参照)、横軸は年代。縦軸は1目盛りごとに計算量が10倍になっている。2012年頃から計算量の増加ペースが急増している

各種AIプロジェクトの計算量をグラフにしたもの。縦軸は計算量(単位のpetaflop/s-dayについては本文を参照)、横軸は年代。縦軸は1目盛りごとに計算量が10倍になっている。2012年頃から計算量の増加ペースが急増しているGPT-3の計算量の「規模感」をつかむ別の材料がある。このグラフを見ていただきたい。これはOpenAIのBlog記事"AI and Compute"から引用したものだが、12年頃からAIプロジェクトの計算量が急増していることを示している。

それまでは「2年で2倍」程度のペースだったが(これも十分に急激な指数関数的増加といえる)、12年頃から「3.4カ月で2倍」というきわめて急な指数関数的増加となった。その背後には、GoogleのAI専用チップ「TPU」のような技術革新があった。この増加ペースを見ると、GPT-3の3640 petaflop/s-dayという計算量は現代的な水準といえるものの、グラフを見ればより大きな計算量を投入したAIプロジェクトが進行中である可能性もある。例えば、Google子会社DeepMindが発表した囲碁AI「AlphaGo Zero」は、17年の時点でGPT-3と同程度の計算量を投入しているようにグラフ中で描かれている。今後はさらに人々を驚かせる別のAIツールが登場するかもしれない。

今までの説明はGPT-3の言語モデルを学習させるための計算量について見てきたが、当然ながらGPT-3を利用する場合の計算量ははるかに小さくなる。とはいえ、GPT-3の開発者らは、論文の中で「最大のモデル(1750億パラメータ)を使う場合、100ページのコンテンツを生成するのに、0.4キロワット時のエネルギー消費が必要」と説明している。これはかなりの電力食いといえる。

関連記事

Facebookのヘイト対策に「大穴」 〜ザッカーバーグの矛盾とは〜

Facebookのヘイト対策に「大穴」 〜ザッカーバーグの矛盾とは〜

米国で、Facebookにとって手痛い内容の報告書が公表された。報告書は、この2020年11月に米大統領選挙が控えている中で、差別問題やヘイトスピーチに対するFacebookの取り組みがまだ不十分であり、しかも「大穴」が空いていることを指摘している。 知られざる世界最重要企業 Appleチップを生産するTSMC

知られざる世界最重要企業 Appleチップを生産するTSMC

AppleがIntelチップの採用をやめる。背後には、Intelがもはや世界一の半導体製造技術を持つ会社ではなくなり、最新の半導体製造技術はTSMCが持っているという事実があった。そのTSMCは、今や世界で最も重要な企業の1社なのである。 インドのTikTok禁止と表現の自由

インドのTikTok禁止と表現の自由

インド政府が、動画投稿アプリTikTokをはじめ59種類の中国製スマートフォンアプリの利用を禁じた。インド政府の命令に従い、AppleとGoogleはスマートフォン向けアプリストアから問題とされたアプリを取り下げた。TikTokもサービス提供を中止した。この事件は、単なる2国間の対立というだけでは収まらない問題を含んでいる。インターネット上の人権――表現の自由――という新しい概念と、国家の利害とが衝突しているのだ。 「顔認識技術を禁止せよ」 黒人差別を受けハイテク大手の対応は?

「顔認識技術を禁止せよ」 黒人差別を受けハイテク大手の対応は?

米国で顔認識技術への批判が強まっている。IBM、Amazon、Microsoftが相次いで、警察など法執行機関への顔認識技術の提供を中止すると発表した。以前から顔認識技術は「人種差別、性差別を助長する」との批判があった。事件を機に大手テクノロジー企業が顔認識技術の提供中止に追い込まれた形だ。 木村花さん事件とトランプ対Twitterと「遅いSNS」

木村花さん事件とトランプ対Twitterと「遅いSNS」

(1) 世界の国々はSNS(ソーシャルネットワーク)規制で悩んでいる。(2) SNS規制には副作用があり、複数の視点から考える必要がある。(3) 英国の提言の中で「SNSで議論を遅くする仕組みを作れ」という意表を突く指摘がある。複雑だが、重要な話だ。今こそSNS規制を考える時だ。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR注目記事ランキング