液浸スパコン「kukai」を使って、Yahoo!知恵袋の“クソリプ”を検出してみた:ディープラーニング活用事例(2/2 ページ)

確かに、情報を持続させることができるよう内部にループ構造を持たせたRNNは、コンテクスト(文脈)を勘案すべき対話解析に向く。しかし、効率的にデータを学習させようとするならば、教師データ(ここでは不適切な質問や回答だと人間が判断したデータのリスト)が必要だ。「このリストを作成するのは骨が折れる作業で、せいぜい5000から1万くらいを作るのがやっとでした。しかし、これだけでは高い精度を得るのが難しかったのです」と清水氏は振り返る。

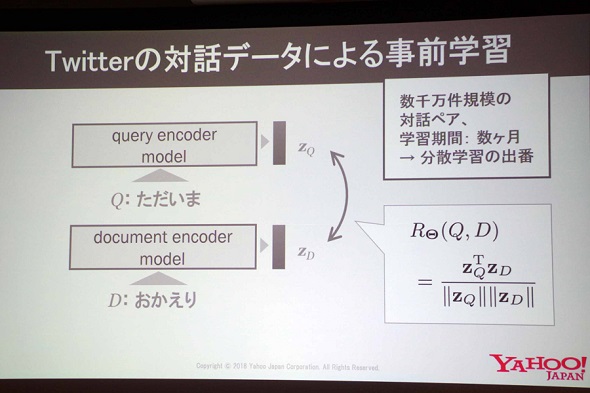

そこで、清水氏らはTwitterにある数千万件規模の対話ペア(元ツイートとリプライのセット)のデータを使い、「提示された質問文に対して、5つの選択肢から適切な回答を選択できる」学習モデルを作成。その学習モデルを基に、改めて教師データを使って学習を行うことで精度を飛躍的に高めることができたという。

「深層学習における言語理解は、ラベル付きデータだけで学習させるのは非常に厳しいものがあります。Twitterで行われる対話は感情を踏まえたやりとりであるため、テキストの裏にある感情を踏まえた回答を生成できるモデルを作れるのが特徴で、事前学習用のデータに向いています」(清水氏)

Twitter対話のデータからモデルを作成するのには、4台のサーバで数カ月かかったとのことだが、現在はkukaiを使ってチューニングを行っているそうだ。CPUベースのサーバとGPUベースのkukaiを比べると処理能力の差は歴然だと清水氏は話す。

「Yahoo!知恵袋に投稿された質問と回答の全6億件に対し、不適切なものかどうかを推論する演算を行った場合、CPUベースのサーバでは「約9カ月かかる」という見積もりが出たのに対し、kukaiでは半分のリソースしか使わなくても1日半で終えられました。kukaiによって検出された不適切な(ものと思われる)投稿については、Yahoo!知恵袋のトップページ内のランキングなど、多くの人の目につきやすい箇所では非表示にするようにしています」

この自然言語処理の能力は、不適切な投稿を検出する以外にも、検索クエリのジャンルを推定するなど、さまざまな用途で使える可能性があるという。角田氏によれば、「液浸冷却型のスーパーコンピュータは学術利用が中心で、ビジネスの現場に導入されている例は非常に少ない」という。kukaiの活躍が、企業におけるスパコン利用の新たな道を切り開く可能性は十分にあるだろう。

関連記事

インフルエンザを診断するAI、ディープラーニングで実現へ 医療機器ベンチャー「アイリス」の挑戦

インフルエンザを診断するAI、ディープラーニングで実現へ 医療機器ベンチャー「アイリス」の挑戦

タイミングの制限があり、精度もそこまで高くはないインフルエンザの初期診断。これをディープラーニングで支援できないか、と挑むベンチャー企業がある。 680億PVのヤフーを支えるDWH活用、14年の歴史の“裏側”

680億PVのヤフーを支えるDWH活用、14年の歴史の“裏側”

100以上のサービスを展開し、月間680億PVの巨大ポータルサイト「Yahoo! JAPAN」。そこで得られる膨大なデータを蓄積するデータ分析基盤はどうなっているのか。その全貌と苦労の歴史、そして“よりよい分析環境”を作るために意識していることを聞いた。 “爆速×ビッグデータ”でヤフーが実現したこと

“爆速×ビッグデータ”でヤフーが実現したこと

月に580億ものページビューを叩き出す巨大サイト「Yahoo! JAPAN」。そこで収集、蓄積された“ビッグデータ”を効果的に活用して、ビジネスに貢献しようと日夜奮闘するデータ専門部隊がある。 スパコン初心者のヤフーが省エネ性能世界2位の「kukai」を作るまで

スパコン初心者のヤフーが省エネ性能世界2位の「kukai」を作るまで

2017年6月に発表されたヤフーのスーパーコンピュータ「kukai」。省エネ性能世界2位を誇り、より大規模なディープラーニング処理を従来より低コストで行える。しかしヤフーは、もともとスパコンを作るつもりではなかったという。 ヤフーがスパコン「kukai」開発 ディープラーニングに特化 世界2位の省エネ性能

ヤフーがスパコン「kukai」開発 ディープラーニングに特化 世界2位の省エネ性能

ヤフーが、スーパーコンピュータ「kukai」(クウカイ)の開発を発表。短時間・低コストで、大規模なディープラーニング処理が可能だという。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 500万件のWebサーバでGit情報が露出 25万件超で認証情報も漏えい

- 一気読み推奨 セキュリティの専門家が推す信頼の公開資料2選

- 中国電力、RAGの限界に直面し“電力業務特化型LLM”の構築を開始 国産LLMを基盤に

- 「SaaSの死」騒動の裏側 早めに知るべき“AIに淘汰されないSaaS”の見極め方

- NTTグループは「AIがSI事業にもたらす影響」をどう見ている? 決算会見から探る

- 2025年、話題となったセキュリティ事故12社の事例に見る「致命的なミス」とは?

- LINE誘導型「CEO詐欺」が国内で急増中 6000組織以上に攻撃

- 「年齢で落とされる」は6割超 シニアエンジニアが直面する採用の壁と本音

- なぜ日本のITエンジニアは優遇されない? 「世界給与ランキング」から見えた課題

- 年収1000万を超えるITエンジニアのキャリアは? 経験年数と転職回数の「相関関係」が明らかに

ヤフー データ&サイエンスソリューション統括本部 事業開発本部 技術戦略室 清水徹氏

ヤフー データ&サイエンスソリューション統括本部 事業開発本部 技術戦略室 清水徹氏