「生成AI」のリスクを法制度から考える――国立情報学研究所の講演から探る:Weekly Memo(2/2 ページ)

個人情報・プライバシーや有害情報にどう対処するか

生貝氏は著作権の論点について、上記の3点に加えて気になるポイントを幾つか挙げた。その中に興味深い内容があったのでピックアップしておこう。

同氏が挙げたのは、「文章系生成AIの回答がメディアの記事などのクリックを不要にすることの影響」だ。どういうことか。同氏は次のように説明した。

「これまで使われてきた検索が、生成AIに徐々に取って代わられようとしている。この現象に対し、記事を掲載しているメディアが世界的に強い警戒感を示している。なぜか。検索エンジンは基本的にクリックしてもらうことを前提に作られている。その結果、メディアは広告や購読によって収入を得るビジネスモデルを成り立たせている。しかし、生成AIのように学習して結果を出す形だと、クリックする必要はない。となると、これまでのビジネスモデルが成り立たなくなる。この変化についても今後大きな論点になっていくだろう」

メディアにとっては著作権もさることながら、ビジネスモデルが成り立たなくなる死活問題だ。さらにメディアだけでなく、広告モデルを主体としてきたネットビジネス全体に大きな影響を及ぼすのではないか。

次に、生貝氏が生成AIのリスクとして2つ目に挙げた個人情報・プライバシーに話を移そう。同氏はその「指示段階」「学習段階」「出力段階」においてのそれぞれの論点を次のように説明した。

指示段階では、個人に関する情報のプロンプト入力についてが論点になる。「例えば、『この顧客データのリストを分かりやすく整理して出力してほしい』とデータとともに入力してしまうと、これは生成AIに対して個人情報を第三者提供した形になる」(生貝氏)

学習段階では、特に病歴などの要配慮個人情報の学習利用についてが論点になる。「要配慮個人情報については、取得に際して本人の同意が必須といった厳格な取り扱いが求められる」(生貝氏)

出力段階では、学習した個人情報を出力してしまう可能性があることだ。「例えば、電子メールアドレスのリストが流出したケースは既に見かける。これが個人の信用情報までも対象になってくると、非常にリスクの高い状態になってしまう」と同氏は警鐘を鳴らした。

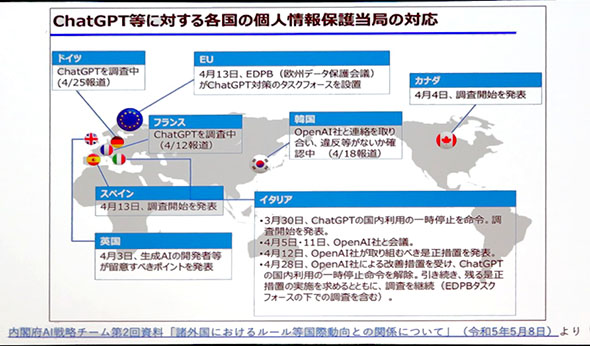

ちなみに、生成AIに対する世界各国の個人情報保護当局の対応について、生貝氏は図1を示して説明した。各国の当局がこの4月から動き出していることが分かる。

最後に、生成AIのリスクの3つ目となる有害情報の論点について。有害情報とは誤情報や偽情報、バイアスがかかった情報のことを指す。これについて生貝氏は次のように説明した。

「有害情報については法制度の観点からいうと、それ自体が違法かどうかは慎重な対応が求められる。例えば、何かに対して悪意を感じさせる文章を法律によって取り締まることについては、少なくとも西側諸国においては認められていない。しかし、何らかの対応が必要だというコンセンサスができつつあるので、直接の法的な対応ではないものの、例えば日本ではファクトチェックをしっかりやるとか、リテラシーの向上を図っていくといった取り組みが大事になってくるだろう」

有害情報における法的な対応については、慎重さが感じられた。おそらく表現の自由との線引きが難しいのだろう。民主主義は手間がかかるということだ。

以上が、生貝氏の講演から抜粋した内容だ。生成AIのリスクについては先にG7広島サミットにも触れたが、日本政府も積極的な対応を見せている。ただ、報道機関としてはその動きも注意深く見ていく責務があろう。今回の生貝氏の講演を取材して、改めて生成AIのインパクトの大きさを感じた。

(注1)NIIオープンハウス 2023

著者紹介:ジャーナリスト 松岡 功

フリージャーナリストとして「ビジネス」「マネジメント」「IT/デジタル」の3分野をテーマに、複数のメディアで多様な見方を提供する記事を執筆している。電波新聞社、日刊工業新聞社などで記者およびITビジネス系月刊誌編集長を歴任後、フリーに。主な著書に『サン・マイクロシステムズの戦略』(日刊工業新聞社、共著)、『新企業集団・NECグループ』(日本実業出版社)、『NTTドコモ リアルタイム・マネジメントへの挑戦』(日刊工業新聞社、共著)など。1957年8月生まれ、大阪府出身。

関連記事

- 「Weekly Memo」記事一覧

アクセンチュアは「ジェネレーティブAI」をどう見るか 中小企業のための“健保”方式を提案してみた

アクセンチュアは「ジェネレーティブAI」をどう見るか 中小企業のための“健保”方式を提案してみた

今、話題沸騰の「ChatGPT」をはじめとするジェネレーティブAIは、ビジネス活用においてどんな可能性があるのか。一方で、リスクとその対策とは。アクセンチュアの説明から考察する。 AIがもたらす「正解のない産業革命」を生き抜くための要件 ガートナーの提言から考察

AIがもたらす「正解のない産業革命」を生き抜くための要件 ガートナーの提言から考察

「ChatGPT」などの登場によって注目を集めるAIは、新たな産業革命をもたらすとの見方もある。企業はこの技術をどう活用すべきか。ガートナーの亦賀忠明氏の話から考察した。 生成AIをどうサイバー防御に生かすか 有効策をセキュリティ専門家が提言

生成AIをどうサイバー防御に生かすか 有効策をセキュリティ専門家が提言

生成AIは技術的な革新であり、多くの企業が有効に活用する方法を模索している。セキュリティにおいてもそれは同様だ。攻撃・防御側それぞれでどのような使い方が考えられるか。 ミッコ・ヒッポネン氏が語る、AIへの“期待”と“リスク”

ミッコ・ヒッポネン氏が語る、AIへの“期待”と“リスク”

セキュリティリサーチャーのミッコ・ヒッポネン氏は、AIが破壊的な進歩する現状を「史上最高に熱いAIの夏」と表現した。同氏はAIにどのような期待を寄せつつ、どのようなリスクを懸念しているのか。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- Claude拡張機能にCVSS10.0の脆弱性 現在も未修正のため注意

- ホワイトハッカーが明かす「ランサムウェア対策が破られる理由」と本当に効く防御

- 7-Zipの偽Webサイトに注意 PCをプロキシノード化するマルウェア拡散

- 2026年はAGIが“一部実現” AIの革新を乗りこなすための6つの予測

- 一気読み推奨 セキュリティの専門家が推す信頼の公開資料2選

- 「SaaSの死」騒動の裏側 早めに知るべき“AIに淘汰されないSaaS”の見極め方

- 米2強が狙う“AI社員”の普及 Anthropicは「業務代行」、OpenAIは「運用プラットフォーム」

- Fortinet、管理サーバ製品の重大欠陥を公表 直ちにアップデートを

- NTTグループは「AIがSI事業にもたらす影響」をどう見ている? 決算会見から探る

- LINE誘導型「CEO詐欺」が国内で急増中 6000組織以上に攻撃